Negli ultimi anni, l’intelligenza artificiale vocale è passata da essere una tecnologia interessante per demo o applicazioni consumer a un elemento strategico per molte aziende. Interazioni automatizzate, assistenti virtuali e servizi di customer care basati sulla voce rappresentano oggi strumenti concreti per migliorare efficienza operativa e soddisfazione del cliente, ma la loro adozione su larga scala porta con sé sfide precise, non solo tecniche ma soprattutto legate alla governance, alla conformità normativa e alla sicurezza dei dati. Un recente articolo mette in luce un punto cruciale di questo cambiamento: nella scelta delle tecnologie di voice AI per usi aziendali, non è tanto la qualità del modello che fa la differenza, quanto piuttosto l’architettura complessiva del sistema e il modo in cui essa risponde ai vincoli operativi e normativi richiesti dalle imprese.

Questa riflessione nasce da un’analisi della progressiva frammentazione del mercato dell’intelligenza artificiale vocale da parte delle aziende, dove si delineano ormai percorsi tecnologici ben distinti, ciascuno con compromessi differenti tra velocità di risposta, controllo sui dati gestiti e costi operativi. Storicamente, le decisioni su quale tecnologia di speech-to-speech adottare erano spesso guidate da metriche legate alle performance del modello stesso: quanto naturale appare la voce generata, quanto accurata è la comprensione del linguaggio, quanto fluida sembra la conversazione. Tuttavia, con l’ingresso di queste tecnologie in contesti regolamentati come la sanità o il settore finanziario, l’adozione su larga scala ha messo in evidenza che la sola eccellenza del modello non garantisce il controllo sui processi né la conformità alle normative.

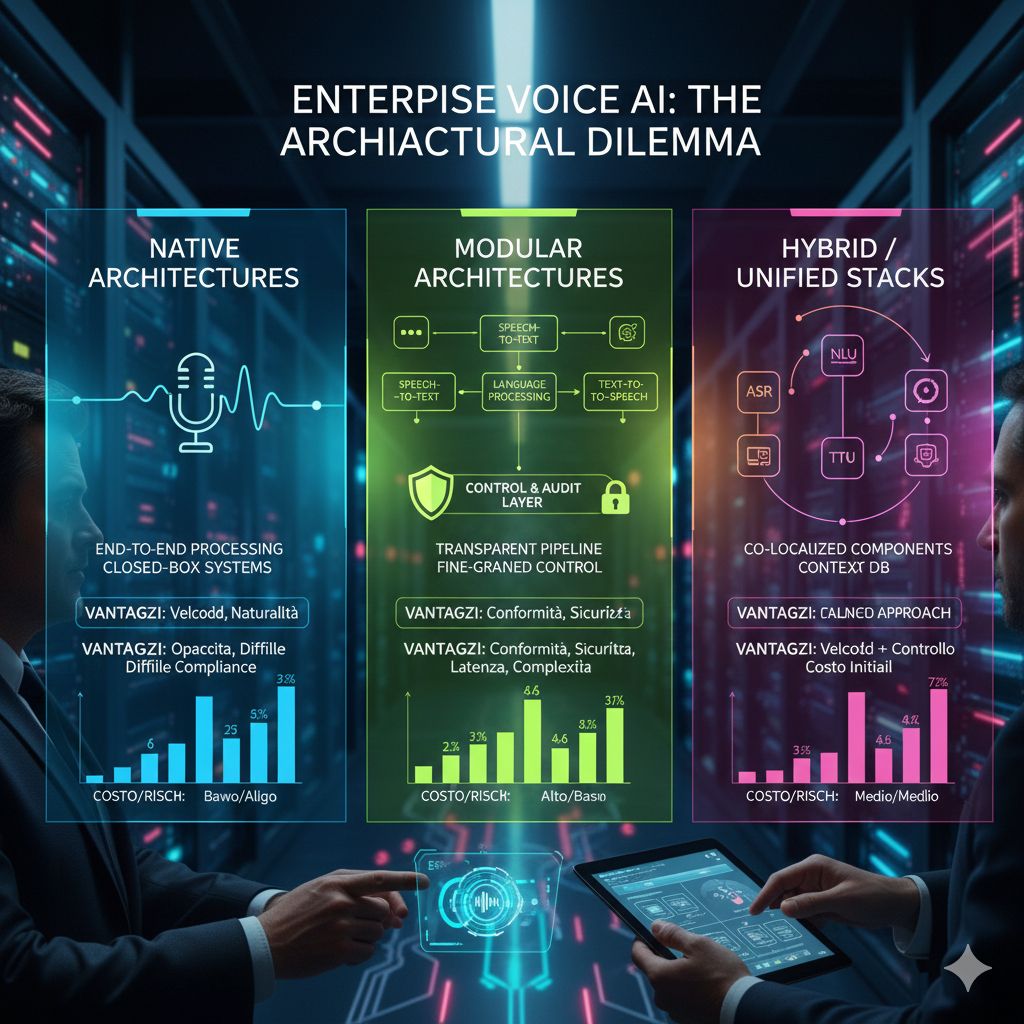

Il mercato enterprise si è così consolidato attorno a tre principali architetture tecniche, ognuna delle quali è stata ottimizzata in funzione di obiettivi diversi. Le tecnologie più “native”, che elaborano audio in modo end-to-end per preservare al massimo elementi paralinguistici come tono, pause o esitazioni, offrono reattività e naturalità nella conversazione, ma restano spesso emanazioni opache di sistemi chiusi che non consentono alle aziende di analizzare e intervenire sui passaggi intermedi. Questo approccio può andare bene per scenari ad alto volume e basso rischio dove la velocità e l’esperienza utente sono prioritari, ma diventa problematico quando si tratta di rispettare rigorosi requisiti di audit o di garantire che informazioni sensibili non vengano processate in modo non conforme.

All’altro estremo si trovano le architetture “modulari”, in cui il processo vocale è suddiviso in componenti distinte, come speech-to-text, elaborazione del linguaggio e sintesi vocale, con un livello testuale di controllo che si frappone tra l’ingresso audio dell’utente e la risposta vocale finale. Questo tipo di design offre maggiore trasparenza e possibilità di intervento: ogni fase può essere ispezionata, loggata e sottoposta a politiche di sicurezza specifiche, come la rimozione di dati personali in flight, l’iniezione di conoscenza di dominio o la supervisione umana nei casi critici. In settori come quello sanitario o finanziario, dove la normativa impone tracciabilità e auditabilità, una pipeline modulare fornisce strumenti essenziali per conformarsi alle regole e gestire la responsabilità operativa.

Tra questi due poli si inserisce un’evoluzione tecnologica che cerca di combinare i vantaggi di entrambi: architetture modulari co-localizzate o unified stacks in cui le componenti che un tempo comunicavano su reti esterne sono integrate su cluster condivisi, riducendo la latenza e avvicinando il tempo di risposta a quello dei modelli nativi, ma mantenendo sempre un livello di controllo e supervisione sulle singole fasi del processo. Questo tipo di architettura mira a offrire il meglio dei due mondi: la rapidità e la naturalezza della comunicazione vocale insieme alla possibilità di rispettare requisiti di audit e di compliance, cosa che diventa determinante in applicazioni regolate.

Un altro aspetto sottolineato dall’analisi è come questa scelta architetturale si rifletta direttamente sui costi e sulla scalabilità delle soluzioni adottate. Modelli con elaborazione nativa possono risultare più economici in termini di tecnologia raw, soprattutto per flussi di lavoro ad alto volume e basso margine, dove gli utenti non richiedono elevato livello di supervisione sui risultati. Al contrario, architetture modulari, seppur più costose da implementare e gestire, offrono la possibilità di costruire tracce dettagliate di tutte le operazioni, una caratteristica fondamentale per le aziende che devono dimostrare conformità a normative come HIPAA o altre regolamentazioni sulla protezione dei dati.