Facebook ha sempre chiarito che vuole che l’intelligenza artificiale gestisca più doveri di moderazione sulle sue piattaforme. Oggi ha annunciato il suo ultimo passo verso tale obiettivo: affidare all’apprendimento automatico la responsabilità della coda di moderazione.

Ecco come funziona la moderazione su Facebook. I post che si ritiene violino le regole dell’azienda (che includono tutto, dallo spam all’incitamento all’odio e ai contenuti che “glorifica la violenza”) vengono contrassegnati dagli utenti o dai filtri di apprendimento automatico. Alcuni casi molto chiari vengono gestiti automaticamente (le risposte potrebbero comportare la rimozione di un post o il blocco di un account, ad esempio) mentre il resto viene messo in coda per la revisione da parte di moderatori umani.

Facebook impiega circa 15.000 di questi moderatori in tutto il mondo ed è stato criticato in passato per non aver fornito a questi lavoratori un sostegno sufficiente, impiegandoli in condizioni che possono portare a traumi . Il loro compito è ordinare i post contrassegnati e decidere se violare o meno le varie politiche dell’azienda.

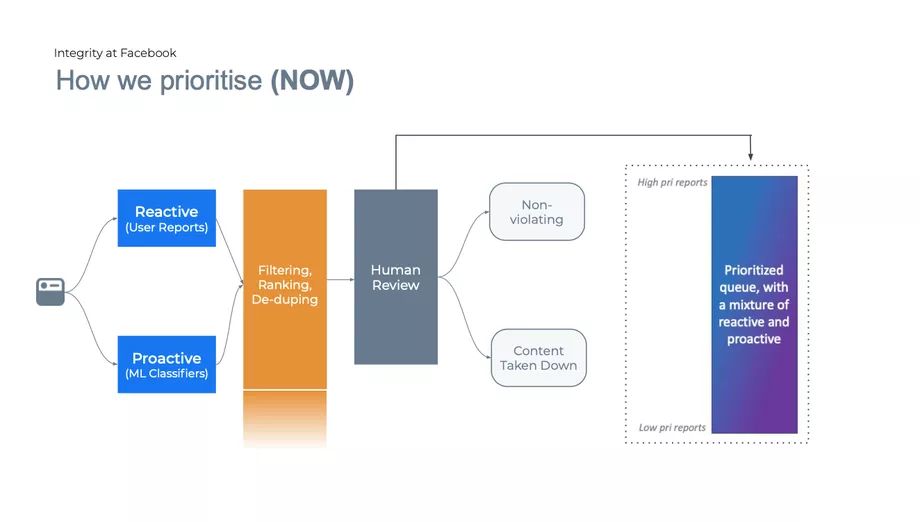

In passato, i moderatori esaminavano i post in modo più o meno cronologico, trattandoli nell’ordine in cui venivano riportati. Ora, Facebook afferma di voler assicurarsi che i post più importanti vengano visualizzati per primi e utilizza l’apprendimento automatico per aiutare. In futuro, verrà utilizzato un amalgama di vari algoritmi di apprendimento automatico per ordinare questa coda, dando la priorità ai post in base a tre criteri: la loro viralità, la loro gravità e la probabilità che stiano infrangendo le regole.

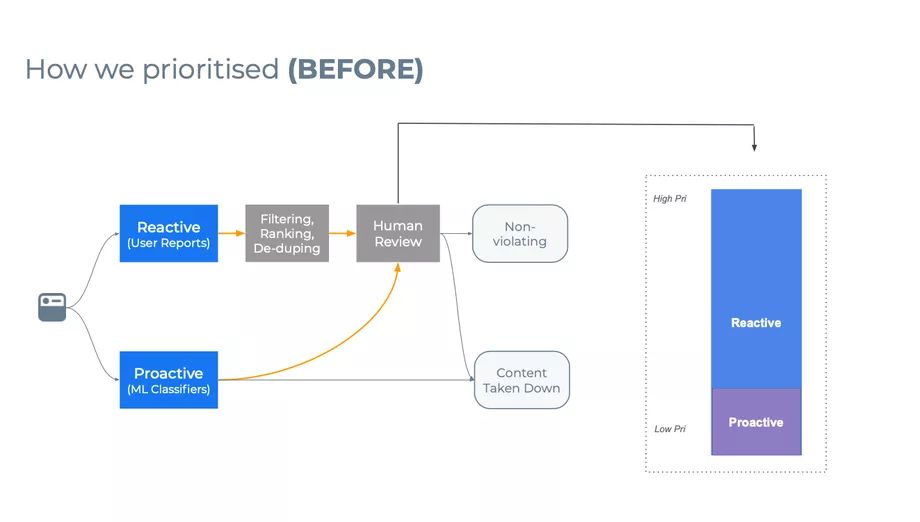

Il vecchio sistema di moderazione di Facebook, che combina la moderazione proattiva con filtri ML e rapporti reattivi degli utenti di Facebook. Immagine: Facebook

Il nuovo flusso di lavoro di moderazione, che ora utilizza l’apprendimento automatico per ordinare la coda di post per la revisione da parte dei moderatori umani. Immagine: Facebook

Non è chiaro come vengano ponderati esattamente questi criteri, ma Facebook afferma che l’obiettivo è quello di affrontare prima i post più dannosi. Quindi, più un post è virale (più viene condiviso e visto) più velocemente verrà gestito. Lo stesso vale per la gravità di un post. Facebook afferma di classificare i post che comportano danni nel mondo reale come i più importanti. Ciò potrebbe significare contenuti che coinvolgono terrorismo, sfruttamento di minori o autolesionismo. I post come lo spam, nel frattempo, che sono fastidiosi ma non traumatici, sono classificati come meno importanti per la revisione.

“TUTTE LE VIOLAZIONI DEI CONTENUTI RICEVERANNO COMUNQUE UNA SOSTANZIALE REVISIONE DA PARTE DI PERSONE FISICHE”

“Tutte le violazioni dei contenuti riceveranno comunque una sostanziale revisione da parte di persone fisiche, ma utilizzeremo questo sistema per dare una migliore priorità [a quel processo]”, ha detto ai giornalisti Ryan Barnes, un product manager del team per l’integrità della comunità di Facebook, durante un briefing con la stampa.

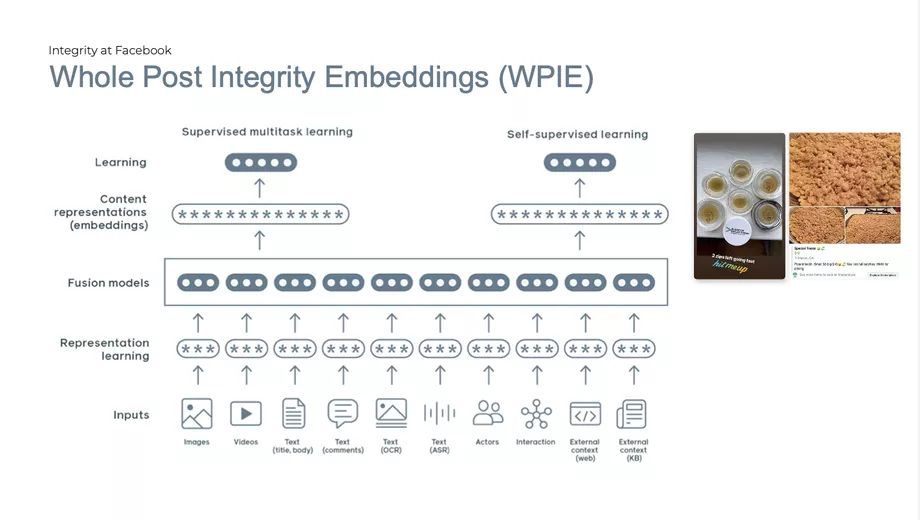

Facebook ha condiviso alcuni dettagli su come i suoi filtri di machine learning analizzano i post in passato . Questi sistemi includono un modello denominato “WPIE”, che sta per “integrazioni integrali del post” e adotta quello che Facebook chiama un approccio “olistico” alla valutazione dei contenuti.

Ciò significa che gli algoritmi giudicano i vari elementi in un dato post in concerto, cercando di capire cosa rivelano insieme l’immagine, la didascalia, il poster, ecc. Se qualcuno dice che sta vendendo un “lotto intero” di “prelibatezze speciali” accompagnato da un’immagine di quello che sembra essere un prodotto da forno, sta parlando di quadrati o commestibili di Rice Krispies? L’uso di alcune parole nella didascalia (come “potente”) potrebbe far pendere il giudizio in un modo o nell’altro.

Facebook utilizza vari algoritmi di apprendimento automatico per ordinare i contenuti, incluso lo strumento di valutazione “olistico” noto come WPIE. Immagine: Facebook

L’uso dell’intelligenza artificiale da parte di Facebook per moderare le sue piattaforme è stato oggetto di esame in passato , con i critici che hanno notato che l’intelligenza artificiale non ha la capacità di un essere umano di giudicare il contesto di molte comunicazioni online. Soprattutto con argomenti come disinformazione, bullismo e molestie, può essere quasi impossibile per un computer sapere cosa sta guardando.

Chris Palow di Facebook, un ingegnere del software nel team di integrità dell’interazione dell’azienda, ha convenuto che l’IA aveva i suoi limiti, ma ha detto ai giornalisti che la tecnologia potrebbe ancora svolgere un ruolo nella rimozione di contenuti indesiderati. “Il sistema prevede di sposare l’intelligenza artificiale e i revisori umani per fare meno errori totali”, ha affermato Palow. “L’intelligenza artificiale non sarà mai perfetta.”

Alla domanda su quale percentuale di post i sistemi di machine learning dell’azienda classificano in modo errato, Palow non ha dato una risposta diretta, ma ha notato che Facebook consente ai sistemi automatizzati di funzionare senza la supervisione umana solo quando sono accurati come revisori umani. “La barra per l’azione automatizzata è molto alta”, ha detto. Tuttavia, Facebook aggiunge costantemente più intelligenza artificiale al mix di moderazione.