La ricerca di informazioni mediche online è una pratica quotidiana per milioni di persone, ma l’ultima innovazione di Google ha sollevato un polverone che mette in discussione la sicurezza dell’intelligenza artificiale nel settore sanitario. Recentemente, il colosso di Mountain View ha dovuto fare marcia indietro, rimuovendo diverse “AI Overviews” — i riassunti generati automaticamente che compaiono in cima ai risultati di ricerca — a causa di errori gravi e potenzialmente letali. La decisione è arrivata in seguito a un’inchiesta giornalistica che ha evidenziato come queste sintesi digitali stessero diffondendo consigli medici fuorvianti, mettendo seriamente a rischio l’incolumità degli utenti più vulnerabili.

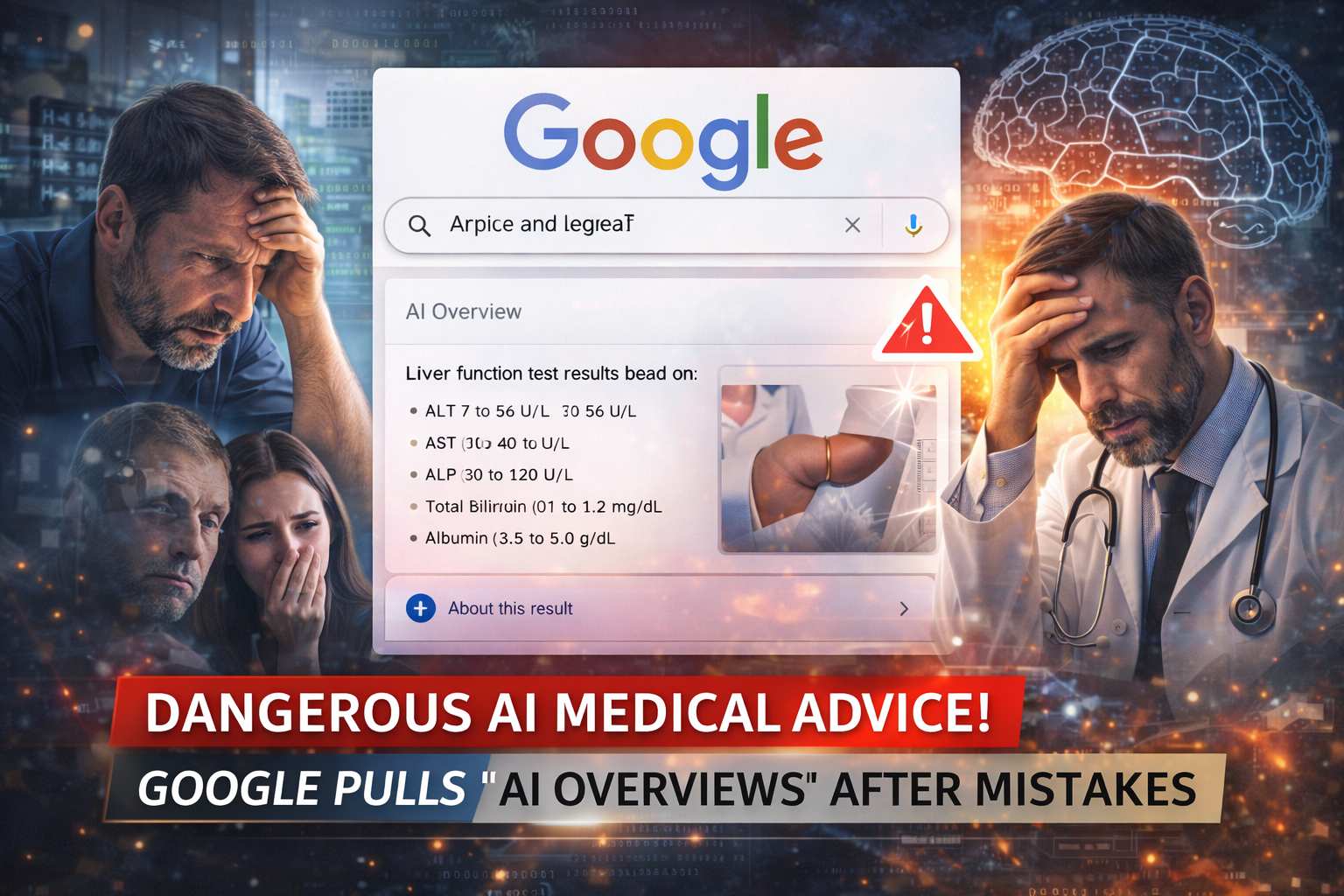

Uno dei casi più allarmanti ha riguardato i test di funzionalità epatica. Il sistema di intelligenza artificiale di Google ha fornito agli utenti una serie di valori numerici indicati come “normali” senza fornire il contesto necessario, ignorando variabili cruciali come l’età, il sesso, l’etnia o la nazionalità del paziente. In pratica, il riassunto dell’IA ha travisato i dati medici in modo tale che persone con gravi patologie al fegato avrebbero potuto convincersi, erroneamente, di essere in perfetta salute. Questo tipo di “falsa rassicurazione” è stata definita dagli esperti come estremamente pericolosa, poiché può spingere i malati a rinunciare a visite di controllo o a cure salvavita, convinti che i propri esami rientrino nei parametri corretti.

Oltre ai problemi legati alle malattie del fegato, l’inchiesta ha svelato falle preoccupanti anche in altri ambiti delicati, come il cancro e la salute mentale. In un caso specifico, l’IA avrebbe consigliato ai pazienti affetti da tumore al pancreas di evitare i grassi, un suggerimento che i medici hanno giudicato del tutto errato e potenzialmente fatale, poiché questi pazienti hanno spesso bisogno di un apporto calorico elevato per sostenere le terapie. Anche sul fronte della salute mentale, alcuni riassunti relativi a disturbi come la psicosi o i disturbi alimentari sono stati criticati per la mancanza di sfumature essenziali, offrendo consigli che avrebbero potuto scoraggiare chi soffre dal cercare l’aiuto professionale necessario.

La risposta di Google è stata inizialmente improntata alla cautela, sottolineando che le panoramiche AI si basano su fonti affidabili e che il sistema è progettato per mostrare riassunti solo quando c’è un’alta fiducia nella qualità della risposta. Tuttavia, l’azienda è intervenuta rimuovendo i risultati per query specifiche come “intervalli normali degli esami del fegato”. Nonostante questo intervento, molte associazioni per la tutela dei pazienti restano preoccupate. Il problema, infatti, sembra essere strutturale: basta modificare leggermente i termini della ricerca per far ricomparire informazioni potenzialmente errate, dimostrando che la “pulizia” del sistema è ancora parziale e che la tecnologia fatica a gestire la complessità dei dati medici.

Questa vicenda solleva un interrogativo profondo sul futuro dell’informazione sanitaria nell’era dell’intelligenza artificiale. Se da un lato questi strumenti promettono di rendere la conoscenza più accessibile, dall’altro la loro posizione privilegiata in cima ai risultati di ricerca conferisce loro un’autorità che può trarre in inganno. Quando si parla di salute, anche un piccolo errore di interpretazione può trasformarsi in una tragedia. La rimozione operata da Google viene vista come un passo necessario, ma per molti esperti è solo l’inizio di un lungo percorso volto a garantire che la velocità dell’IA non vada mai a scapito della precisione clinica e della sicurezza della vita umana.