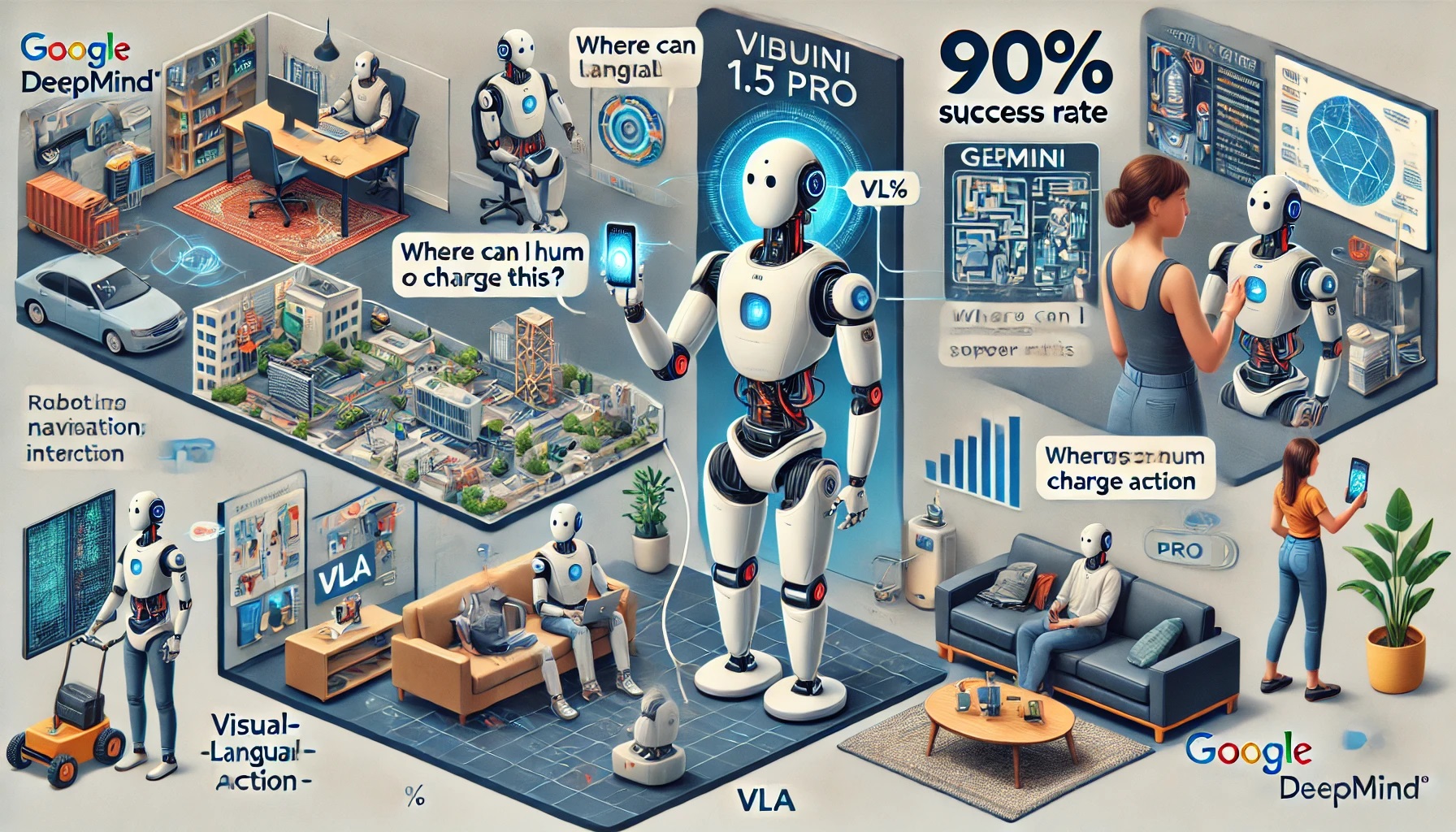

Google DeepMind ha sviluppato il modello “Gemini 1.5 Pro” per migliorare le capacità dei suoi robot di navigazione e interazione con gli esseri umani. Questo modello è stato integrato per permettere ai robot di apprendere l’ambiente circostante, eseguire comandi e comunicare in modo più avanzato.

Secondo un articolo di The Verge, il modello “Visual-Lingual-Action” (VLA) combina Gemini 1.5 Pro per guidare i robot a eseguire comandi in vari ambienti con meno necessità di formazione. Il sistema consente ai robot di interagire multimodalmente con gli umani, utilizzando testo, immagini e gesti per comprendere istruzioni complesse.

Ad esempio, un utente può mostrare un telefono al robot e chiedere: “Dove posso caricarlo?”. Utilizzando Gemini, il robot analizza il video registrato, identifica il contesto e guida l’utente verso una presa di corrente.

I robot basati su Gemini hanno dimostrato un elevato tasso di successo, completando oltre il 90% dei comandi utente in spazi di lavoro ampi come oltre 9.000 piedi quadrati.

Questo modello rappresenta un avanzamento rispetto al precedente “RT-2” di Google, integrando funzioni avanzate di comunicazione e analisi contestuale, nonché miglioramenti nell’inferenza delle decisioni.

Secondo i ricercatori, Gemini 1.5 Pro non si limita alla navigazione, ma aiuta anche le persone a pianificare e eseguire compiti complessi. Tuttavia, il documento di ricerca indica che il tempo di elaborazione per ogni richiesta può variare da 10 a 30 secondi.

Questo aggiornamento sottolinea l’impegno di Google DeepMind nel migliorare le capacità interattive e cognitive dei suoi robot, puntando a una maggiore efficienza e precisione nelle loro operazioni quotidiane.