Lo strumento AI di Google non utilizzerà più etichette di genere come “donna” o “uomo” nelle foto di persone

L’API di Google Cloud Vision contrassegnerà le immagini come “persona” per contrastare la distorsione

Uno strumento di intelligenza artificiale fornito da Google agli sviluppatori non aggiungerà più etichette di genere alle immagini, dicendo che il genere di una persona non può essere determinato solo da come appaiono in una foto, riporta Business Insider .

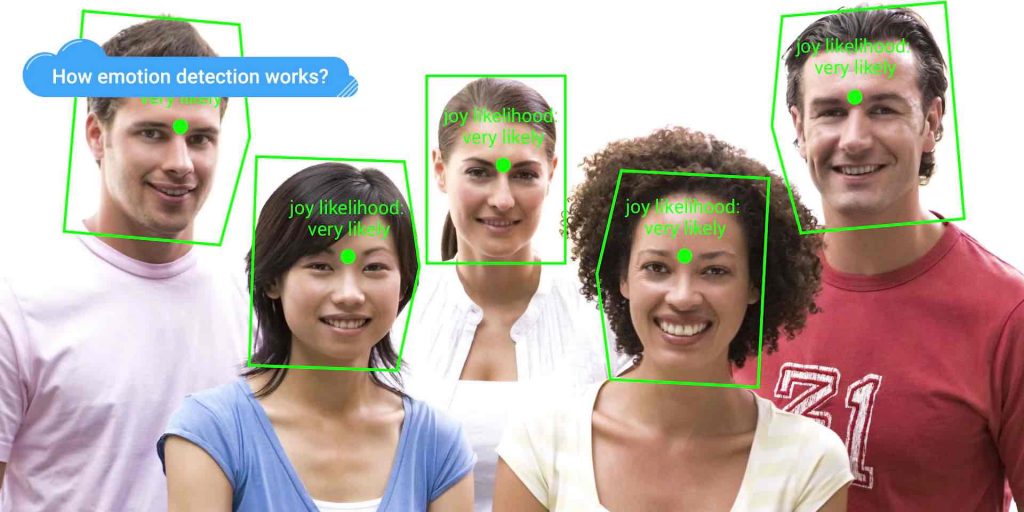

La società ha inviato oggi agli sviluppatori via e-mail la modifica del suo strumento API Cloud Vision ampiamente utilizzato, che utilizza l’intelligenza artificiale per analizzare immagini e identificare volti, punti di riferimento, contenuti espliciti e altre caratteristiche riconoscibili. Invece di usare “uomo” o “donna” per identificare le immagini, Google taggerà tali immagini con etichette come “persona”, come parte del suo più grande sforzo per evitare di instillare algoritmi AI con pregiudizio umano.

“IL GENERE DI UNA PERSONA NON PUÒ ESSERE DEDOTTO DALL’ASPETTO”

Nell’e-mail agli sviluppatori che annunciava la modifica, Google ha citato le proprie linee guida AI, rapporti di Business Insider . “Dato che il genere di una persona non può essere dedotto dall’aspetto, abbiamo deciso di rimuovere queste etichette per allinearle ai principi di intelligenza artificiale di Google , in particolare il principio n. 2: evitare di creare o rafforzare pregiudizi ingiusti”.

Il riconoscimento delle immagini AI è stato un problema spinoso per Google in passato. Nel 2015, un ingegnere del software ha notato che gli algoritmi di riconoscimento delle immagini di Google Foto stavano classificando i suoi amici neri come “gorilla”. Google ha promesso di risolvere il problema, ma un rapporto di follow-up di Wired nel 2018 ha scoperto che Google aveva bloccato la sua IA dal riconoscimento dei gorilla e non aveva fatto molto altro per affrontare il problema alla base.

Google ha rilasciato i suoi principi di intelligenza artificiale nel 2018 , in risposta al contraccolpo dei dipendenti di Google, che hanno protestato per il lavoro dell’azienda su un progetto di drone del Pentagono. La società si è impegnata a non sviluppare armamenti basati sull’intelligenza artificiale e ha anche delineato una serie di principi, come quello sopra citato, per affrontare questioni di parzialità, supervisione e altre potenziali questioni etiche nel suo futuro sviluppo della tecnologia.