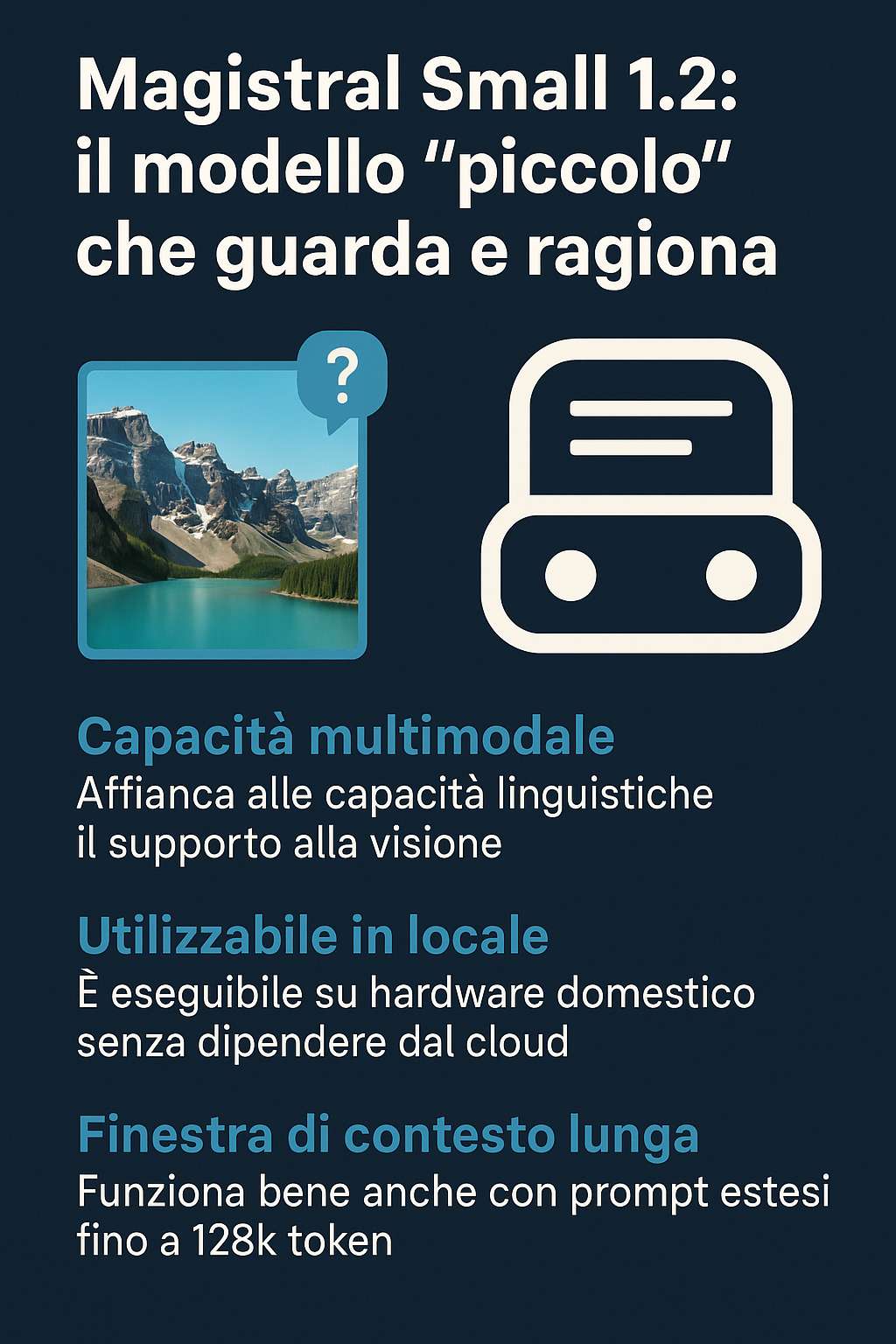

Magistral Small 1.2 è l’ultima evoluzione di Mistral AI nel campo dei modelli linguistici che non si limitano soltanto a generare testi, ma mettono in campo una forma di ragionamento più sofisticata, in grado di comprendere anche immagini. È un passo avanti significativo perché con questo aggiornamento il modello diventa multimodale: non solo “parla” e “ascolta”, come molti altri LLM, ma è anche in grado di “vedere”, di interpretare ciò che appare visivamente, e di usare queste informazioni visive assieme al testo per dare risposte più profonde e contestuali.

Il modello mantiene la sua struttura da 24 miliardi di parametri, ma con Magistral Small 1.2 si registrano miglioramenti non solo nelle performance standard, ma anche nella gestione delle immagini. Prima, Magistral Small era apprezzato per essere un modello “aperto” sotto licenza Apache 2.0, accessibile, modificabile, utilizzabile sia in progetti personali che commerciali, senza le limitazioni delle licenze più restrittive. Ora questa apertura è combinata con capacità visive concrete, che ampliano molto il tipo di utilizzi possibili.

Un aspetto che sorprende è quanto “leggero” sia diventato nelle richieste hardware. È possibile farlo girare su computer non particolarmente potenti: una GPU NVIDIA RTX 4090, oppure anche su un MacBook con 32 GB di RAM una volta che il modello è quantizzato. Questo significa che può essere usato in locale, riducendo dipendenza da infrastrutture cloud costose o da connessioni continue. È una qualità che lo rende attraente sia per piccole realtà che per sviluppatori indipendenti.

Nel passaggio da Magistral 1.1 a 1.2, la novità del vision encoder è quella che maggiormente distingue questa versione. Incorporare la capacità di ricevere input visivi e testo insieme permette di gestire domande che richiedono interpretazione di immagini: ad esempio si può caricare una fotografia, un diagramma, una scena visiva, e chiedere cosa succede, quali elementi emergono, oppure chiedere che tipo di analisi si può fare su quel contenuto visivo. Questo apre scenari che vanno oltre il puro testo, e che erano fino a poco prima riservati a modelli più grandi o specializzati.

Questa versione porta anche miglioramenti nella stabilità delle risposte, nella capacità di seguire istruzioni precise, nella formattazione dei contenuti — per esempio migliore supporto a Markdown e LaTeX — e in riduzioni di comportamenti indesiderati come generazioni infinite o ripetitive. È come se il modello avesse guadagnato in maturità: sa più chiaramente quando “dire” qualcosa, come strutturare la risposta, e offre tracce intermedie del suo ragionamento (token speciali che segnano l’inizio e la fine della parte “di riflessione”) in modo che chi lo usa possa vedere come arriva a certe conclusioni.

Un’altra differenza importante è che, pur essendo progettato per sostenere contesti molto ampi (fino a 128k token), le prestazioni migliori si mantengono quando i prompt non sono troppo lunghi, idealmente sotto i 40-50k token. Questo aiuta a usare il modello efficientemente senza pesare troppo sull’hardware o sulla latenza.

Dal punto di vista pratico, Magistral Small 1.2 è disponibile attraverso Hugging Face con il nome Magistral-Small-2509. Chi desidera, può scaricarlo e usarlo localmente o via API. Per sviluppatori che hanno bisogno di generare descrizioni di immagini, tradurre contenuti, lavorare con layout visivi, o fare analisi dove il testo da solo non basta, questo modello diventa un’opzione molto concreta.

Magistral Small 1.2 è un segnale forte su come stanno cambiando le aspettative verso i modelli di intelligenza artificiale: non basta saper “parlare bene”, bisogna anche saper “guardare bene”, saper integrare il visivo e il testuale in un ragionamento che sia coerente, affidabile, interpretabile. Per chi progetta applicazioni che richiedono esattezza, trasparenza o che operano in contesti multilingue o visivi, questa versione rappresenta un notevole passo avanti.