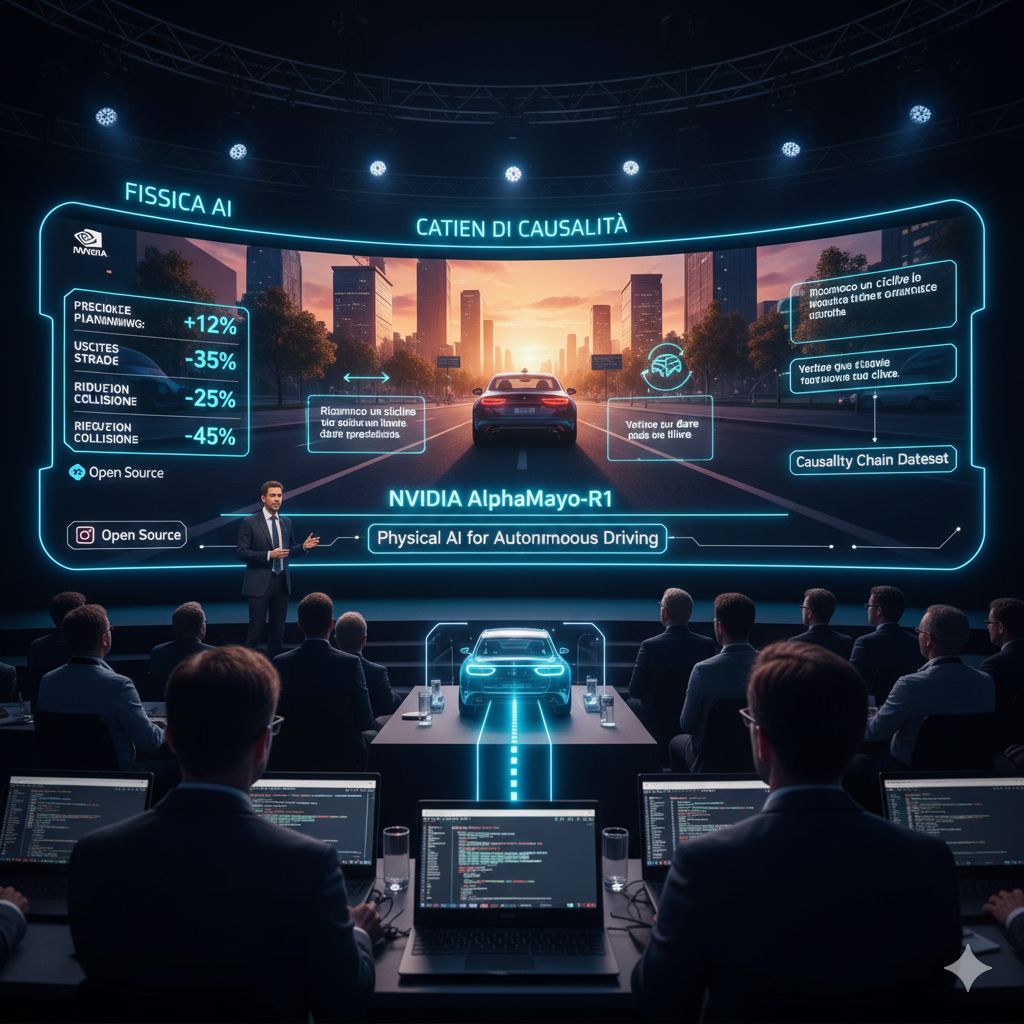

NVIDIA ha presentato una nuova generazione di modelli dedicati alla guida autonoma, segnando un passo importante verso quella che l’azienda definisce “intelligenza artificiale fisica”, ovvero sistemi capaci non solo di vedere e riconoscere l’ambiente circostante, ma di comprenderlo, descriverlo e reagire con una logica simile al buon senso umano. Alla conferenza NeurIPS, NVIDIA ha mostrato al pubblico AlphaMayo-R1, un modello open source progettato per rendere il processo decisionale dei veicoli autonomi più trasparente, stabile e affidabile anche in scenari complessi.

Ciò che distingue AlphaMayo-R1 dalle soluzioni tradizionali non è solo l’accuratezza nella percezione, ma la sua capacità di spiegare in linguaggio naturale come e perché un veicolo prende determinate decisioni. Fino ad oggi, i sistemi di guida autonoma funzionavano come “scatole nere”: si limitavano a reagire agli input, senza fornire un vero resoconto dei ragionamenti che portavano a frenare, correggere la traiettoria o evitare un ostacolo. Questo approccio rendeva difficile per gli ingegneri individuare le cause di un errore. AlphaMayo-R1 affronta proprio questo limite, integrando testo, immagini e movimento in un’unica architettura che elabora l’ambiente circostante, lo interpreta e produce una spiegazione coerente delle sue decisioni.

Il modello analizza le immagini provenienti da più telecamere, le integra con i dati di movimento del veicolo e le trasforma in “token visivi”, una rappresentazione strutturata che permette al sistema di analizzare l’ambiente con un livello di dettaglio molto più elevato rispetto ai software tradizionali. Questi token vengono elaborati da Cosmos-Reason, il cuore del nuovo framework, che combina un modello linguistico visivo e un generatore di traiettorie capace di pianificare movimenti fisicamente plausibili.

Uno dei contributi più innovativi del progetto è la creazione di un nuovo dataset chiamato “Catena di Causalità”, pensato per colmare una lacuna storica nella guida autonoma: l’assenza di informazioni sul perché vengono prese certe decisioni. Il dataset raccoglie sequenze di guida accompagnate da spiegazioni strutturate e coerenti, ottenute tramite un processo ibrido di etichettatura automatica e revisione umana. Questo permette ad AlphaMayo-R1 di apprendere non solo come si guida, ma anche come si ragiona mentre si guida.

Il percorso di addestramento segue una struttura multifase: prima con l’apprendimento supervisionato, necessario per insegnare al modello a esprimere chiaramente i suoi ragionamenti, e poi con il rinforzo, che affina la qualità dell’inferenza utilizzando un modello di valutazione esterno capace di confrontare logicamente pensiero e azione. Il risultato è una coerenza decisionale che aumenta in modo significativo man mano che il modello scala da 500 milioni a 7 miliardi di parametri.

I dati sperimentali mostrano un miglioramento netto delle prestazioni: la pianificazione della traiettoria risulta fino al 12% più precisa, le uscite di strada si riducono del 35%, e il rischio di collisioni ravvicinate diminuisce del 25%. Dopo la fase di rinforzo, la qualità dell’inferenza aumenta del 45% e la coerenza tra ragionamento e comportamento cresce del 37%. Anche nei test su strada, il modello ha mostrato una latenza di 99 millisecondi, sufficiente per una guida in tempo reale in ambienti urbani complessi.

NVIDIA sostiene che AlphaMayo-R1 sia il primo modello VLA open source dedicato all’inferenza per la guida autonoma, e per questo potrà diventare una base cruciale per le aziende che puntano a raggiungere standard di livello 4, ovvero una guida completamente autonoma in molti scenari reali. L’apertura del codice su GitHub e HuggingFace rappresenta un gesto strategico: portare trasparenza in un settore tradizionalmente dominato da soluzioni chiuse, accelerare la ricerca e favorire lo sviluppo collaborativo.

In un contesto in cui la guida autonoma è ancora frenata da limiti nella comprensione causale e nella capacità di anticipare situazioni impreviste, AlphaMayo-R1 si presenta come una soluzione che introduce un linguaggio comune tra uomo e macchina. Con la possibilità di descrivere il mondo, spiegarlo e motivare le proprie scelte, questo modello non si limita a vedere la strada: inizia a capirla. E questo, per il futuro della mobilità, è un passo molto più significativo di qualsiasi semplice aumento di accuratezza.