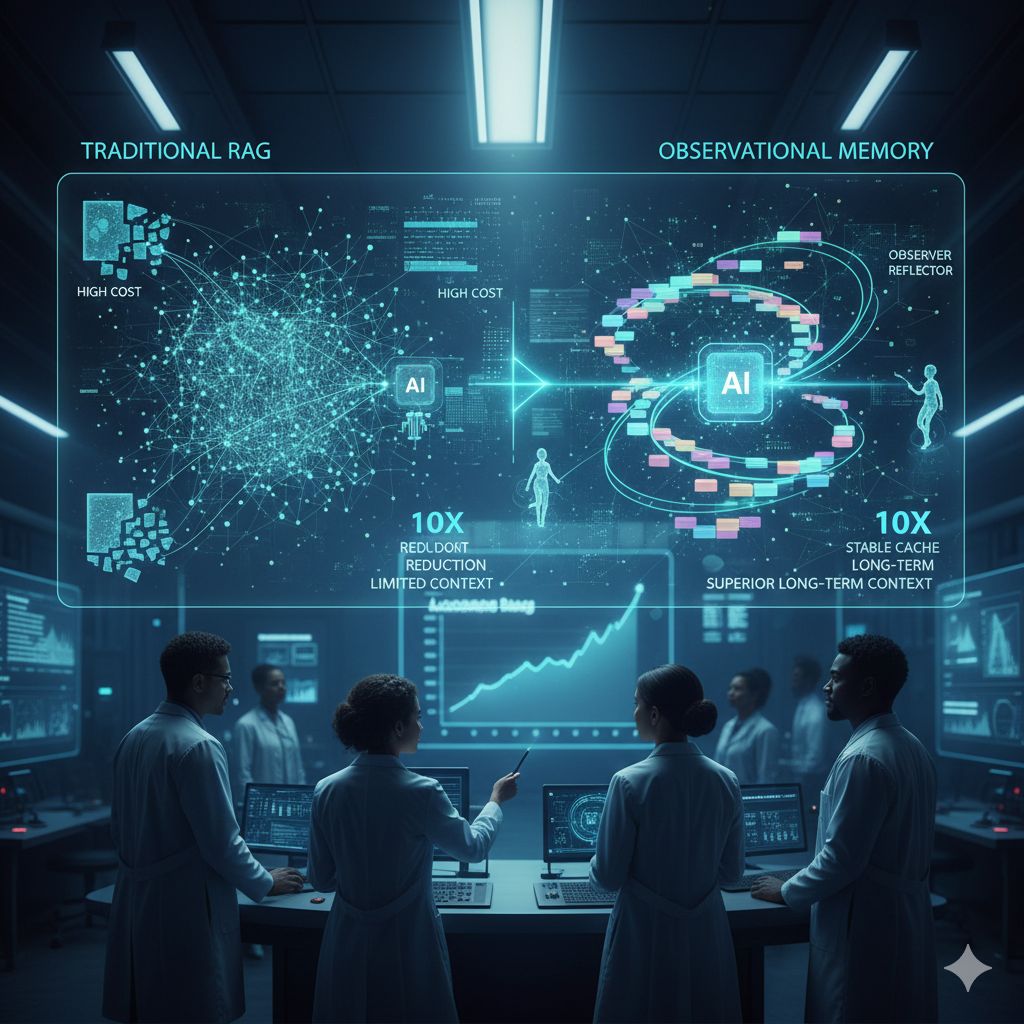

Nell’intelligenza artificiale orientata agli agenti autonomi, uno dei problemi più complessi e costosi da affrontare è la gestione della memoria a lungo termine, ovvero la capacità di un agente di ricordare informazioni, decisioni e contesti attraverso sessioni dilatate nel tempo. In molti casi, i sistemi basati su Retrieval-Augmented Generation (RAG), che sono stati finora la soluzione dominante per mantenere contesto oltre i limiti della finestra di contesto dei modelli, si sono rivelati limitati, costosi e non sempre sufficienti per applicazioni che richiedono stabilità e continuità reale. In risposta a questa sfida, è emersa una nuova architettura denominata “observational memory”, sviluppata da Mastra, che promette di tagliare i costi fino a dieci volte rispetto alle implementazioni RAG tradizionali e di ottenere risultati migliori su benchmark specifici per compiti di contesto lungo, segnando un possibile punto di svolta nell’evoluzione delle tecnologie di agenti intelligenti.

Il concetto alla base di questa innovazione è profondamente diverso rispetto ai sistemi di memoria o di recupero tradizionali. I sistemi RAG funzionano memorizzando grandi porzioni di dati o testo in basi di dati strutturate e recuperando i segmenti ritenuti più pertinenti tramite meccanismi di ricerca basati su embeddings. Questo processo comporta costi elevati di calcolo e di token, oltre a introdurre complessità infrastrutturali notevoli, come la necessità di mantenere e interrogare database esterni. La observational memory, invece, elimina la fase di recupero dinamico sostituendola con un processo di compressione e registrazione progressiva del contesto: due agenti in background, l’Observer e il Reflector, si occupano di convertire il flusso delle conversazioni e delle interazioni in un log di osservazioni datate e coerenti, comprimendo efficacemente la storia e mantenendo solo ciò che è rilevante per continuare l’esecuzione del compito nel tempo.

Questa architettura si basa su due blocchi principali: il primo contiene le osservazioni compresse e datate, mentre il secondo mantiene la storia dei messaggi grezzi della sessione corrente. Quando la memoria non processata raggiunge una certa soglia di token, l’Observer interviene per sintetizzare e appenderla alle osservazioni datate, mentre il Reflector successivamente riorganizza e condensa queste osservazioni per evitare ridondanze. Il risultato è un contesto stabile e continuativo che può essere utilizzato come prefisso coerente per la generazione di nuove risposte, permettendo un caching altamente efficace da parte dei provider di modelli come OpenAI o Anthropic. Questo riduce sensibilmente i costi di inferenza, poiché un contesto stabile e cacheabile richiede meno token e meno rielaborazioni delle informazioni.

I benefici di questa soluzione emergono in modo chiaro se si osservano le prestazioni su benchmark come LongMemEval, progettato per valutare la capacità di un agente di mantenere e utilizzare informazioni su conversazioni molto lunghe e complesse. I risultati mostrano che, utilizzando modelli come GPT-5-mini, gli agenti con observational memory non solo tagliano i costi fino a dieci volte rispetto ai sistemi che non sfruttano contesti cache-abili, ma ottengono anche punteggi elevati in termini di accuratezza e continuità del contesto. Con un punteggio di circa il 94,87 % su LongMemEval, questo approccio supera anche implementazioni RAG personalizzate, mentre su modelli più potenti come GPT-4o si registrano prestazioni nettamente superiori alla memoria RAG di riferimento.

Questa nuova memoria non è pensata per sostituire completamente RAG in ogni scenario, ma piuttosto per offrire un’alternativa più efficiente in quegli use case dove la memoria a lungo termine e la stabilità del contesto sono fondamentali. Ad esempio, agenti integrati all’interno di piattaforme SaaS che devono ricordare preferenze degli utenti, decisioni prese settimane prima, o dettagli di workflow complessi, beneficiano enormemente della capacità di mantenere una cronologia coerente senza dover reinserire costantemente le stesse informazioni o ricorrere a recuperi esterni costosi. Questi casi d’uso, che comprendono assistenti conversazionali per sistemi di gestione dei contenuti, agenti di supporto per l’ingegneria del software o flussi di elaborazione documentale, richiedono che la memoria non sia solo persistente, ma significativa, contestuale e continua nel tempo.

Dal punto di vista delle implicazioni tecnologiche, la observational memory rappresenta una semplificazione importante rispetto alle architetture tradizionali: non richiede database vettoriali, sistemi di embedding esterni o complesse pipeline di gestione dei dati, basandosi invece su una logica testuale diretta che riflette le osservazioni e le decisioni prese nel corso delle interazioni. Questo facilita non solo l’implementazione e la manutenzione, ma anche il debugging e l’analisi delle performance, rendendo l’architettura più trasparente e predicibile.

Nel contesto in cui gli agenti AI lasciano gradualmente l’ambito sperimentale per inserirsi in sistemi produttivi reali, la gestione efficiente della memoria diventa un elemento critico non solo per l’esperienza utente, ma anche per l’economia delle applicazioni stesse. Ridurre drasticamente i costi operativi senza compromettere la coerenza delle risposte o la capacità di mantenere informazioni rilevanti attraverso lunghi periodi di utilizzo significa rendere gli agenti più scalabili, sostenibili e utilizzabili in prodotti reali. In questo senso, l’architettura proposta da Mastra e la sua espressione concreta nella observational memory possono rappresentare non soltanto un’alternativa a RAG, ma una nuova direzione nell’evoluzione delle infrastrutture di memoria per agenti AI avanzati.