Il rapido avanzamento dei modelli linguistici di grandi dimensioni (LLM) e degli agenti di intelligenza artificiale ha generato un’ondata di entusiasmo, alimentando la convinzione che l’automazione completa dei flussi di lavoro aziendali sia ormai dietro l’angolo. Tuttavia, un’indagine approfondita condotta da Databricks, concretizzata con il lancio del nuovo benchmark open source OfficeQA, ha messo in luce una significativa e preoccupante disconnessione tra le performance che questi agenti ottengono nei test astratti e la loro effettiva capacità di affrontare compiti complessi nel mondo del lavoro reale. Mentre gli agenti AI continuano a eccellere in esercizi accademici o in benchmark troppo lontani dalla pratica quotidiana, il loro rendimento crolla drasticamente quando si confrontano con le sfide concrete che definiscono il valore economico in un’azienda.

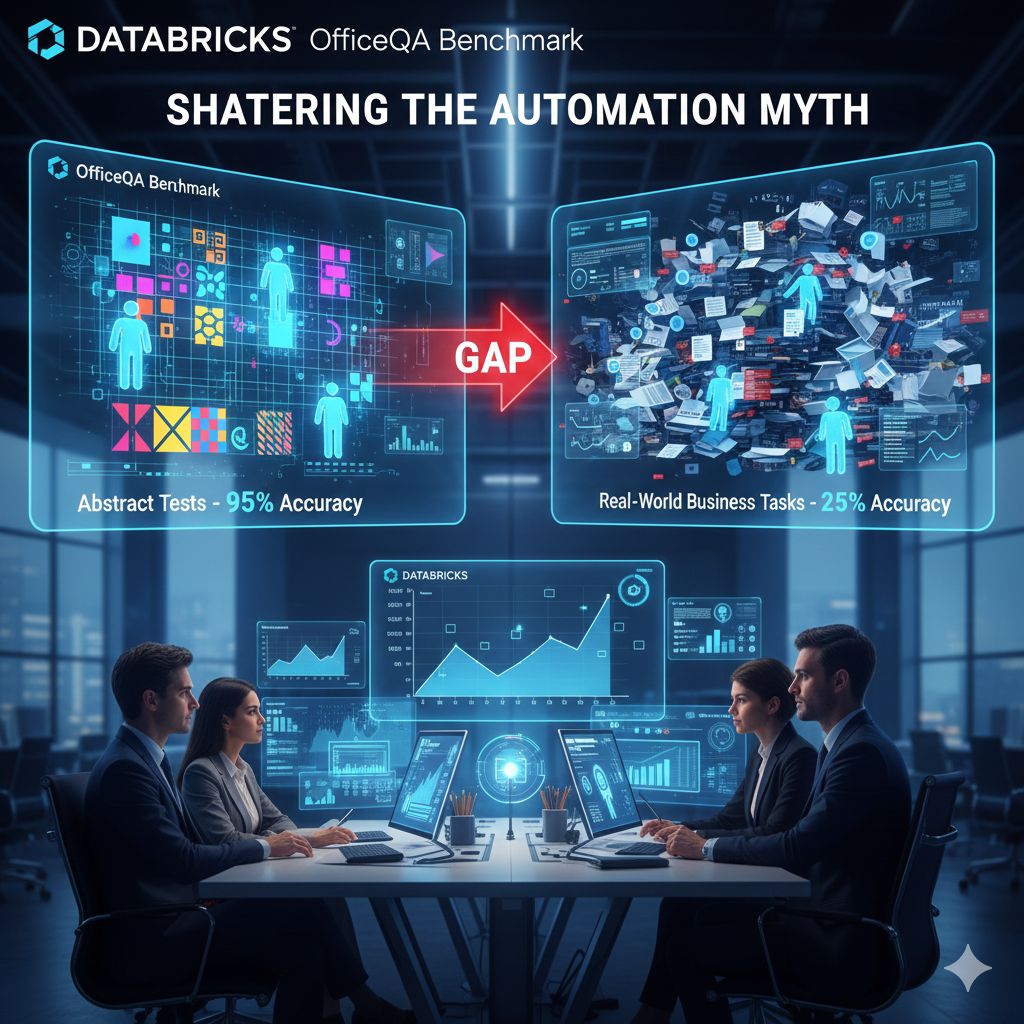

Tradizionalmente, molti test di valutazione per l’intelligenza artificiale si sono concentrati su compiti isolati o su esercizi cognitivi così astratti, come la manipolazione visiva di griglie colorate, da risultare completamente slegati dalle dinamiche aziendali. Questi test, pur misurando l’abilità di ragionamento di base, hanno fornito una metrica distorta, permettendo persino a modelli molto più piccoli e specializzati di eguagliare le performance di LLM generalisti e notevolmente più grandi. Il risultato è stata un’eccessiva fiducia nelle capacità degli agenti di traslare la loro intelligenza astratta in risultati tangibili in produzione. OfficeQA nasce proprio per colmare questa lacuna, fornendo una valutazione che imita fedelmente le attività realmente preziose per i clienti enterprise di Databricks, agendo come un filtro rigoroso per ciò che funziona davvero.

La natura complessa di OfficeQA risiede nella sua struttura. Il benchmark è composto da una serie di domande che richiedono un ragionamento radicato end-to-end e la gestione di dati non strutturati. L’agente non deve semplicemente rispondere a una domanda singola, ma spesso eseguire operazioni multi-passo: leggere e comprendere un corpus di documenti in formato PDF, navigare nelle informazioni, estrarre e sintetizzare dati rilevanti, e infine formulare una risposta che tenga conto di tutto il contesto aziendale fornito. In sostanza, simula ciò che un analista umano farebbe lavorando su una cartella di contratti, report finanziari o manuali tecnici.

Ed è proprio di fronte a questa simulazione realistica che i sistemi attuali, inclusi quelli basati su modelli all’avanguardia come i chatbot più evoluti di OpenAI e Claude, hanno mostrato i loro limiti strutturali. I test hanno rivelato che gli agenti AI riescono a malapena a raggiungere il 45% di accuratezza sull’intero benchmark, con un crollo verticale a meno del 25% sulle sotto-domande classificate come le più difficili. Questa performance, inferiore alle aspettative generate dal battage pubblicitario, evidenzia che la vera sfida per gli agenti non è tanto il ragionamento teorico, quanto la capacità di interagire in modo robusto e affidabile con la realtà disordinata del knowledge aziendale, che è spesso intrappolato in file PDF e report di difficile interpretazione.

Il messaggio implicito lanciato da OfficeQA è chiaro: per superare la fase del prototipo e raggiungere una piena affidabilità in produzione, gli agenti AI necessitano di un’infrastruttura di governance e misurazione più sofisticata e soprattutto di una capacità notevolmente potenziata di sbloccare il dato non strutturato. Sebbene l’industria si stia muovendo in questa direzione, con piattaforme come Agent Bricks di Databricks che cercano di rendere l’ottimizzazione e la validazione dei modelli un processo misurabile e verificabile, i risultati di OfficeQA dimostrano che la strada da percorrere è ancora lunga. Il benchmark non è solo un esercizio accademico, ma una vera e propria chiamata all’azione per gli sviluppatori di AI affinché si concentrino sull’affidabilità, sulla governabilità e sulla precisione pratica, piuttosto che sui semplici punteggi di benchmark astratti. Solo in questo modo gli agenti AI potranno effettivamente trasformarsi da promesse tecnologiche in partner operativi essenziali per l’economia enterprise.