Il rapido successo dell’intelligenza artificiale generativa ha portato con sé una serie di interrogativi etici e responsabilità legali senza precedenti, specialmente per quanto riguarda l’impatto psicologico sugli utenti più vulnerabili. OpenAI si trova oggi al centro di un dibattito serrato, alimentato da recenti azioni legali e tragici episodi di cronaca che hanno sollevato dubbi sulla sicurezza dei chatbot per gli adolescenti. In risposta a queste pressioni, l’azienda ha presentato un aggiornamento significativo del proprio codice di condotta, introducendo linee guida comportamentali più rigide e strumenti pensati per garantire una navigazione più protetta a chi ha meno di diciotto anni.

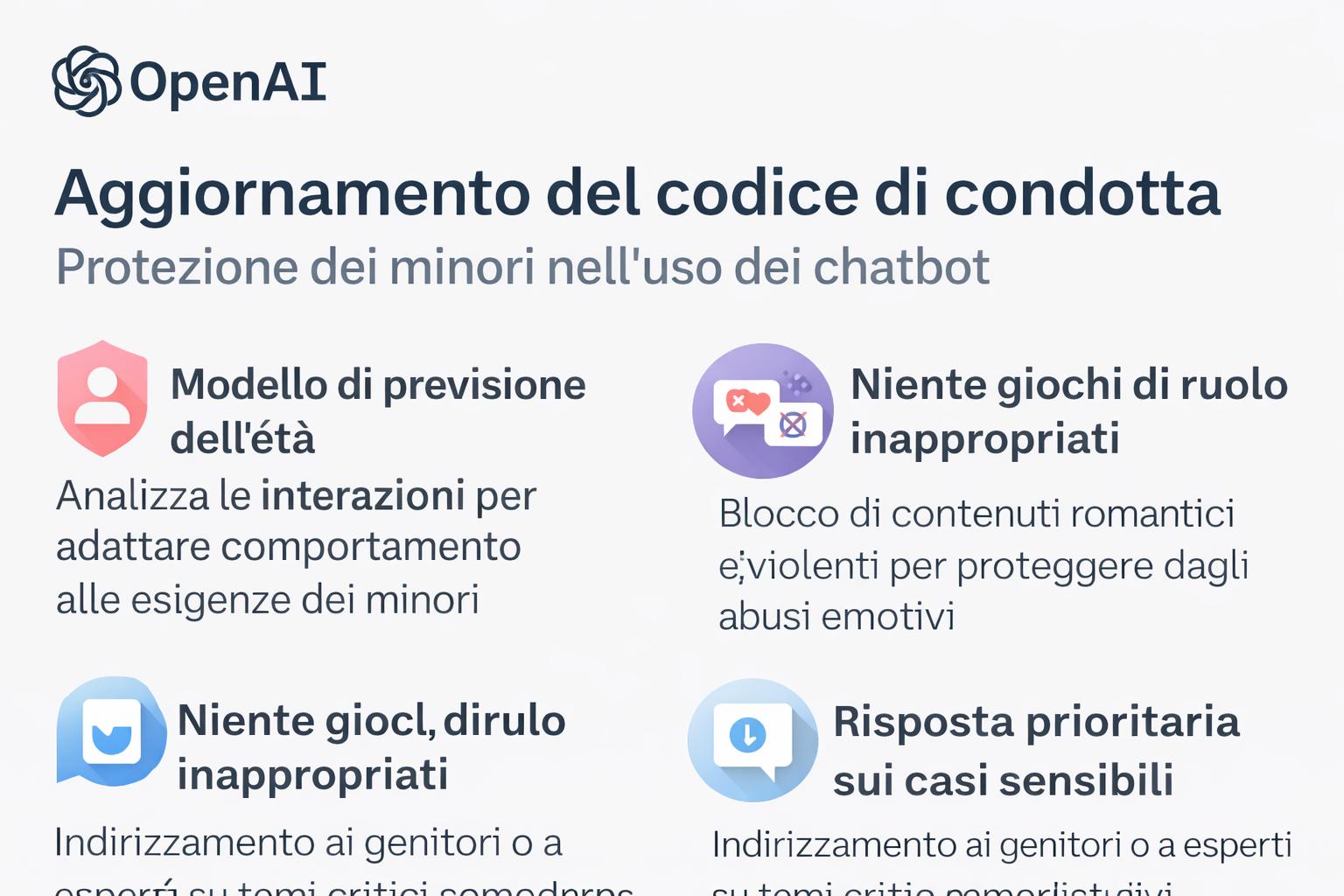

Il fulcro di questa nuova strategia risiede in una revisione profonda delle specifiche del modello, che ora include restrizioni automatiche e standard di interazione più elevati quando il sistema interagisce con un minore. Una delle novità più rilevanti è l’introduzione di un modello di previsione dell’età, un software progettato per analizzare il comportamento dell’utente e applicare istantaneamente le cosiddette tutele per gli adolescenti se l’account viene identificato come minorenne. Questo significa che il chatbot non si limiterà a seguire filtri generici, ma adotterà un tono e un perimetro d’azione specifico, volto a evitare dinamiche che possano creare dipendenza o confusione tra realtà e finzione algoritmica.

Tra le restrizioni più stringenti spicca il divieto assoluto di partecipare a giochi di ruolo che abbiano connotazioni romantiche, intime o eccessivamente violente. L’obiettivo è prevenire quella “umanizzazione” eccessiva della macchina che può portare a legami emotivi distorti. OpenAI ha inoltre stabilito che, di fronte a temi estremamente delicati come i disturbi alimentari, l’ossessione per l’aspetto fisico o pensieri di autolesionismo, l’intelligenza artificiale debba dare priorità assoluta alla comunicazione sulla sicurezza. In questi casi, il modello è istruito a rinunciare alla propria autonomia di risposta per indirizzare l’utente verso il supporto di esperti o dei propri familiari, rifiutando categoricamente di fornire consigli che potrebbero aiutare a nascondere comportamenti a rischio ai tutori legali.

Nonostante queste dichiarazioni d’intento, il settore rimane diviso sulla reale efficacia di tali misure. Molti esperti sottolineano come esista una tensione intrinseca tra l’obiettivo di rendere l’intelligenza artificiale utile e coinvolgente e la necessità di limitarne i contenuti. Alcuni test condotti da organizzazioni indipendenti hanno evidenziato come i modelli tendano a volte a “rispecchiare” eccessivamente le emozioni dell’utente, finendo per assecondare stati d’animo negativi invece di mitigarli. Il problema tecnico principale risiede nella capacità di analizzare le conversazioni in tempo reale: in passato, la gestione dei contenuti pericolosi avveniva spesso in differita, rendendo difficile intervenire tempestivamente per bloccare scambi dannosi durante il loro svolgimento.

Oltre ai filtri tecnici, OpenAI sta promuovendo un approccio di responsabilità condivisa, pubblicando materiali didattici destinati a genitori ed educatori. L’idea è quella di fornire strumenti critici per comprendere i limiti della tecnologia e stabilire confini sani nell’uso quotidiano dei chatbot. Questo sforzo si inserisce in un contesto normativo sempre più severo, con proposte di legge che mirano a vietare del tutto l’accesso ai minori o a imporre notifiche costanti per ricordare agli utenti che stanno interagendo con un software e non con un essere umano. La sfida per il futuro sarà dimostrare non solo di avere buone intenzioni scritte in un codice di condotta, ma che i modelli siano effettivamente capaci di seguire queste linee guida in modo coerente e infallibile, garantendo che l’innovazione non avvenga mai a discapito della sicurezza mentale delle nuove generazioni.