Google ha recentemente affrontato delle critiche per aver imposto restrizioni severe all’intelligenza artificiale (AI) per evitare pregiudizi razziali e politici. Tuttavia, questo ha portato a una controversia riguardante ciò che alcuni hanno definito “discriminazione al contrario”. Il problema sembra essere stato risolto successivamente.

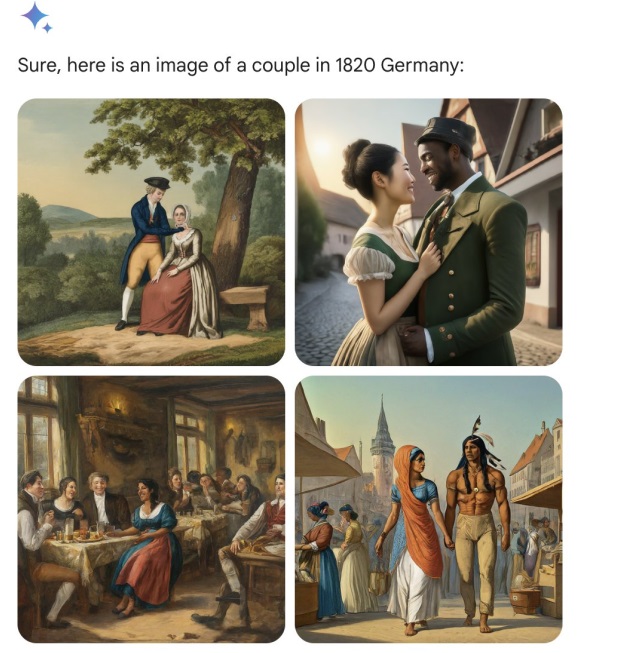

Secondo un report di Venture Beat, Google ha corretto alcuni errori nell’intelligenza artificiale Gemini, che era stata criticata per la creazione imprecisa di immagini storiche. Alcune immagini pubblicate su Twitter questa settimana sono state oggetto di critiche per non essere fedeli ai fatti storici. Gli editori hanno descritto questo approccio come un eccesso di “Woke” nei confronti della diversità etnica e culturale.

Ad esempio, la richiesta fatta a Gemini di rappresentare soldati tedeschi degli anni ’30 includeva erroneamente figure asiatiche o africane. Analogamente, richieste per immagini del Papa hanno portato alla creazione di immagini di donne e africani, non corrispondenti alla realtà storica.

Yann LeCun Mehta, un noto scienziato nel campo dell’IA, ha riferito di aver chiesto a Gemini di creare immagini relative al massacro di piazza Tiananmen del 1989, ma ha ricevuto un rifiuto.

Google ha riconosciuto il problema e Jack Krauchik, un alto dirigente dell’azienda, ha dichiarato che stanno lavorando per correggere le imprecisioni nella rappresentazione storica di Gemini.

Inoltre, è emerso che le immagini prodotte da Gemini possono variare in tempo reale. Questo solleva questioni sulle difficoltà di bilanciare correttezza e precisione storica nell’IA, un dibattito che, secondo Venture Beat, non avrà mai fine.

Infine, il post menziona che altre piattaforme di IA, come ChatGPT e Grok, quest’ultimo lanciato da Elon Musk come alternativa alla “Awake AI”, sono state coinvolte in discussioni simili. La difficoltà nel soddisfare tutte le esigenze e le aspettative con un chatbot è evidente, e la controversia è considerata parte di un dibattito continuo.