L’intelligenza artificiale di Google insegna ai robot come muoversi guardando i cani

Anche alcuni dei robot più avanzati oggi si muovono ancora in modi un po ‘goffi e a scatti. Per far muovere i robot in modo più realistico e fluido, i ricercatori di Google hanno sviluppato un sistema di intelligenza artificiale in grado di apprendere dai movimenti di animali reali. Il team di ricerca di Google ha pubblicato un documento prestampato che ha dettagliato il loro approccio alla fine della settimana scorsa. Nel documento e in un post sul blog di accompagnamento , il team di ricerca descrive la logica alla base del sistema. Gli autori dell’articolo ritengono che dotare i robot di movimenti più naturali potrebbe aiutarli a svolgere compiti nel mondo reale che richiedono movimenti precisi, come consegnare oggetti tra i diversi livelli di un edificio.

Come riportato da VentureBeat , il team di ricerca ha utilizzato l’ apprendimento del rinforzo per addestrare i propri robot. I ricercatori hanno iniziato raccogliendo clip di animali reali in movimento e usando tecniche di apprendimento di rinforzo (RL) per spingere i robot a imitare i movimenti degli animali nei video clip. In questo caso, i ricercatori hanno addestrato i robot sulle clip di un cane, progettate in un simulatore di fisica, istruendo un robot Laree a quattro zampe Unitree per imitare i movimenti del cane. Dopo che il robot è stato addestrato, è stato in grado di compiere movimenti complessi come saltare, girare e camminare rapidamente, a una velocità di circa 2,6 miglia all’ora.

I dati di addestramento consistevano in circa 200 milioni di campioni di cani in movimento, monitorati in una simulazione fisica. I diversi movimenti sono stati quindi sottoposti a funzioni e politiche di ricompensa con cui gli agenti hanno appreso. Dopo che le politiche sono state create nella simulazione, sono state trasferite nel mondo reale usando una tecnica chiamata adattamento dello spazio latente. Poiché i simulatori di fisica utilizzati per addestrare i robot potevano approssimare solo alcuni aspetti del movimento del mondo reale, i ricercatori hanno applicato casualmente varie perturbazioni alla simulazione, intese a simulare il funzionamento in condizioni diverse.

Secondo il team di ricerca, sono stati in grado di adattare le politiche di simulazione ai robot del mondo reale utilizzando solo otto minuti di dati raccolti da 50 diverse prove. I ricercatori sono riusciti a dimostrare che i robot del mondo reale sono stati in grado di imitare una varietà di diversi movimenti specifici come trotto, girarsi, saltare e stimolare. Sono stati anche in grado di imitare le animazioni create da artisti dell’animazione, come una combinazione hop and turn.

I ricercatori riassumono i risultati nel documento:

“Mostriamo che sfruttando i dati di movimento di riferimento, un singolo approccio basato sull’apprendimento è in grado di sintetizzare automaticamente i controller per un repertorio diversificato [di] comportamenti per robot con le gambe. Incorporando tecniche di adattamento del dominio efficienti nel processo di formazione, il nostro sistema è in grado di apprendere politiche adattative in simulazione che possono essere rapidamente adattate per la distribuzione nel mondo reale. “

Le politiche di controllo utilizzate durante il processo di apprendimento per rinforzo avevano i loro limiti. A causa dei vincoli imposti dall’hardware e dagli algoritmi, alcuni robot semplicemente non potevano fare. Non erano in grado di correre o fare grandi salti, per esempio. Inoltre, le politiche apprese non hanno mostrato la stessa stabilità rispetto ai movimenti progettati manualmente. Il team di ricerca vuole proseguire il lavoro rendendo i controller più robusti e in grado di apprendere da diversi tipi di dati. Idealmente, le versioni future del framework saranno in grado di apprendere dai dati video.

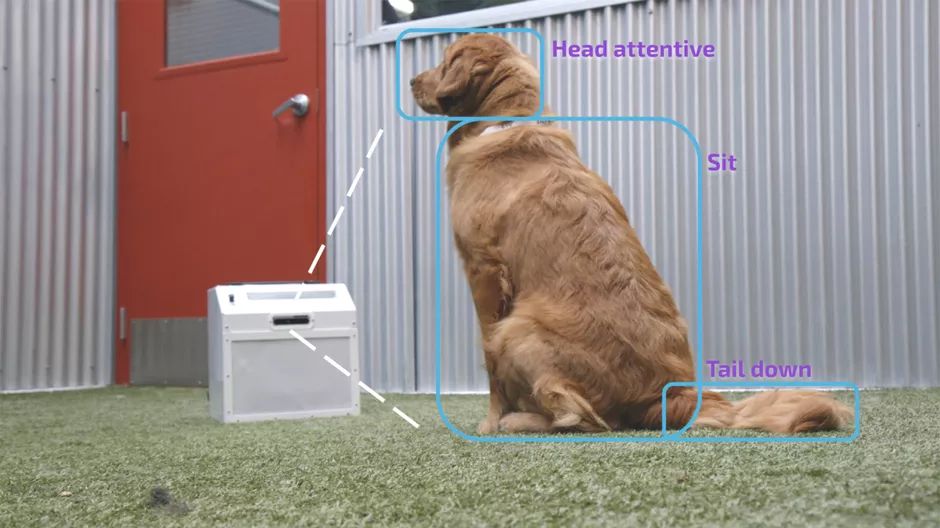

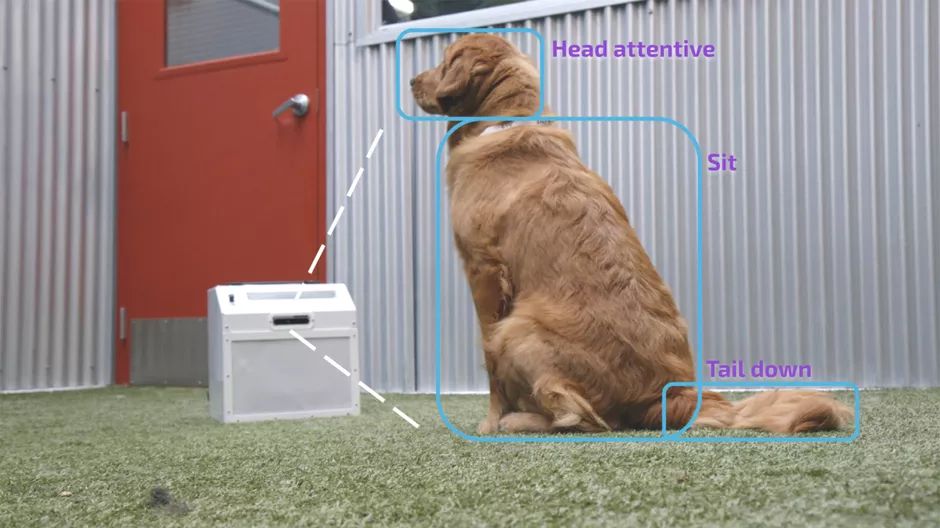

Researchers at the University of Washington created an artificial intelligence system that mimics a dog’s behavior.