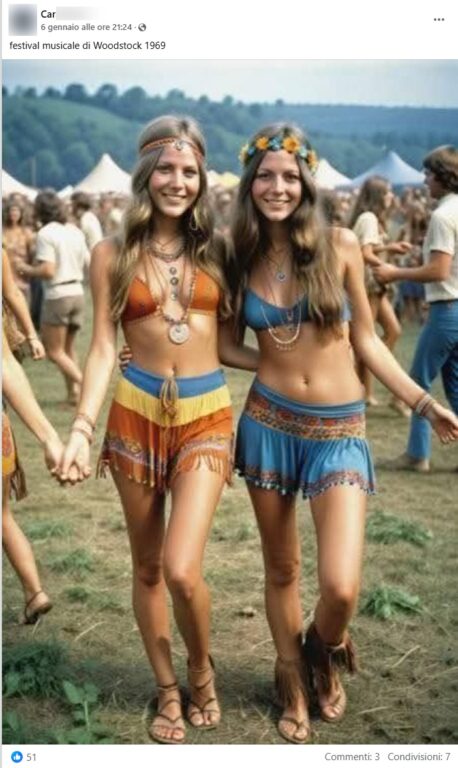

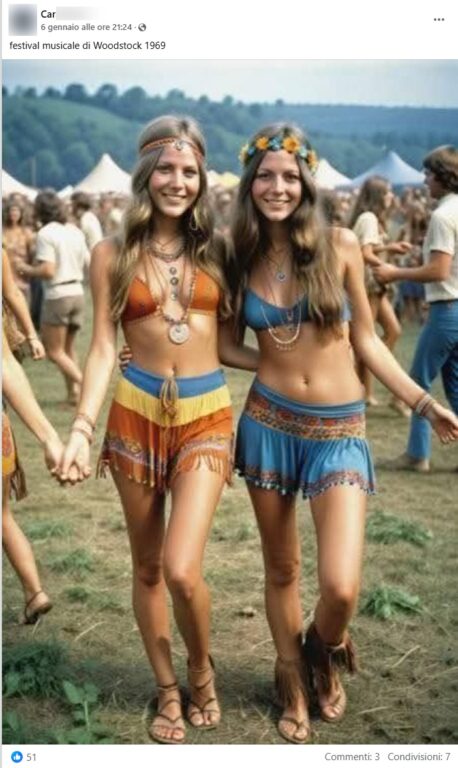

Recentemente, sui social media ha iniziato a circolare un’immagine che, a prima vista, sembra ritrarre due giovani donne immerse nell’atmosfera del leggendario festival di Woodstock del 1969. Vestite con abiti tipici dell’epoca, l’immagine evoca immediatamente lo spirito libero e ribelle di quegli anni. Tuttavia, un’analisi più attenta rivela che questa fotografia non è affatto autentica, bensì una creazione realizzata attraverso l’Intelligenza Artificiale (IA).

L’immagine presenta infatti alcuni dettagli che tradiscono la sua origine artificiale. In particolare, la mano destra della donna a sinistra appare innaturale, con dita fuse insieme in modo anomalo, un errore comune nelle immagini generate dall’IA. Inoltre, il piede sinistro della stessa figura mostra due alluci e un dito medio, per un totale di tre dita, una configurazione anatomica impossibile. Questi difetti sono indicativi delle limitazioni attuali delle tecnologie di generazione di immagini, che spesso faticano a riprodurre correttamente dettagli complessi come mani e piedi.

La diffusione di questa immagine solleva importanti questioni riguardo all’uso dell’Intelligenza Artificiale nella creazione di contenuti visivi. Se da un lato queste tecnologie offrono opportunità senza precedenti per l’arte e la creatività, dall’altro pongono sfide significative in termini di autenticità e disinformazione. La capacità di generare immagini realistiche ma false può essere sfruttata per diffondere informazioni ingannevoli, manipolare l’opinione pubblica o riscrivere eventi storici.

È fondamentale, quindi, sviluppare strumenti e competenze per riconoscere e contrastare queste falsificazioni. L’alfabetizzazione digitale diventa sempre più cruciale in un’epoca in cui la linea tra realtà e finzione è resa sottile dalle tecnologie emergenti. Gli utenti dei social media e di altre piattaforme online devono essere educati a valutare criticamente i contenuti che incontrano, prestando attenzione ai dettagli e utilizzando risorse affidabili per verificare l’autenticità delle informazioni.

Inoltre, le piattaforme stesse hanno la responsabilità di implementare misure per rilevare e segnalare contenuti generati artificialmente, collaborando con esperti di IA e organizzazioni di fact-checking per mantenere l’integrità delle informazioni condivise. La trasparenza nell’uso dell’IA e la promozione di pratiche etiche nella sua applicazione sono passi essenziali per mitigare i rischi associati alla disinformazione visiva.