OpenAI ha recentemente aggiornato il suo “Preparedness Framework”, il sistema interno utilizzato per valutare la sicurezza dei modelli di intelligenza artificiale. Questo aggiornamento arriva in un contesto di crescente accelerazione nei cicli di rilascio delle tecnologie IA e in risposta a un’industria che sta lanciando prodotti sempre più rapidamente. La novità principale riguarda la strategia di OpenAI per rispondere ai modelli di IA rilasciati da concorrenti che presentano rischi elevati senza adeguate misure di sicurezza.

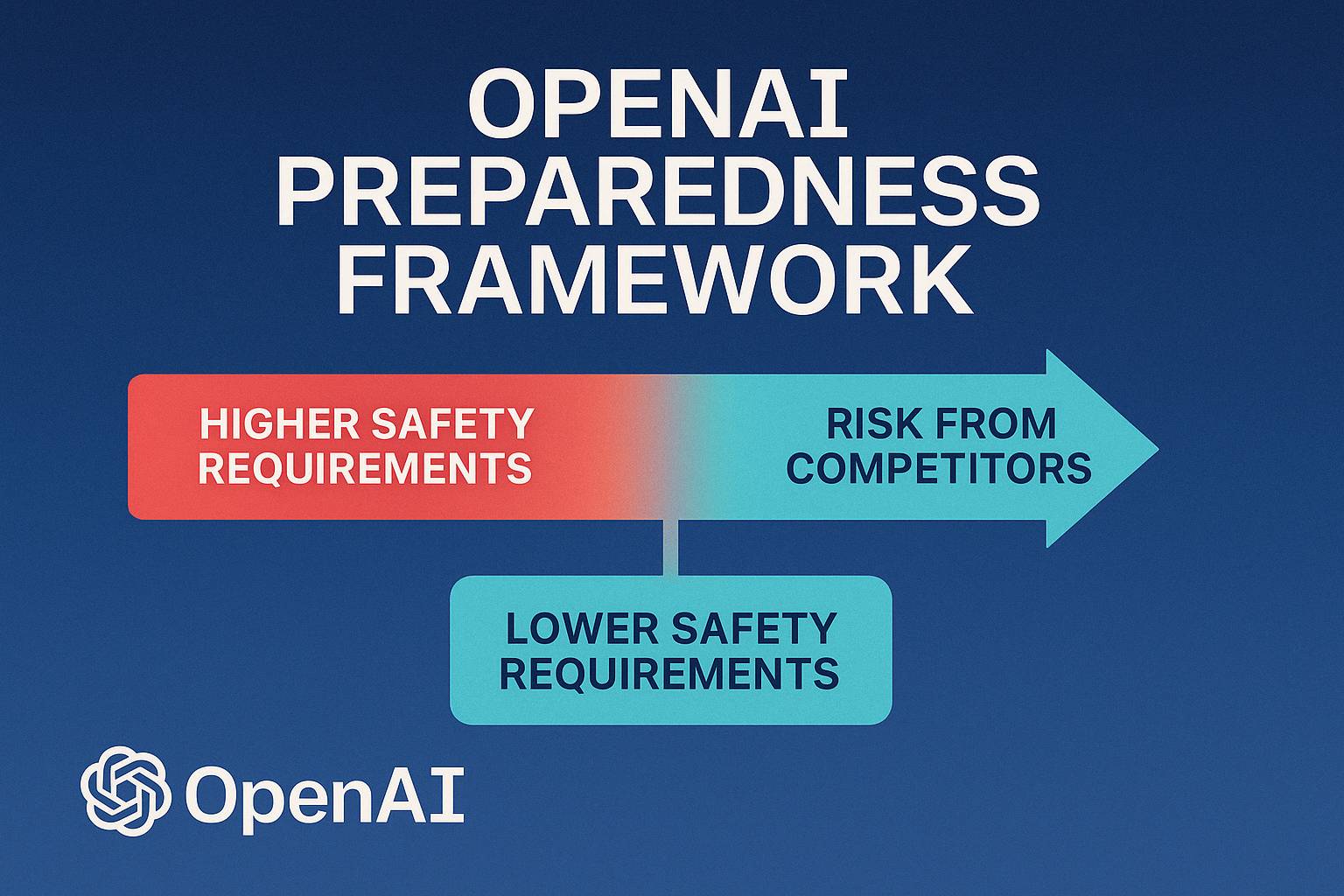

Nel suo annuncio, OpenAI ha affermato che se altre aziende decidono di rilasciare sistemi di IA a rischio elevato senza adottare le necessarie precauzioni, l’azienda stessa potrebbe dover abbassare i suoi requisiti di sicurezza, pur mantenendo “un livello più elevato di misure di protezione”. In altre parole, se i concorrenti rilasciano prodotti potenzialmente pericolosi, OpenAI potrebbe rispondere riducendo i test di sicurezza e rendendo disponibili i propri modelli più rapidamente, ma sempre con l’obiettivo di mantenere un certo standard di sicurezza.

Questa dichiarazione riflette il crescente ritmo dei cicli di rilascio dei modelli IA. Un esempio di questo è il modello “o4-mini” di OpenAI, che è in attesa di essere lanciato solo sette mesi dopo l’introduzione del modello “o1”, dimostrando come la velocità di innovazione stia aumentando notevolmente nel settore. Sebbene non sia chiaro a quale azienda specifica si stia riferendo questo annuncio, è evidente che OpenAI sta cercando di adattarsi alla rapida evoluzione del mercato.

Tuttavia, OpenAI ha anche ricevuto critiche per aver sacrificato in passato alcuni standard di sicurezza per velocizzare i lanci dei prodotti. Secondo quanto riportato dal Financial Times, l’azienda avrebbe fissato periodi di revisione della sicurezza molto brevi per alcuni dei suoi modelli, con test che a volte venivano condotti su versioni preliminari anziché su quelle definitive. Questo approccio ha sollevato preoccupazioni riguardo alla qualità e all’affidabilità dei test di sicurezza.

Il nuovo framework di OpenAI indica anche un aumento dell’uso di sistemi automatizzati per accelerare i processi di valutazione dei modelli. Pur confermando di non aver abbandonato completamente i test manuali, OpenAI ha ampliato il ricorso a strumenti automatizzati per tenere il passo con i ritmi sempre più rapidi dei cicli di rilascio. Questo approccio ha suscitato discussioni, con alcuni che ritengono che la sicurezza interna di OpenAI stia subendo un indebolimento. Tuttavia, l’azienda ha fermamente negato tali accuse, spiegando che la flessibilità nell’adattarsi al mercato non compromette i livelli di protezione.