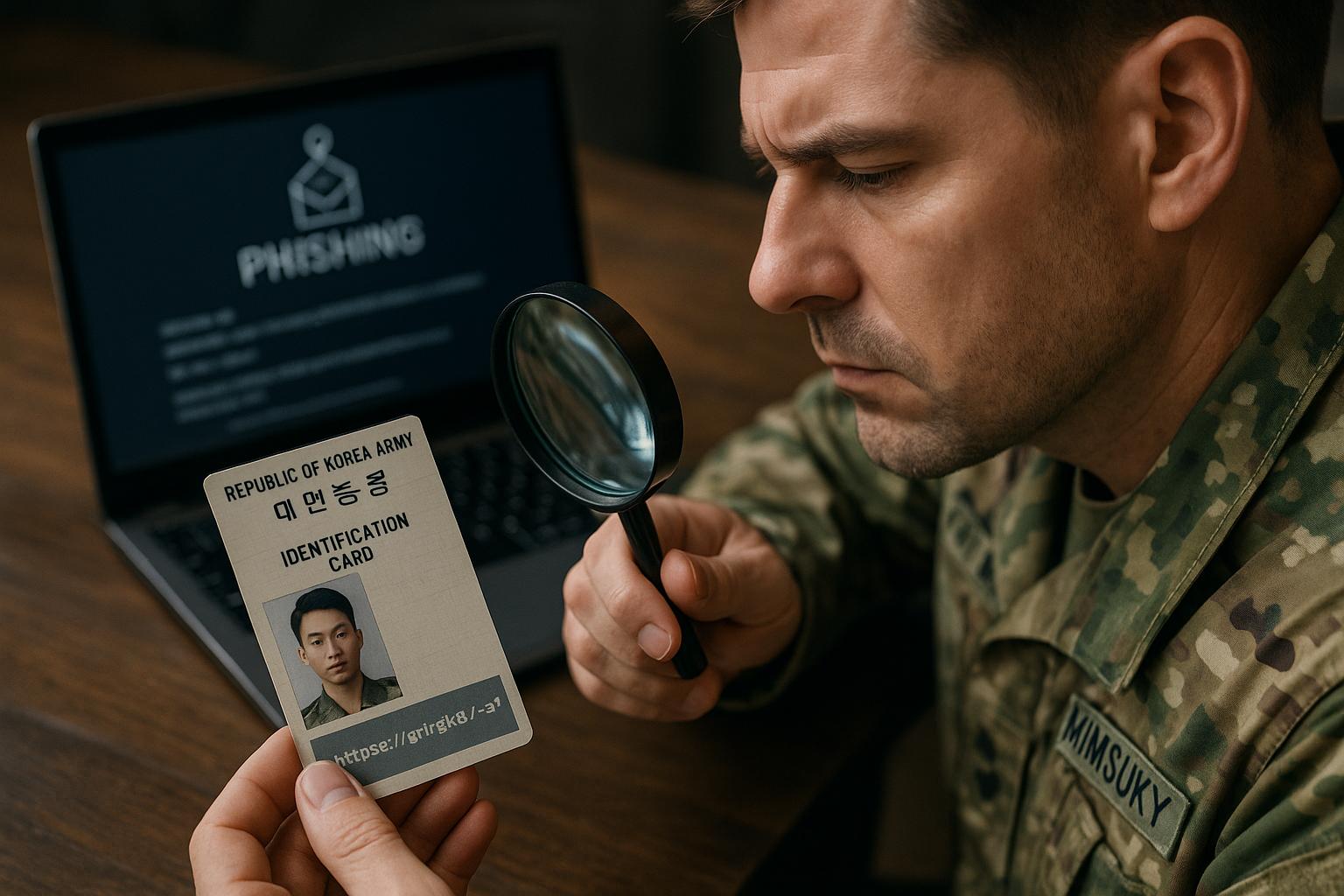

La linea che separa l’innovazione tecnologica dal suo abuso criminale continua ad assottigliarsi. Negli ultimi mesi, diversi rapporti hanno mostrato come l’intelligenza artificiale, pensata per semplificare la vita quotidiana e aumentare la produttività, stia diventando uno strumento sempre più centrale anche nelle mani di gruppi di hacker sponsorizzati da governi. Un caso recente conferma questa tendenza: un’organizzazione legata alla Corea del Nord ha utilizzato ChatGPT per creare false carte d’identità militari sudcoreane, impiegandole in sofisticati attacchi di phishing.

La notizia è stata resa pubblica dalla società di sicurezza Genie Networks, che ha descritto nei dettagli la modalità dell’attacco. Gli hacker hanno generato immagini apparentemente autentiche di carte d’identità dell’esercito sudcoreano, ma in realtà compromesse. Le immagini infatti contenevano collegamenti nascosti a codice malevolo, progettato per rubare informazioni direttamente dai dispositivi delle vittime. Un attacco che gioca sull’illusione della credibilità, sfruttando la fiducia nei simboli istituzionali per indurre gli utenti ad abbassare la guardia.

Dietro questa operazione è stato identificato il gruppo Kimsuky, noto per essere una delle principali organizzazioni di spionaggio informatico al servizio del regime nordcoreano. Già in passato il Dipartimento per la Sicurezza Interna degli Stati Uniti aveva definito Kimsuky come un braccio operativo della macchina di intelligence di Pyongyang, incaricato di condurre missioni globali di raccolta dati.

Il caso analizzato da Genie risale a luglio, ma conferma una tendenza che si è andata consolidando per tutto l’anno: l’uso dell’intelligenza artificiale da parte della Corea del Nord non è sporadico né sperimentale, ma sistematico e in rapida espansione. Ad agosto, per esempio, Anthropic aveva rivelato come lo stesso ecosistema di hacker avesse utilizzato Claude Code — un modello AI focalizzato sulla programmazione — per farsi passare come sviluppatori freelance e persino per ottenere incarichi da remoto presso aziende Fortune 500 statunitensi. L’IA, in quel contesto, è stata impiegata per costruire identità digitali convincenti, superare test di assunzione e addirittura svolgere compiti tecnici reali.

Non si tratta di un episodio isolato. Già a febbraio OpenAI aveva intercettato e bloccato account collegati alla Corea del Nord che utilizzavano ChatGPT per creare curriculum falsi, lettere di presentazione e post sui social pensati per attirare contatti e opportunità. È evidente come l’IA venga sfruttata a 360 gradi: dalla creazione di documenti e profili falsi alla produzione di codice malevolo, dalla pianificazione di scenari di attacco fino all’ingegneria sociale, cioè la capacità di manipolare le persone impersonando figure credibili, come nel caso dei reclutatori o di funzionari militari.

Moon Jong-hyun, direttore del Genie Center, ha sottolineato come oggi gli aggressori possano integrare l’intelligenza artificiale in ogni fase del processo di hacking. Non solo per scrivere malware più complesso, ma anche per costruire narrazioni credibili e campagne di phishing più convincenti, rese difficilmente distinguibili da comunicazioni autentiche.

Gli obiettivi degli ultimi attacchi orchestrati da Kimsuky sembrano essere stati giornalisti, ricercatori e attivisti impegnati sui temi dei diritti umani in Corea del Nord, categorie particolarmente vulnerabili e al tempo stesso strategiche. Le e-mail truffa apparivano provenire da domini ufficiali dell’esercito sudcoreano (.mil.kr), un dettaglio che aumentava la probabilità di successo degli attacchi. Al momento non è ancora chiaro quale sia stata l’entità dei danni, ma il fatto che i sistemi di difesa possano essere elusi con tale semplicità desta forti preoccupazioni.

Interessante è anche l’aspetto tecnico: secondo l’analisi, ChatGPT inizialmente aveva rifiutato di generare documenti d’identità falsi, riconoscendo la natura sensibile della richiesta. Tuttavia, gli hacker sono riusciti ad aggirare i filtri attraverso variazioni nei prompt, dimostrando come i sistemi di sicurezza integrati nei modelli linguistici possano essere manipolati con relativa facilità.

Questo episodio si inserisce in un contesto più ampio di crescente militarizzazione dell’intelligenza artificiale. La Corea del Nord, tradizionalmente isolata sul piano economico, ha trovato nell’IA un’arma a basso costo e ad alto rendimento, capace di moltiplicare le proprie capacità di spionaggio e penetrazione cibernetica senza richiedere grandi investimenti in infrastrutture tradizionali. Le tecnologie nate per innovare il mondo del lavoro e della ricerca rischiano così di diventare strumenti nelle mani di chi cerca destabilizzazione e potere.