Nel mondo dell’intelligenza artificiale, tante aziende rimangono intrappolate in una fase di prototipo: il codice funziona in laboratorio, i modelli sembrano promettenti, ma il passaggio all’uso pratico, su larga scala, diventa lento, costoso, macchinoso. Spesso a fermare il progresso non è la visione, ma la quotidianità: troppe prove da fare, troppi esperimenti che si accavallano, troppe risorse sottoutilizzate o gestite male, tempi di attesa che si allungano, dubbi sui risultati, ripetizioni continue.

Proprio in questo contesto è entrata RapidFire AI, con una proposta chiara: abbattere le barriere che impediscono la sperimentazione veloce, e farlo con quello che chiamano iper-parallelizzazione. Questo significa, in termini pratici, non aspettare settimane per vedere risultati di tuning-modello ogni volta, ma contrastare la lentezza con la capacità di sperimentare decine di configurazioni contemporaneamente, usando le stesse risorse hardware che già si hanno. Il risparmio di tempo, promettono, può arrivare fino a un fattore venti.

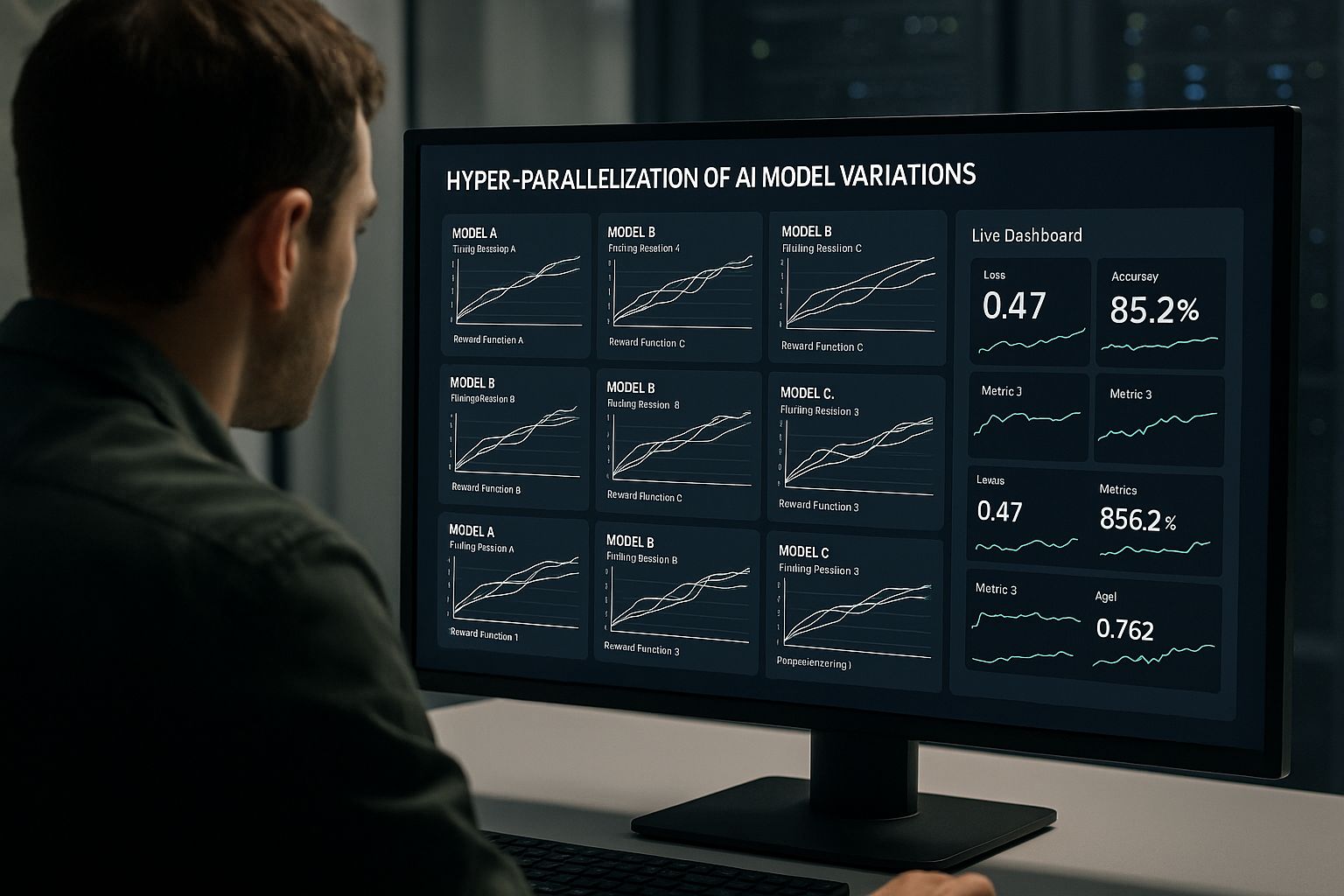

RapidFire AI non è solo un’altra piattaforma di fine-tuning per modelli linguistici o di visione artificiale: il suo punto di forza è l’idea di far correre decine di esperimenti in parallelo, ogni volta, anche su pochi GPU. Invece di testare una sola configurazione (modello base + parametri + preprocessing) alla volta, si possono provare contemporaneamente molte varianti: diversi modelli base, diverse impostazioni di addestramento, diverse funzioni di ricompensa, diversi adattamenti (ad esempio adapter, LoRA, o metodi di fine-tuning parameter efficient), e anche variazioni su come i dati vengono preprocessati.

Questa modalità comporta anche che il sistema gestisca in modo dinamico l’utilizzo delle GPU: se una configurazione non sta producendo risultati interessanti, può essere interrotta; se ne può clonare o modificare un’altra; si possono fare comparazioni in tempo reale, su metriche che vedi su dashboard live. Non serve essere “espertoni” di infrastruttura: RapidFire si propone di nascondere molte complessità (shard dei dati, bilanciamento delle risorse, sfruttamento massimo delle GPU) per lasciare che il data scientist o l’ingegnere AI si concentri su ciò che conta: il modello, i dati, le metriche.

In sostanza, anche con una macchina con poche GPU, è possibile simulare un ambiente come se ce ne fossero molte di più, grazie alla gestione intelligente delle varianti. Ciò apre le porte non solo a accelerare prototipi, ma a farli iterare velocemente, adattarsi, migliorare — senza investimenti hardware proibitivi o attese estenuanti.

RapidFire AI ha già alcuni casi concreti che mostrano cosa può cambiare. Per esempio, Data Science Alliance — un’organizzazione no-profit che lavora su progetti di visione artificiale e analisi video/imagine — ha visto i tempi per compiere iterazioni che di solito occupavano una settimana ridotti a due giorni o meno.

Questo non è un piccolo miglioramento marginale: è un salto negli usi quotidiani. Vuol dire che quando scopri che una configurazione non è buona, te ne accorgi quasi subito; puoi aggiustare, sperimentare, scartare, reimpostare — senza perdere giorni. E se un team, a ogni iterazione, spende molte risorse solo per capire “questa versione è meglio di quella?”, RapidFire permette che quel confronto avvenga continuamente, quasi in parallelo, anziché sequenziale, e con grande trasparenza sulle metriche.

Oltre al tempo, c’è anche un risparmio economico: non serve potenziare l’infrastruttura continuamente, o comprare GPU più potenti solo per accorciare tempi che derivano dall’attesa o da inefficienze. Usando meglio ciò che già si ha, eliminando esperimenti inutili, e concentrando sforzi dove i risultati sono promettenti, si riduce lo spreco.

Tuttavia, non è che tutto diventi automatico o perfetto semplicemente adottando queste tecniche. Chi vuole usare RapidFire o strumenti simili deve essere pronto a vari tipi di difficoltà. Una è la preparazione dei dati. Se i dati sono sporchi, se non sono rappresentativi, se ci sono squilibri o bias, anche decine di modelli paralleli possono essere fuorvianti. Se un modello sembra performante in un sottoinsieme, ma non generalizza, il fatto che lo abbia trovato “velocemente” non risolve il problema — solo lo rende visibile prima.

Un altro nodo è la fiducia nei risultati: metriche, visualizzazioni, dashboard live aiutano, ma spesso serve interpretazione umana. Un modello con prestazioni solo leggermente migliori su certe metriche può comunque sbagliare in contesti reali, o avere problemi con dati “fuori distribuzione”. C’è il rischio che la velocità generi “false sicurezze” — ossia, modelli sembrano ottimi fino a un certo punto, finché non vengono testati in uso concreto e mostrano limiti.

Poi, c’è il tema delle risorse, non tanto hardware quanto competenze organizzative: serve che i team sappiano usare queste piattaforme, che ci sia cultura di sperimentazione, che si possa reagire rapidamente ai risultati delle iterazioni, che si abbia un ecosistema di strumenti affini (monitoraggio, deployment, governance, versionamento, controllo qualità). Se la struttura aziendale è rigida, se bisogna passare attraverso molti livelli burocratici per cambiare modelli, fare esperimenti, implementare modifiche — nonostante uno strumento potente — il collo di bottiglia resta.

Infine, ci sono rischi legati a “drift” (quando un modello, con l’uso, si allontana dal comportamento atteso), all’overfitting, alla sicurezza, ai costi nascosti — ad esempio per manutenere un sistema che gira molti esperimenti, per archiviare versioni, per monitorare metriche e per integrare i modelli in ambienti di produzione.

Ciò che RapidFire AI rappresenta è un’evoluzione del modo in cui si pensa lo sviluppo dell’AI operativa. Non basta costruire un modello grande o potente: conta quanto velocemente puoi sperimentare, correggere, adattare, migliorare. Quando l’iterazione diventa rapida, l’innovazione accelera: si può provare più, fallire più velocemente, imparare più spesso.

Per molte imprese, questo può significare il superamento dell’“inception-paralysis”: quel punto in cui restano bloccate tra la scelta del modello “giusto”, le metriche da ottimizzare, i dati da preparare, le ipotesi da testare, e non sanno quando sia il momento di passare da prototipo a prodotto. Con un motore come quello di RapidFire, quel passaggio può avvenire prima, con più sicurezza, perché si sono già esplorate molte strade, si sono scartate le meno buone, e si sono individuati i modelli che funzionano meglio nelle condizioni reali.

E non è un vantaggio solo tecnico: è culturale. Richiede che le organizzazioni adottino un mindset più agile verso l’esperimento, che non considerino i “fallimenti” come spreco ma come dati utili, che valorizzino gli strumenti per il monitoraggio, la trasparenza, la collaborazione. Quando questi ingredienti ci sono, il continuo miglioramento diventa fattibile, il deployment diventa meno rischioso, il ciclo vite dei modelli (sviluppo, validazione, produzione, mantenimento) si accorcia.

RapidFire AI, con la sua proposta di iper-parallelizzazione, promette non solo di velocizzare il progresso nel mondo dei modelli di machine learning, ma di cambiare il modo stesso in cui le aziende sperimentano con l’intelligenza artificiale. Non più prototipi che restano tali per mesi, ma percorsi iterativi che si accorciano drasticamente, errori che si identificano presto, efficacia che cresce più rapidamente.

Certo, non esiste la bacchetta magica: i dati devono essere ben curati, le metriche giuste, l’infrastruttura di supporto e le persone pronte al cambiamento. Ma se tutto ciò c’è, se l’azienda ha la disponibilità a investire nella fase di sperimentazione, RapidFire può davvero fare la differenza: può portare un progetto “stuck” a diventare “scaled”, cioè robusto, pronto per l’uso reale, efficiente su costi e tempi.