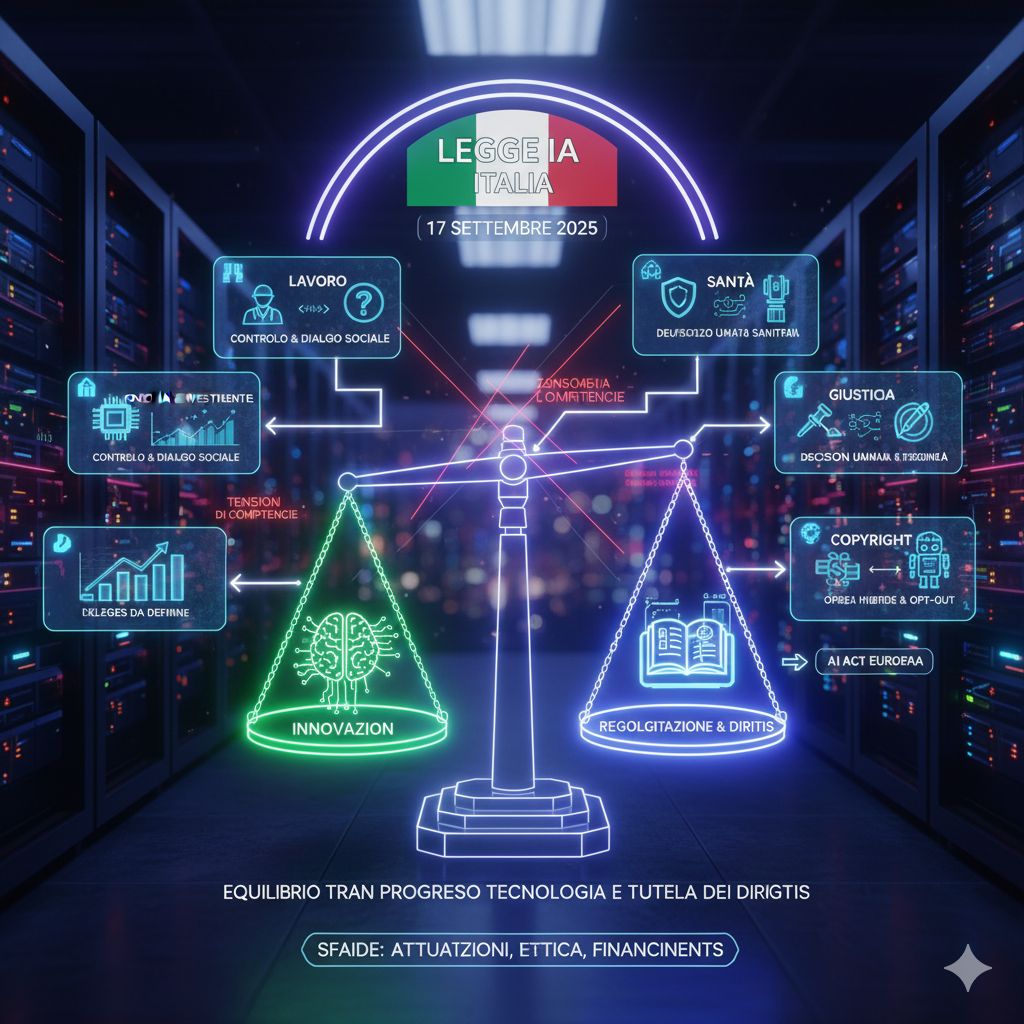

Quando l’Italia ha dato l’ultimo via libera parlamentare alla legge sull’intelligenza artificiale (AI) lo scorso 17 settembre, si è parlato di una “svolta per il futuro”. Il governo ha celebrato un risultato che avrebbe dovuto segnare la nascita di un quadro organico nazionale, capace di coniugare innovazione tecnologica e tutela dei diritti.

Tuttavia, dietro la facciata istituzionale, emergono numerosi punti di tensione: zone d’ombra normative, deleghe al governo da riempire, conflitti di competenze, e la sensazione che molte occasioni siano state mancate.

Il merito più grande riconosciuto alla nuova legge è la sua ambizione: quella di tenere insieme più obiettivi, anche quando sembrano in tensione l’uno con l’altro. Da una parte, l’Italia ha voluto riaffermare un approccio “antropocentrico”, ossia l’idea che la tecnologia debba servire le persone e non viceversa. Dall’altra, il testo legislativo tenta di armonizzare l’AI con strumenti già avviati – come la Strategia nazionale sull’intelligenza artificiale e il regolamento europeo AI Act – senza lasciare fuori settori critici come lavoro, sanità, giustizia.

Questa ambizione è ben rappresentata da quanto affermato dal giurista Oreste Pollicino: la legge potrà essere considerata “fondativa” nel contesto nazionale, come punto di partenza per gettare un ponte fra ricerca, sviluppo, diritti e responsabilità.

Ma – ed è qui che nascono le difficoltà – una legge “fondativa” rischia di restare incompiuta, se non accompagnata da decreti, regolamenti e un’attuazione attenta.

Quanto ai rischi: uno dei principali elementi su cui molti osservatori hanno criticato il testo riguarda l’allontanamento dall’“approccio per categorie di rischio” previsto dall’AI Act europeo. Le imprese italiane, ad esempio Confindustria, hanno avvertito che l’imposizione di obblighi uniformi potrebbe risultare troppo gravosa per sistemi AI che operano in contesti a basso rischio.

Una legge che regola una materia trasversale come l’intelligenza artificiale inevitabilmente entra in terreni di competenza che si sovrappongono. Nel testo italiano, la governance è affidata in gran parte all’Agenzia per la cybersicurezza nazionale (ACN) e all’Agenzia per l’Italia digitale (AgID). Ma rimangono in vita autorità indipendenti (Garante della Privacy, Agcom) con funzioni che rischiano l’attrito.

In Parlamento è stato istituito un Comitato di raccordo presso la Presidenza del Consiglio per armonizzare le diverse competenze. Eppure, alcune autorità – come il Garante per la privacy – hanno lamentato che la loro capacità di controllo rischia di essere sbiadita, mentre Agcom teme di restare fuori da decisioni che riguardano i servizi digitali, già regolati da altre normative come il Digital Services Act.

In altre parole: abbiamo una rete che vuole essere molto ampia, ma i nodi tra i fili non sono ancora ben fissati.

Un capitolo complesso riguarda il rapporto tra AI e copyright: come tutelare le opere “ibride” (cioè generate in parte dall’uomo e in parte da sistemi di intelligenza artificiale)? La legge italiana prevede che l’opera generata insieme all’AI possa essere protetta solo se l’apporto creativo predominante appartenga all’essere umano — ma come provarlo, in pratica?

Inoltre, il testo disciplina l’uso del text and data mining (estrazione di testi e dati) da opere protette: viene lasciata all’autore la facoltà di opzionare l’“opt-out”. Questa impostazione è stata criticata, tra gli altri, dalla Federazione industria musicale italiana (FIMI), che parla di uno sbilanciamento verso l’AI rispetto ai diritti degli autori. L’European Guild for Artificial Intelligence Regulation (Egair) ha definito il risultato come un possibile “plagio sistematico passivo”.

Un ulteriore nodo riguarda gli accordi tra editori e aziende titolari di modelli AI: spesso coperti da accordi di riservatezza (NDA), rischiano di negare trasparenza non solo agli utenti, ma anche agli stessi giornalisti i cui contenuti sono usati. La Federazione nazionale della stampa ha sottolineato che questo deficit informativo va colmato, non solo per tutelare i lettori ma anche per preservare il ruolo dei giornalisti nel conoscere come vengono impiegati i loro contenuti.

Uno dei temi più “sensibili” e sentiti è il rapporto tra automazione, AI e condizioni di lavoro. La legge definisce alcuni contesti in cui l’AI può essere usata: miglioramento delle condizioni, incremento della produttività, salvaguardia dell’integrità psico-fisica. Il datore di lavoro dovrà informare i dipendenti con un’apposita informativa.

Tuttavia, sindacati quali CGIL, CISL e UIL hanno criticato l’assenza di qualsiasi riferimento esplicito al “controllo a distanza” – un tema oggi molto attuale nei luoghi di lavoro digitalizzati – e la mancanza di una previsione di consultazione preventiva con le organizzazioni sindacali prima di introdurre sistemi di AI per organizzare il lavoro.

Si aggiunge la criticità che, per molte previsioni normative (es. l’Osservatorio sul lavoro), non sono previsti nuovi finanziamenti: tutto dovrà essere realizzato con risorse da destinarsi “per quanto possibile” già esistenti.

In sostanza, l’introduzione dell’AI nel mondo del lavoro è riconosciuta come potenzialmente trasformativa, ma il testo non affronta con chiarezza elementi strutturali fondamentali: controllo, dialogo sociale, bilanciamento dei poteri in azienda.

Nel settore sanitario la legge fa qualcosa di importante: riconosce che il riutilizzo dei dati sanitari per addestrare modelli di AI può essere “di rilevante interesse pubblico”. Questo rappresenta un cambio di paradigma, perché apre la strada a innovazioni nella sanità digitale.

Allo stesso tempo, la legge ha tolto l’obbligo del parere dei comitati etici per utilizzi a fini di ricerca, riducendo un livello di garanzia che era prima previsto. È una scelta che ha sollevato perplessità: è possibile bilanciare la rapidità dell’innovazione con il dovere della tutela etica?

Il testo delega al ministro della Salute l’elaborazione di decreti che disciplinino il fascicolo sanitario elettronico, le sorveglianze in sanità, e più in generale la governance dei dati sanitari. Questi aspetti decisivi, però, restano rinviati, pendenti nelle mani dell’esecutivo.

La legge introduce nuove fattispecie delittuose e aggravanti legate all’uso illecito dell’AI. Nel caso dei deepfake, si prevede fino a 5 anni di reclusione, con azione penale obbligatoria se coinvolte autorità pubbliche. Però, alcune disposizioni risultano vaghe o contraddittorie: per molti osservatori, la vaghezza normativa pesa di più delle pene severe indicate.

Gravi perplessità sono state sollevate dall’Unione delle camere dei penalisti italiani (UCPI), che denuncia come la regolazione dell’uso dell’AI nelle indagini preliminari sia affidata integralmente al governo, senza sufficienti garanzie di trasparenza, proporzionalità o spiegabilità dei metodi. Anche il ministero della Giustizia avrà compiti larghissimi: potrà disciplinare gli impieghi di AI nella giustizia, concedere sperimentazioni, fissare linee guida per magistrati e personale amministrativo.

Un elemento positivo, comunque, è che la legge rafforza la “clausola di riserva” al giudice della decisione finale, ovvero riconosce che la decisione sovrana spetta all’organo giurisdizionale.

In sede parlamentare è caduto l’obbligo di localizzare i server per sistemi pubblici sul territorio italiano: l’obbligo è stato sostituito da un’indicazione preferenziale verso soluzioni “tricolori” (italiane). Questo rappresenta una battuta d’arresto sul tema della sovranità digitale, tema su cui molte imprese e osservatori avevano puntato nei mesi precedenti.

Sul piano degli investimenti, la legge prevede un fondo (circa un miliardo) dedicato al capitale di rischio in imprese italiane operanti nei settori dell’AI, della cybersecurity, delle telecomunicazioni e delle tecnologie quantistiche. L’obiettivo dichiarato è incentivare startup, poli tecnologici e la crescita delle imprese innovative. Tuttavia, per molti imprenditori la chiave sarà nel “chi potrà accedere”: la norma rischia di favorire solo soggetti già ben inseriti nel panorama tech, lasciando fuori chi sta innovando ma non ha visibilità o risorse per competere.

InnovUp – che rappresenta aziende nella filiera dell’innovazione – ha avvertito che una “iper-normazione” può trasformarsi in un freno più che in una spinta. L’innovazione, dicono, ha molte facce, non sempre quelle della parola d’ordine “AI”.

La legge italiana sull’intelligenza artificiale segna senza dubbio un passo importante: costituisce un punto di partenza per nutrire un dibattito istituzionale e tecnico, per chiarire ruoli e responsabilità, per far crescere una cultura della regolazione tecnologica. È una legge che cerca di abbracciare tanto: sanità, lavoro, giustizia, diritti, industria.

Ma è innegabile che il testo presenti numerosi elementi lasciati a latere o rinviati. Le deleghe sono ampie; molti settori sensibili verranno definiti solo nei decreti attuativi. Il conflitto tra autorità è palpabile; la combinazione con il diritto europeo non è ancora fluida. Gli squilibri tra chi lavora con l’AI e chi crea contenuti (giornalisti, autori, artisti) non sono risolti. E nel mondo del lavoro, manca un confronto serio su controllo, trasparenza e partecipazione.