Nel mondo frenetico dei modelli di linguaggio e agenti intelligenti, cambiare è spesso sinonimo di progresso: una versione più potente, una nuova opzione, un plugin aggiuntivo. Eppure, come ci ricorda un recente articolo su VentureBeat, non è affatto scontato che “aggiornare” un agente AI porti benefici netti. In alcuni casi, una patch, un cambiamento di tool, una modifica nelle istruzioni possono produrre regressioni, fragilità o comportamenti inattesi.

L’azienda Raindrop, specializzata in monitoraggio e osservabilità per sistemi AI, ha lanciato uno strumento chiamato Experiments, pensato per consentire ai team di valutare in ambiente reale l’effetto delle modifiche sull’esperienza utente e sulle prestazioni dell’agente.

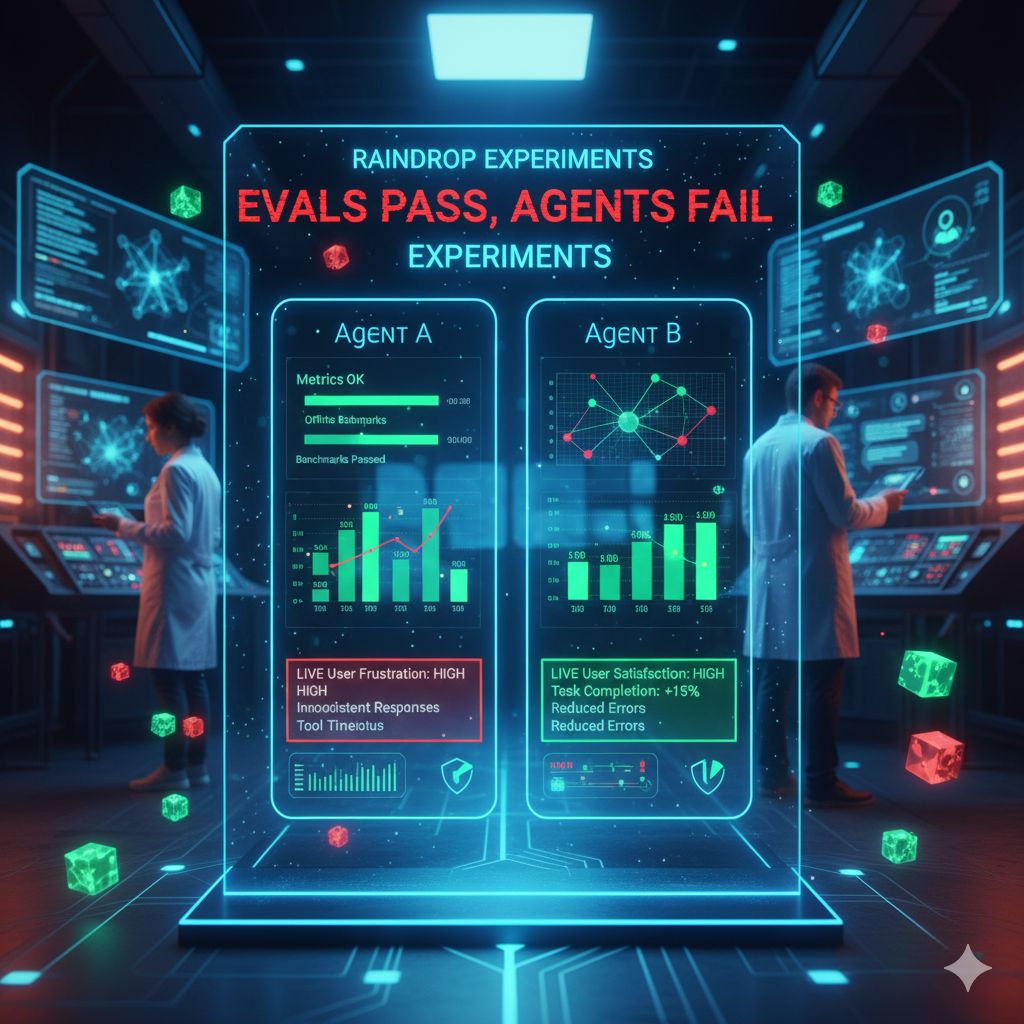

La premessa è che molti team si affidano ancora a pipeline di test tradizionali: si valuta l’agente con metriche offline, su dataset predefiniti, si misura la bontà di un modello con benchmark — e poi si spera che quando quel nuovo modello spinge in produzione le cose vadano bene. Ma tra il laboratorio e il mondo reale c’è un abisso: l’agente interagisce con contesti imprevedibili, con utenti che esprimono intenzioni fuori script, con conversazioni che si intrecciano, con tool esterni che si guastano. In quel salto, gli errori spesso “ciechi” emergono: l’agente si blocca, dimentica contesti, restituisce risposte incomplete o incoerenti. È il classico scenario evocato da uno slogan spesso ripetuto dai fondatori di Raindrop: “Evals pass, agents fail” — i test formali possono essere superati, ma l’agente fallisce quando serve davvero.

Experiments vuole colmare quel divario. Permette ai team di lanciare versioni parallele (A/B testing) dell’agente, cambiando un fattore — potrebbe essere il modello sottostante, l’accesso a un tool, la prompt o un parametro della pipeline — e osservare come, in una porzione reale di utenti, questi cambiamenti incidano su metriche chiave come la frequenza di errore, l’uso dei tool, la lunghezza delle risposte, il tasso di task completati positivamente. Il sistema avvisa se il campione non è sufficientemente grande per generare conclusioni affidabili e aiuta a evitare decisioni affrettate.

Una delle sfide profonde che Raindrop evidenzia è che le metriche che si usano tradizionalmente nei test non sono sempre allineate con l’esperienza reale: un agente potrebbe “sforare” troppo, oppure rispondere correttamente ma con un linguaggio troppo asettico, oppure usare uno strumento che in quel contesto concreto è lento, causando rallentamenti o timeout. In altri casi, un parametro molto utile in uno scenario può rivelarsi deleterio in un altro. Experiments offre la possibilità di guardare da vicino dove le regressioni stanno accumulandosi, tracciare i casi peggiori, risalire alle conversazioni che “hanno sofferto” e correggere con consapevolezza.

Dietro questa idea c’è una filosofia più ampia: l’AI non è un software statico, è un sistema dinamico. Le variabili cambiano: i dati, le modalità con cui gli utenti parlano, i tool che l’agente può usare, le condizioni esterne (latency, integrazioni). Aggiornare senza osservare è rischioso; iterare senza esperimenti è improvvisazione. Raindrop stessa è nata per affrontare ciò che definisce il “problema della scatola nera” dell’AI in produzione: modelli che falliscono “silenziosamente”, senza eccezioni o errori espliciti, ma con risposte strambe, incomplete, incoerenti — e senza strumenti che aiutino a capire “che cosa è andato storto”.

Il nuovo strumento non è per tutti: richiede volumi di interazioni utili per generare statistiche significative e un’infrastruttura che consenta di monitorare eventi, errori, segnali utente, feedback. Ma è un segno di come, nelle applicazioni AI aziendali, la distinzione tra “sviluppo” e “operazioni” si annulla: ogni cambiamento andrebbe trattato come un esperimento, misurato, validato, difettoso in parte e migliorabile.