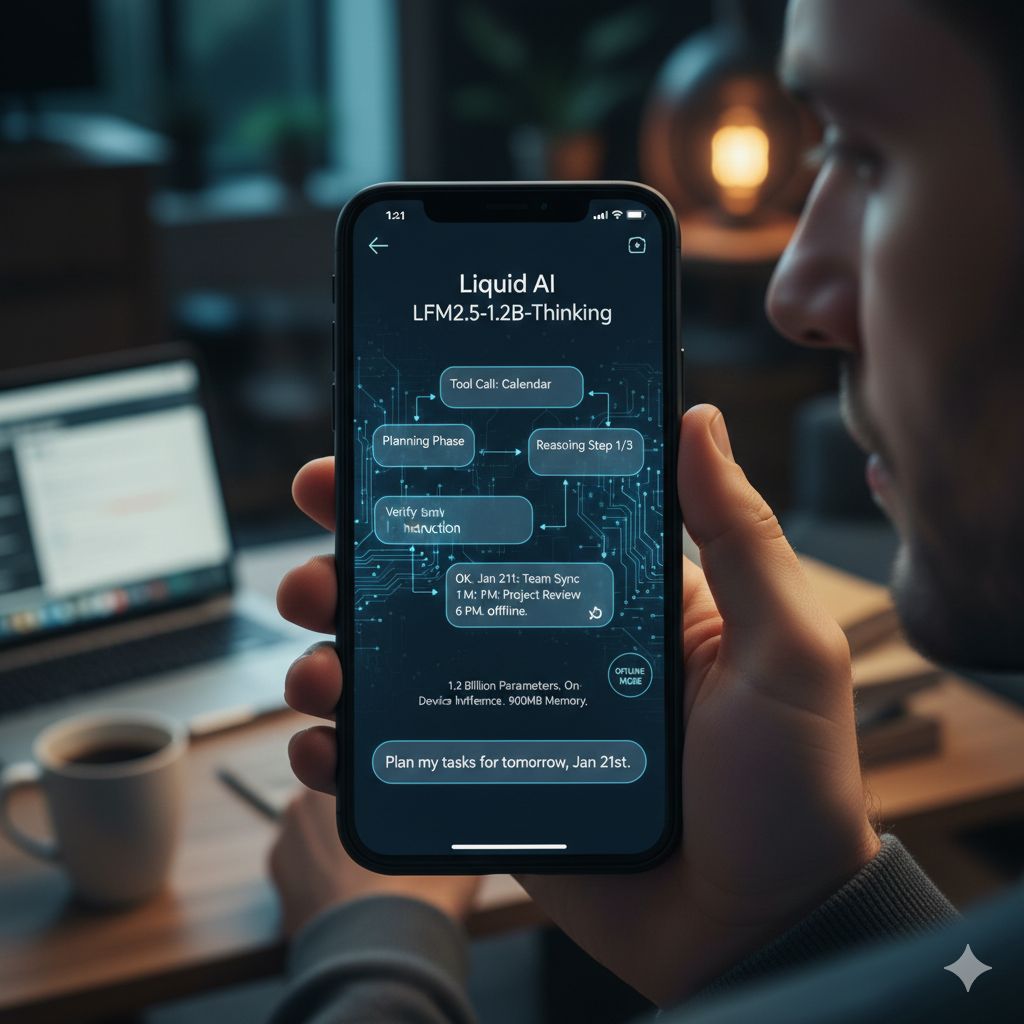

In un mondo AI dominato da modelli sempre più grandi e da infrastrutture cloud estremamente costose, la proposta di Liquid AI si muove in una direzione quasi controcorrente. L’azienda, già nota per il suo approccio innovativo basato sulle cosiddette reti neurali liquide e per i suoi Small Language Model, ha presentato un nuovo modello di inferenza che ridefinisce le aspettative su cosa sia possibile fare direttamente sui dispositivi consumer, senza connessione a Internet. Il modello, chiamato LFM2.5-1.2B-Thinking, è stato annunciato il 20 gennaio ed è descritto come il più piccolo modello di inferenza on-device mai rilasciato, progettato per funzionare completamente offline anche su smartphone di fascia recente.

LFM2.5-1.2B-Thinking appartiene alla serie LFM2.5 ed estende l’architettura LFM2 già esistente, ma con un obiettivo molto chiaro: portare capacità di ragionamento strutturato, pianificazione e uso di strumenti direttamente sull’edge. Con circa 1,17 miliardi di parametri, una finestra di contesto da 32.000 token e il supporto a otto lingue, il modello si colloca in una fascia dimensionale che, fino a poco tempo fa, era considerata insufficiente per compiti di inferenza complessi. Liquid AI ha invece dimostrato che, con un addestramento mirato e un’architettura ottimizzata, anche modelli di queste dimensioni possono offrire prestazioni sorprendenti.

Uno degli aspetti più interessanti è il profilo hardware. Il modello è in grado di operare su smartphone utilizzando circa 900 megabyte di memoria, una soglia che lo rende realisticamente utilizzabile su dispositivi consumer senza richiedere GPU dedicate o connessioni costanti al cloud. Questo apre scenari applicativi completamente nuovi, soprattutto in contesti dove la latenza, la privacy o la disponibilità di rete sono fattori critici. Non si tratta semplicemente di avere un chatbot offline, ma di disporre di un vero e proprio motore di ragionamento locale.

A distinguere LFM2.5-1.2B-Thinking dai modelli conversazionali tradizionali è proprio l’attenzione al “processo di pensiero”. Durante l’inferenza, il modello genera internamente tracce di ragionamento prima di produrre la risposta finale. Questa fase intermedia serve a pianificare la risoluzione del problema, preparare eventuali chiamate a strumenti e verificare istruzioni che richiedono più passaggi. È un approccio che privilegia la correttezza e la coerenza del risultato finale rispetto alla semplice fluidità della risposta, e che rende il modello particolarmente adatto a compiti agentici e a pipeline di elaborazione strutturata.

I risultati dei benchmark confermano questa impostazione. Rispetto alla versione “Instruct” della stessa serie, il miglioramento nel ragionamento matematico è netto, con un salto significativo nei punteggi su test come MATH 500. Anche la capacità di seguire istruzioni complesse e di utilizzare strumenti mostra progressi evidenti. In alcuni benchmark di inferenza, il modello riesce a competere con sistemi più grandi, come Qwen3-1.7B in modalità di ragionamento profondo, pur utilizzando circa il 40% di parametri in meno e generando un numero inferiore di token in output. Questo dato è particolarmente rilevante se si considera il contesto edge, dove ogni token e ogni millisecondo contano.

Un problema storico dei piccoli modelli di inferenza è il cosiddetto “ciclo di morte”, o doom loop, in cui il modello continua a ripetere il proprio processo di pensiero senza arrivare a una risposta conclusiva. Liquid AI ha affrontato direttamente questa criticità, intervenendo già nella fase di addestramento intermedio. L’uso di tracce di inferenza, seguito da fine-tuning con catene sintetiche, ordinamento per preferenze e apprendimento per rinforzo, ha portato a una drastica riduzione di questo fenomeno, con il tasso di occorrenza che è sceso da oltre il 15% a meno dello 0,5%. È un risultato che rafforza l’idea di un modello pensato per essere affidabile in contesti operativi reali, non solo per impressionare nei benchmark.

Anche l’efficienza computazionale è stata un obiettivo centrale del progetto. LFM2.5-1.2B-Thinking è in grado di elaborare centinaia di token al secondo su CPU moderne e decine di token al secondo su NPU mobili, mantenendo il consumo di memoria al di sotto di 1 GB. Questo lo rende utilizzabile su una vasta gamma di dispositivi, dai veicoli ai laptop, dai dispositivi IoT ai sistemi embedded, senza richiedere infrastrutture complesse.

Liquid AI suggerisce di utilizzare questo modello come un vero e proprio “cervello pianificatore” per sistemi basati su agenti, pipeline di estrazione dati e applicazioni di retrieval-augmented generation. Allo stesso tempo, l’azienda è chiara nel definire i limiti: non è un modello pensato per compiti che richiedono una conoscenza enciclopedica molto ampia o capacità di programmazione avanzata. La sua forza sta nel ragionamento contestuale, nella pianificazione e nell’esecuzione strutturata di compiti ben definiti.