Negli ultimi due anni il settore dell’intelligenza artificiale generativa ha mostrato una crescita dei ricavi che, per velocità e dimensioni, non ha molti precedenti nel mondo del software. Eppure, dietro i numeri impressionanti del fatturato, si nasconde una realtà molto più complessa. Secondo quanto riportato da The Information e ripreso da AI Times, sia Anthropic sia OpenAI stanno incontrando notevoli difficoltà nel trasformare questa espansione in vera redditività, principalmente a causa dell’aumento dei costi computazionali legati all’inferenza dei modelli.

Anthropic, in particolare, aveva previsto internamente di raggiungere un margine lordo intorno al 40% nel corso dell’ultimo anno per le attività rivolte ad aziende e sviluppatori. Si tratta comunque di un miglioramento enorme rispetto al margine negativo registrato nel 2024, quando l’azienda aveva toccato un impressionante –94%. Tuttavia, il risultato finale è stato inferiore di circa dieci punti percentuali rispetto alle aspettative iniziali, segnalando quanto sia difficile stimare e controllare i costi in un contesto tecnologico in rapida evoluzione.

La ragione principale di questo scostamento è da ricercare nei costi di inferenza, ovvero nelle spese sostenute per far girare i modelli su infrastrutture cloud. Anthropic si affida in larga misura ai server di Google e Amazon, e proprio questa dipendenza ha fatto sì che i costi effettivi risultassero superiori di circa il 23% rispetto alle previsioni. Un elemento chiave è anche la natura dei carichi di lavoro: l’utilizzo intensivo di codice e di contesti complessi da parte dei clienti di Anthropic comporta un consumo di potenza di calcolo più elevato rispetto a modelli focalizzati prevalentemente sulla conversazione testuale.

Il confronto con OpenAI rende questa dinamica ancora più evidente. Nonostante una base utenti in cui circa il 95% utilizza versioni gratuite, OpenAI è riuscita a mantenere un margine di profitto intorno al 46%, superiore a quello di Anthropic. Questo risultato è legato a una maggiore efficienza nel rapporto tra costi e ricavi, ma anche a un diverso mix di clientela. Mentre circa l’86% dei ricavi di Anthropic proviene da vendite aziendali tramite API, OpenAI genera solo il 40% dei propri ricavi da clienti enterprise, compensando con un’ampia diffusione consumer che, paradossalmente, si rivela meno costosa in termini di inferenza per singolo utente.

Questa analisi mette in luce un punto strutturale: la dipendenza dai fornitori di cloud rappresenta oggi uno dei principali freni alla redditività delle aziende di AI avanzata. Più i modelli crescono in dimensione e complessità, più l’inferenza diventa costosa, e più diventa difficile scalare i ricavi senza vedere esplodere i costi operativi. Non sorprende quindi che entrambe le aziende abbiano iniziato a muoversi con decisione verso un maggiore controllo diretto dell’hardware.

Anthropic ha recentemente accettato un accordo per l’acquisto di TPU di Google per un valore complessivo di circa 21 miliardi di dollari, una cifra che evidenzia quanto l’accesso privilegiato a chip specializzati sia considerato strategico. OpenAI, dal canto suo, non solo sta costruendo il proprio data center Stargate, ma sta anche sviluppando chip server proprietari dedicati all’inferenza. Secondo le informazioni disponibili, la fase di progettazione sarebbe già conclusa e la produzione sarebbe in corso, un segnale chiaro della volontà di ridurre la dipendenza da fornitori esterni nel medio-lungo periodo.

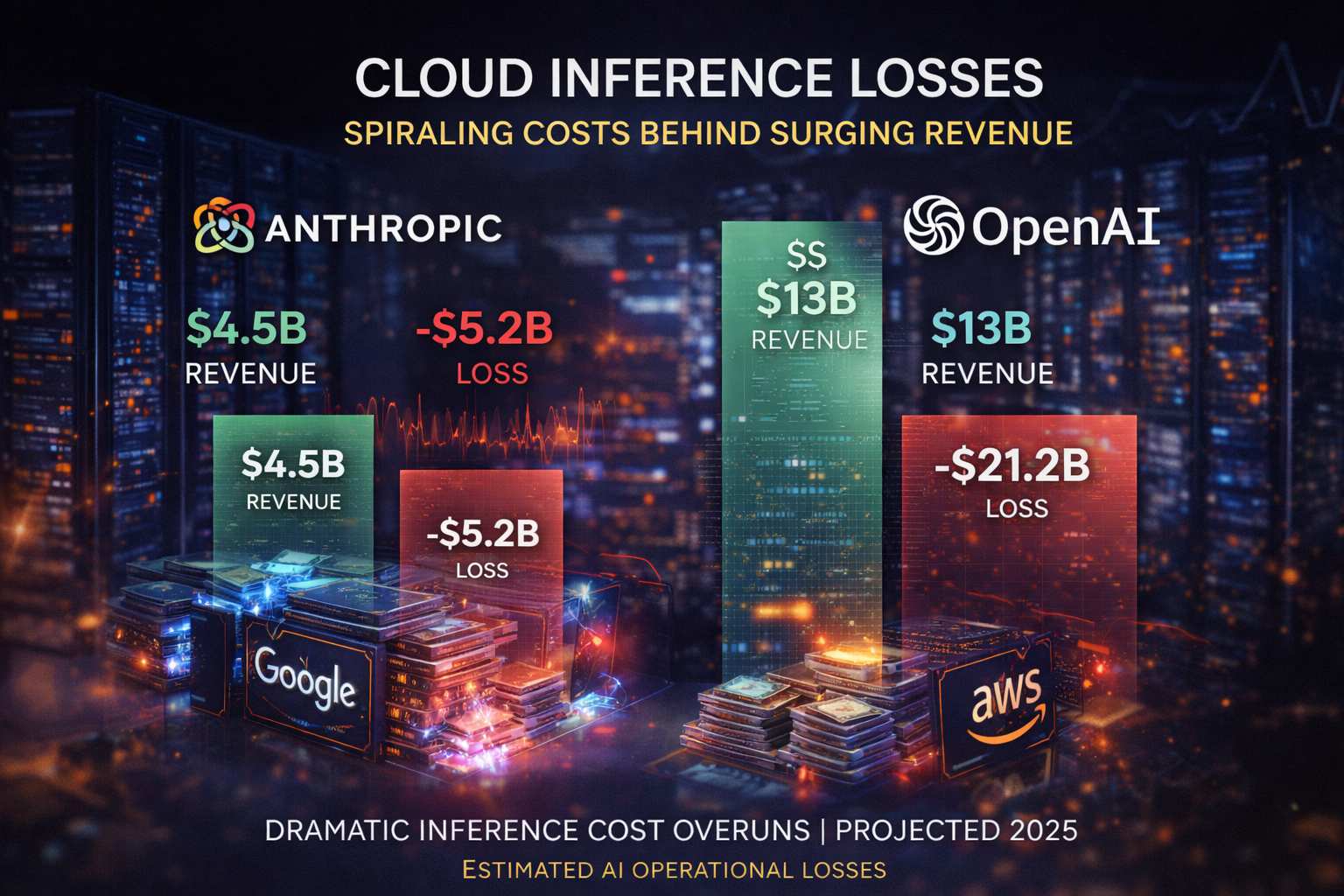

Tutto questo avviene mentre i ricavi continuano a crescere a ritmi vertiginosi. Anthropic prevede di raggiungere un fatturato di circa 4,5 miliardi di dollari nel 2025, un valore circa dodici volte superiore rispetto ai 381 milioni del 2024. OpenAI, su scala ancora maggiore, dovrebbe superare i 13 miliardi di dollari di ricavi. Numeri che, in un settore software tradizionale, sarebbero già sinonimo di successo consolidato.

Eppure, le perdite restano enormi. Anthropic ha stimato una perdita operativa di circa 5,2 miliardi di dollari nell’ultimo anno, mentre OpenAI avrebbe registrato una perdita intorno ai 21,2 miliardi di dollari. Questo paradosso – ricavi in forte crescita accompagnati da perdite altrettanto imponenti – mostra come il modello economico dell’AI generativa sia ancora in una fase di assestamento.

Gli analisti concordano sul fatto che queste aziende abbiano già raggiunto un volume di vendite tale da competere con i grandi player del software tradizionale. Tuttavia, l’onere strutturale dei data center e i costi di elaborazione rimangono un ostacolo significativo alla piena sostenibilità economica. In questo scenario, il controllo dell’hardware e l’efficienza dei costi emergono come le variabili decisive che determineranno chi riuscirà a trasformare la leadership tecnologica in profitti stabili.