Nel dibattito attuale sull’adozione dell’intelligenza artificiale nelle imprese e nelle professioni altamente specializzate, emerge con forza un paradosso significativo: anche sistemi di IA capaci di generare risposte accurate possono risultare pericolosamente incompleti. Questo concetto sottolinea come l’accuratezza — pur essendo un requisito fondamentale — non garantisca da sola il livello di affidabilità richiesto nei contesti ad alta criticità, come il settore legale o finanziario, dove risposte parziali o mancanti di elementi essenziali possono avere conseguenze gravi o fuorvianti.

Nel mondo dell’intelligenza artificiale generativa, l’accuratezza descrive la capacità di un modello di restituire informazioni corrette in termini fattuali o statistici. Tuttavia, la rilevanza di questa accuratezza varia drasticamente a seconda del dominio di applicazione. In ambiti regolamentati e complessi, come la consulenza giuridica, l’accuratezza deve accompagnarsi a criteri più sofisticati di verifica: non basta che un output sia corretto dal punto di vista semantico e rispecchi fedelmente i dati di addestramento, ma è imprescindibile che la risposta sia completa, autoritaria, riferita a fonti affidabili e priva di elementi ingannevoli o di riferimenti non validi. In altre parole, un modello può generare risposte linguisticamente brillanti che tuttavia non affrontano tutte le sfaccettature di una domanda articolata, oppure possono apparentemente citare giurisprudenza o riferimenti che non sono più applicabili o citabili in un contesto pratico.

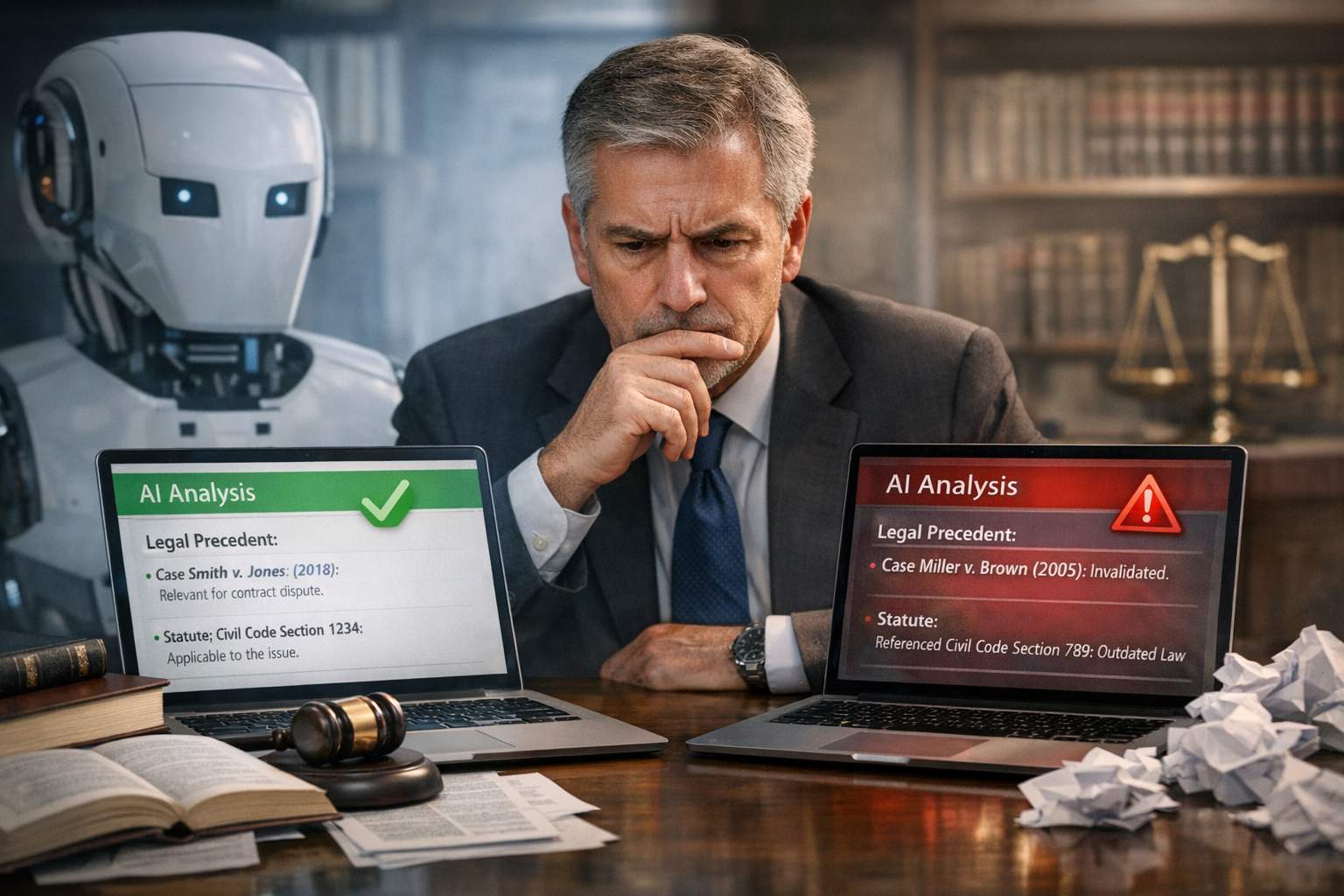

Un esperto del settore, responsabile dell’adozione dell’IA presso una grande azienda di servizi legali, ha evidenziato che nei casi d’uso professionale tradizionalmente la completezza delle risposte è un indicatore critico di affidabilità. Per esempio, quando un avvocato pone una domanda che tocca molteplici aspetti normativi o procedure specifiche, un’IA potrebbe correttamente rispondere a una parte delle sotto-questioni ma tralasciare elementi altrettanto cruciali. Il risultato è una risposta che, pur formalmente accurata, resta incompleta sotto il profilo della copertura di tutte le dimensioni rilevanti. In un ambiente legale, dove ogni parte di una risposta può avere implicazioni normative o strategiche reali per un caso, una lacuna di questo tipo non è solo una limitazione tecnica: può produrre rischi concreti per l’utente finale.

Questo problema di incompletezza si manifesta anche nelle citazioni, dove un modello può restituire riferimenti semantici alla materia richiesta, ma che poi provengono da decisioni giudiziarie annullate, non più applicabili o considerate non citabili dagli stessi professionisti esperti del dominio. In un contesto legale, la validità giuridica di una citazione è tutto: una citazione semanticamente coerente ma giuridicamente non valida non contribuisce affatto a risolvere la domanda dell’utente e può anzi risultare fuorviante.

Per superare i limiti di un approccio di IA basato esclusivamente sulla pertinenza semantica, alcune organizzazioni stanno sperimentando tecnologie di retrieval augmented generation (RAG) evolute, che integrano strutture dati più complesse come grafi di conoscenza, e agenti AI capaci di scomporre problemi complessi in sotto-richieste più specifiche. Questi sistemi non si limitano a cercare contenuti rilevanti in base al linguaggio naturale, ma attraversano connessioni concettuali e relazionali tra concetti formali, riferimenti normativi consolidati, e fonti autorevoli per garantire che ogni componente della risposta sia non solo pertinente, ma verificabile, citabile e rilevante secondo gli standard professionali. Inoltre, vengono adottati agenti progettati per analizzare in autonomia le proprie risposte, criticandole e affinando progressivamente gli output attraverso modelli di riflessione interna, così da ridurre la probabilità di omissioni critiche.

Queste soluzioni più avanzate non hanno come obiettivo quello di sostituire l’esperto umano, ma piuttosto quello di costruire un’interazione più solida tra capacità computazionale dell’IA e giudizio specialistico. Il futuro di questi sistemi è immaginato come un processo collaborativo in cui l’IA affianca il professionista, fornendo risposte che non solo siano accurate, ma che affrontino l’intera complessità della richiesta, integrando criteri di autorità, rilevanza normativa e completezza concettuale. Questo nuovo paradigma di utilizzo dell’IA punta a trasformare l’accuratezza da semplice misura di corrispondenza formale a componente di un giudizio olistico sulla fiducia e sull’utilità delle risposte generate.