L’adozione dell’intelligenza artificiale agentic, ovvero sistemi di IA capaci di agire in autonomia per raggiungere obiettivi complessi senza supervisione costante, rappresenta una delle frontiere più ambiziose della trasformazione digitale nelle imprese. Tuttavia, mentre i modelli di linguaggio e le architetture agentic continuano a evolversi rapidamente, emerge un vincolo critico legato ai dati che sta rallentando la diffusione di queste tecnologie nelle applicazioni mission-critical: il problema dei dati di “ultimo miglio”. Questo termine indica la difficoltà di prendere dati operativi grezzi — spesso disordinati, non strutturati o inconsistenti — e renderli immediatamente utilizzabili per l’inferenza e l’esecuzione autonoma degli agenti AI in ambienti di produzione reali. Secondo una recente analisi pubblicata da VentureBeat, questo problema strutturale non riguarda tanto i modelli di IA quanto la qualità, la preparazione e la governance dei dati che alimentano le applicazioni enterprise di IA agentic.

La radice del problema risiede nella natura stessa dei dati aziendali operativi. Le organizzazioni accumulano enormi volumi di informazioni provenienti da sistemi legacy, CRM, ERP, file non strutturati, API eterogenee e una moltitudine di fonti eterogenee che non seguono uno schema coerente. Strumenti tradizionali di ETL (Extract, Transform, Load), come dbt o Fivetran, sono stati concepiti per movimenti di dati tesi alla reportistica e all’analisi con schemi di dati stabili e prevedibili. Questi strumenti funzionano bene per consolidare dati in un data warehouse per cruscotti analitici, ma non riescono a soddisfare le esigenze di un sistema agentic che necessita di dati operativi puliti, coerenti, strutturati e pronti all’uso in tempo reale. La mancanza di tale qualità dati si traduce spesso in lunghi cicli di implementazione, frequenti interventi manuali e, non di rado, nell’abbandono di progetti di IA prima che raggiungano una fase di produzione.

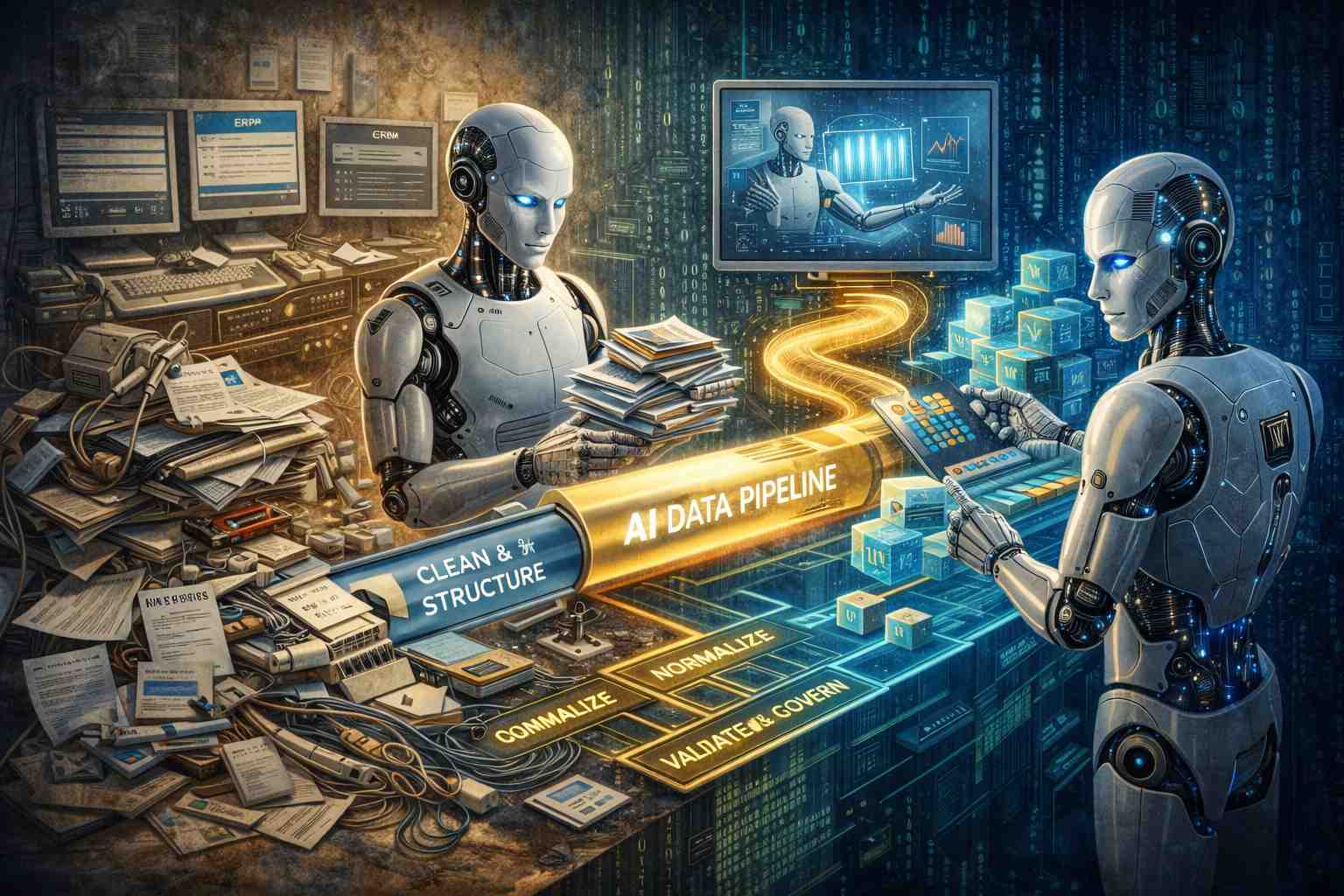

Per affrontare questo “ultimo miglio”, la società Empromptu propone un approccio denominato golden pipelines, che integra direttamente la normalizzazione, la validazione e la governance dei dati all’interno del flusso di lavoro dell’applicazione di IA. Invece di considerare la preparazione dei dati come un’attività tecnica separata e successiva, come avviene con gli strumenti ETL tradizionali, i golden pipelines fungono da strato automatico che si interpone tra i dati operativi grezzi e le funzionalità di IA. Questo strato esegue l’ingestione da qualsiasi fonte, ispeziona e pulisce i dati, definisce schemi, arricchisce le informazioni dove necessario e applica controlli di conformità, tracciabilità e protezione dei dati, assicurando che i dataset siano consistenti e pronti per l’inferenza. Il feedback continuo tra la preparazione dei dati e la performance dell’IA — ovvero la verifica automatica che una trasformazione dati non peggiori l’accuratezza delle previsioni o delle decisioni del sistema — distingue i golden pipelines dagli approcci di data engineering tradizionali.

La distinzione fondamentale proposta da Empromptu è tra reporting integrity e inference integrity. Gli strumenti come dbt e Fivetran sono ottimizzati per la prima, ossia la coerenza dei dati destinati alla reportistica e alle analisi storiche. I golden pipelines, al contrario, sono progettati per l’integrità dei dati nel contesto dell’inferenza dell’IA, dove la stabilità degli schemi e la prevedibilità non sono garantite e dove la trasformazione dei dati deve avvenire in modo adattivo e continuo. Per un agente AI, l’inferenza non si limita a rispondere a domande con testi rilevanti: deve essere alimentata da dati operativi accurati e coerenti in tempo reale, senza la latenza di settimane o mesi tipica dei cicli di data engineering tradizionali.

L’importanza di affrontare il problema dei dati di ultimo miglio è evidenziata anche da numerose analisi e previsioni di settore che collegano il fallimento di molti progetti di IA proprio alla qualità dei dati e alla mancanza di governance solida. Alcuni studi sottolineano come una parte significativa dei progetti agentic non raggiunga risultati di valore in produzione, non per limiti nei modelli stessi, ma per l’incapacità di integrare dati eterogenei e disomogenei in sistemi coerenti e affidabili. Questo conferma che la tecnologia di IA non è l’unico fattore critico di successo, ma lo è la capacità di gestire e preparare i dati adeguatamente.

Un esempio concreto di applicazione dei golden pipelines è nel contesto di piattaforme di gestione eventi complesse, dove i dati relativi a sponsor, biglietti, tavoli e piani di sale devono essere costantemente aggiornati e coerenti per alimentare funzionalità di IA in tempo reale. Aziende che in precedenza si affidavano a script manuali o processi di trasformazione intensivi ora possono ridurre drasticamente i tempi di preparazione e minimizzare gli errori, grazie all’automazione integrata nella pipeline dati. In altri casi, l’adozione di questi sistemi consente di andare oltre le semplici analisi, permettendo la generazione automatica di piani di layout e altri servizi avanzati basati su IA che richiedono dati puliti e completi, disponibili senza intervento umano.

A livello architetturale, l’adozione di golden pipelines comporta una visione diversa delle infrastrutture dati enterprise, specialmente per quei casi d’uso dove l’agente IA deve prendere decisioni autonome basate su dati che cambiano in tempo reale. Invece di mantenere pipeline separate e silos di strumenti di data engineering e sviluppo IA, si propone una convergenza in cui la preparazione dei dati è parte integrante dell’applicazione stessa. Questo avvicina le pratiche di data engineering e di sviluppo IA, riducendo le barriere tra la prototipazione e la produzione e permettendo alle organizzazioni di superare ciò che spesso è il principale ostacolo alla scalabilità agile dei progetti agentic.