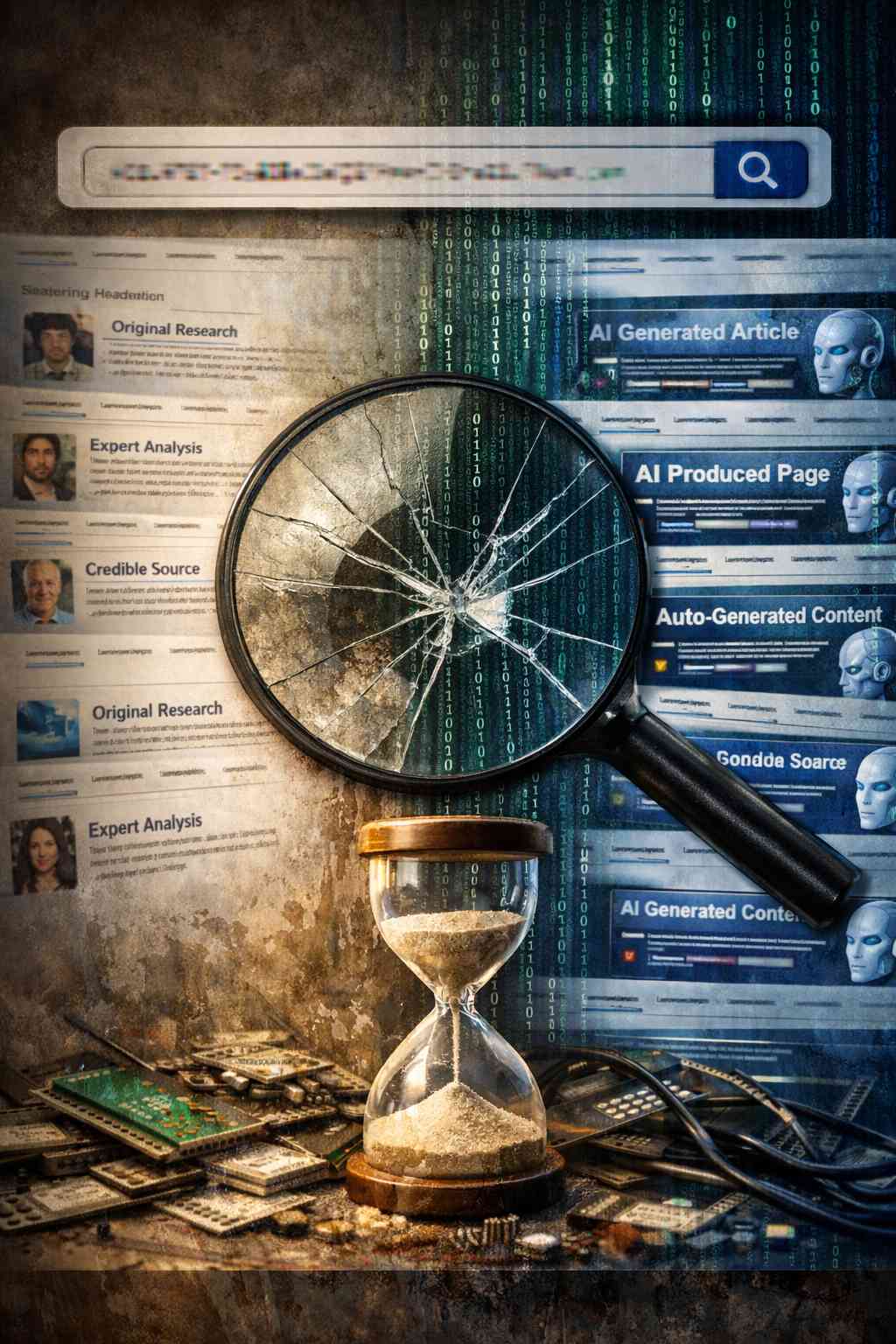

Negli ultimi anni la diffusione di contenuti generati dall’intelligenza artificiale si è intensificata in modo esponenziale, coinvolgendo non solo la produzione di testi, immagini e video, ma anche l’intero ecosistema informativo del web. Un recente lavoro di ricerca evidenzia un rischio strutturale che potrebbe emergere da questa crescita incontrollata: il cosiddetto Retrieval Collapse, un fenomeno che mette in pericolo la qualità e l’affidabilità dei risultati di ricerca e dei sistemi che ne dipendono.

La nozione di Retrieval Collapse nasce dalla constatazione che, alla base dei moderni motori di ricerca e dei sistemi di recupero informativo (in inglese retrieval systems), vi è un costante equilibrio tra qualità delle sorgenti, diversità dei contenuti e accuratezza delle risposte. In un contesto ideale, i sistemi di ricerca attingono da una vasta gamma di contenuti prodotti da fonti umane affidabili, con un’ampia diversità di prospettive e di dati originali. Tuttavia, con l’espansione massiccia di pagine web interamente generate da modelli di intelligenza artificiale, si rischia che queste sorgenti sintetiche comincino a dominare i risultati delle query.

L’analisi condotta dai ricercatori mostra che quando i contenuti generati dall’AI iniziano a sovrapporsi a quelli creati da esseri umani, non solo aumentano in quantità, ma possono anche assumere una posizione dominante nelle pagine dei risultati dei motori di ricerca. In questa fase di dominanza, le pagine sintetiche — spesso ottimizzate per i meccanismi SEO — si insinuano nei meccanismi di ranking, spingendo verso l’alto nella classifica contenuti che possono apparire semanticamente coerenti ma che, dietro una forma accattivante, non hanno un solido fondamento derivante da fonti umane originali. Il fenomeno non è immediatamente evidente nei tradizionali indicatori di performance delle ricerche, come la precisione delle risposte, perché i contenuti sintetici possono risultare plausibili e strutturalmente corretti pur essendo privi di reale valore informativo.

Una volta che il motore di ricerca o i sistemi di retrieval-augmented generation (RAG) iniziano a fare affidamento su queste fonti sintetiche come base dei propri processi di elaborazione, la qualità complessiva dell’informazione può degradarsi progressivamente. Questo degrado non è sempre immediatamente visibile all’utente finale: le risposte possono continuare ad apparire coerenti e plausibili, ma la loro base informativa si allontana sempre più dalla conoscenza originale prodotta da esseri umani, generando una sorta di “eco digitale” in cui l’AI finisce per alimentarsi dei propri stessi output.

Il rischio di Retrieval Collapse diventa ancora più insidioso se si considera l’effetto cumulativo nel tempo. Una volta che i contenuti generati dall’AI saturano i risultati di ricerca, i sistemi che dipendono da questi risultati per l’addestramento o per il supporto alle risposte — incluso l’addestramento di nuovi modelli — potrebbero iniziare a utilizzare dati sempre più radicati in contenuti sintetici piuttosto che in dati umani originari. Questo processo di autoalimentazione ricorda, in parte, il fenomeno noto come model collapse, in cui i sistemi di AI addestrati su dati generati da altri modelli perdono progressivamente varietà e contatto con la realtà originale dei dati. Sebbene model collapse sia un fenomeno a livello di prestazioni dei modelli, Retrieval Collapse rappresenta una minaccia a livello di ecosistema informativo, con potenziali implicazioni per la fiducia pubblica e per la qualità delle decisioni basate su tali informazioni.

La ricerca propone che per mitigare tale rischio sia necessario ripensare le strategie di ranking e di filtraggio delle sorgenti nei motori di ricerca e nei sistemi di prova delle risposte automatizzate. Una possibile direzione di lavoro è l’adozione di criteri di ranking difensivi che valutino non solo la rilevanza apparente dei contenuti, ma anche la qualità, la provenienza e l’autenticità delle fonti. Metodi più sofisticati di filtraggio alla fase di ingestione dei dati, prima che questi entrino nei sistemi di retrieval, potrebbero aiutare a preservare la diversità delle fonti umane rispetto a quelle sintetiche.