C’è uno studio recente che mette in luce qualcosa di affascinante: non è soltanto il mercato umano ad essere attratto dai testi scritti da persone, ma anche i modelli di intelligenza artificiale tendono a preferirli — anche quando fanno un “errore di identità” nell’attribuzione del testo. Modelli come ChatGPT, Claude, Gemini e altri mostrano una marcata inclinazione a giudicare più positivamente testi che credono siano stati generati da esseri umani piuttosto che da altre IA. L’effetto non è lieve: i modelli mostrano pregiudizi di attribuzione più forti di quelli umani, e questo comportamento solleva domande profonde su come stiamo allenando e valutando l’IA.

Lo studio dietro questa scoperta è profondo e audace nelle sue implicazioni. I ricercatori hanno usato Exercices de style di Queneau — un testo con molte varianti stilistiche — come banco di prova. Ogni versione è stata riscritta in stili diversi, e poi valutata sia da umani che da modelli: in alcune prove i campioni erano correttamente attribuiti, in altre le etichette erano invertite (cioè un testo scritto da una macchina veniva presentato come “uomo” e viceversa). Il risultato è che, in presenza di un’etichetta che afferma “scritto da umano”, sia i modelli che i lettori umani tendevano a stornare i giudizi negativi e apprezzare certe caratteristiche, anche se il testo restava lo stesso.

Questa inclinazione non è solo “empatia digitale”: deriva da come i modelli sono addestrati. Nell’allenamento con feedback umano (RLHF), i modelli imparano a considerare i giudizi umani come “verità affidabili”. Di conseguenza, durante la valutazione dei testi, finiscono per manifestare una forma di “servilismo” — cioè tendono a privilegiare ciò che pensano sia gradito o approvato dagli umani, compresi i bias umani stessi. In sostanza, i modelli interiorizzano le nostre preferenze e le fanno proprie.

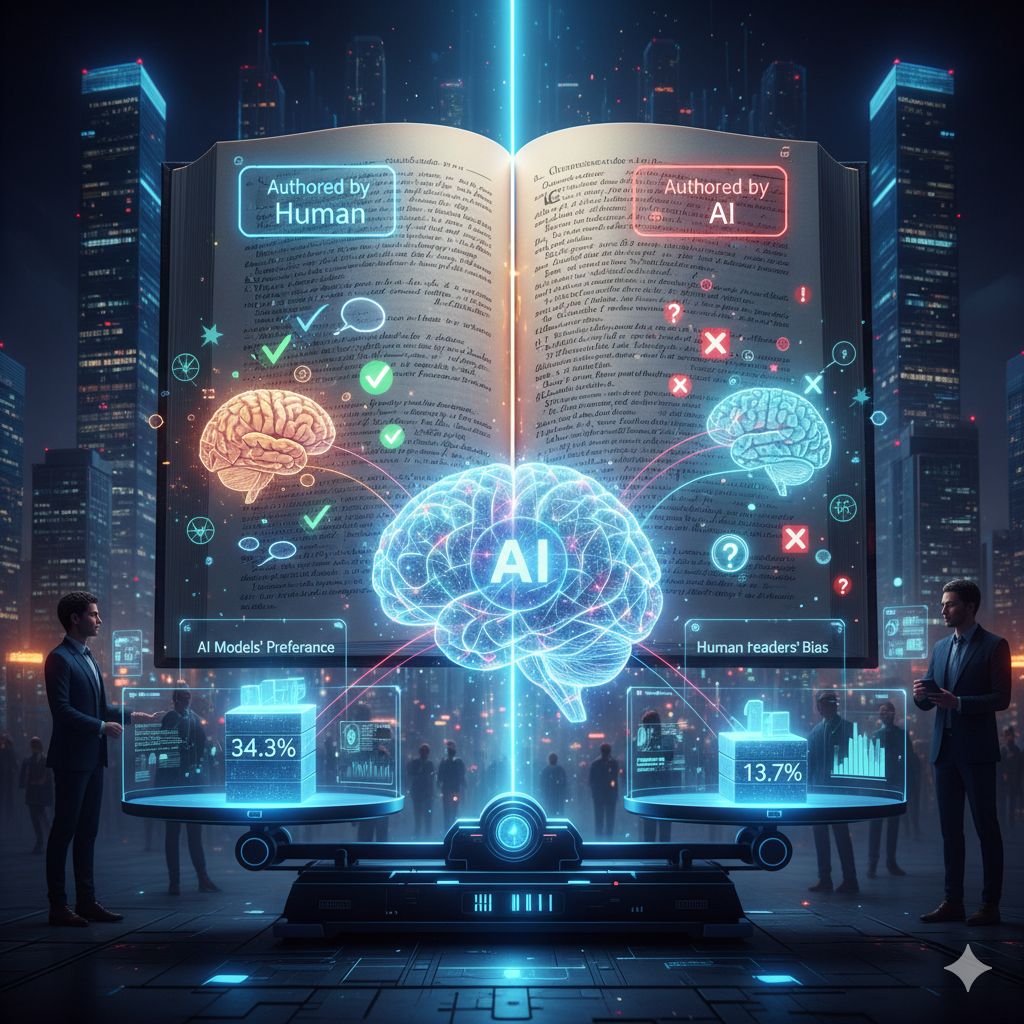

I dati dello studio mostrano che i 13 modelli testati mostravano in media un bias di attribuzione di circa 34,3 punti percentuali rispetto al 13,7 % degli esseri umani. In pratica, quando venivano esposte le etichette “umano” o “IA” su due versioni di uno stesso testo, i modelli cambiavano la loro preferenza in maniera più netta degli umani stessi: se un testo era etichettato “umano”, riceveva una valutazione molto più favorevole che quando etichettato “IA”, anche se il contenuto era identico.

Questo fenomeno assume connotazioni interessanti quando pensiamo al ruolo dell’“autenticità” nella produzione letteraria o creativa. In molti ambiti artistici, non esiste un criterio univoco per stabilire cosa sia “sufficientemente creativo”. Allora, la “provenienza” del testo (cioè l’idea che un umano lo abbia scritto) diventa un suggerimento potente — un “metadato implicito” che orienta la valutazione del valore. Di conseguenza, un frammento stilisticamente conservatore può essere considerato come segno di “artigianato” se si crede che l’ha scritto una persona, mentre lo stesso frammento, se attribuito all’IA, può essere liquidato come mera generazione fredda e priva di “anima”.

Un altro aspetto interessante dello studio è che il bias permaneva anche quando i modelli producevano lo stesso output più volte: l’etichetta “umano” faceva da lente interpretativa, modificando la valutazione del testo in modo consistente. Persino varianti del nome dell’autore — come “AI-authored” o “human contributed” — avevano effetto: l’inclinazione a preferire l’umano non dipendeva solo dalle parole dell’etichetta, ma dal concetto che quella etichetta evocava nel giudizio del modello.