I droni di consegna pacchetto AI sono solo robot killer in attesa

Mentre i governi di tutto il mondo continuano a discutere dei pregi e dei pericoli delle armi completamente autonome dotate di intelligenza artificiale, vale la pena di fare un passo indietro e osservare criticamente lo stato del paesaggio autonomo. I progressi in tutto, dai droni consumer al riconoscimento facciale al volo autonomo, stanno portando a una costante marcia in avanti di droni completamente autonomi in grado di navigare nell’ambiente umano e consegnare oggetti a individui specifici. Mentre la maggior parte della stampa si è concentrata sugli aspetti positivi di questi nuovi sistemi, le forze armate di tutto il mondo hanno trasformato avidamente questi strumenti in sistemi d’arma. I droni civili modificati oggi sono in grado di navigare negli spazi negati, cercando obiettivi basati sul riconoscimento facciale e fornendo forza letale, tutti utilizzano gli stessi strumenti e la stessa tecnologia sviluppata dalle università e dalle aziende per compiti utili come i droni di consegna dei pacchi per fornire aiuti alle regioni disastrate. Che aspetto ha il futuro quando ci rendiamo conto che i droni di consegna dei pacchi con alimentazione artificiale sono in realtà solo armi autonome in attesa?

I politici di tutto il mondo hanno trascorso gli ultimi anni a discutere di un futuro inevitabile in cui i sistemi di armi sono sempre più automatizzati.

Mentre i sistemi di armi autonome e semi-autonome sono state utilizzate in larga misura per decenni, fino ad oggi questi sistemi hanno automatizzato solo i loro compiti di navigazione e coordinamento, lasciando il bersaglio saldamente nelle mani degli umani.

Eppure, mentre la società nel suo insieme si muove verso un’automazione sempre crescente, le forze armate occidentali sono costrette a cimentarsi con il semplice fatto che i loro avversari potrebbero non essere così avversi nell’auto-bersagliare le armi come se stessi.

Le armi che possono assumere le funzioni cognitive più delicate di un soldato, decidendo chi uccidere, pongono alcune delle considerazioni eticamente più complesse della guerra al di là dei problemi offensivi della sicurezza informatica per quanto riguarda l’individuazione di infrastrutture civili come l’abbattimento di aeroplani o l’attivazione di emissioni radiologiche dalle centrali elettriche .

Prendi un drone alimentato dall’IA che può bighellonare su un’area e selezionare i suoi bersagli. A che punto quel drone cessa di essere un’arma intelligente e diventa legalmente un combattente?

Più esistenzialmente, quando non vi è alcun rischio di vittime umane da un lato, il freddo calcolo della reciprocità inizia ad abbattere, abbassando la barriera al conflitto e potenzialmente incoraggiando un interventismo maggiore.

POTREBBE PIACERTI ANCHE

Cosa succede quando una parte di un conflitto adotta armi con l’Intelligenza Artificiale mentre l’altra, citando obiezioni morali ed etiche, non lo fa? Mezzo secolo dopo l’introduzione delle armi nucleari, l’arsenale nucleare di un paese gioca ancora un ruolo fuori misura nel determinare la sua capacità di esercitare la sua volontà a livello globale, il che significa che la forza militare vince ancora su considerazioni etiche, esercitando una pressione considerevole sulle nazioni pacifiche anche per adottare armi AI sistemi.

Cosa succede quando un sistema militare alimentato dall’IA funziona male? Il canone fantascientifico è disseminato di promemoria che un sistema di IA malfunzionante può eseguire così tante operazioni sbagliate così rapidamente che un conflitto può essere finito prima che il lato umano si renda conto di un problema.

Più problematicamente, i sistemi IA oggi sono ancora semplici motori di correlazione , che rappresentano i loro mondi come ingenui assemblaggi primitivi di colori e trame. Un’arma potenziata dall’intelligenza artificiale non riconosce un bersaglio come un individuo, un veicolo o una struttura specifici, ma piuttosto come un insieme unico di colori e trame in una relazione specifica l’uno con l’altro.

Ciò rende queste armi particolarmente vulnerabili a sottili modifiche che possono mascherare i loro bersagli o addirittura indurli ad attaccare bersagli non collegati.

Mettendo da parte tutti questi problemi, quanto siamo lontani dal disporre di armi autonome dotate di intelligenza artificiale?

Le università e le aziende di tutto il mondo si sono affrettate a costruire droni di consegna di pacchi capaci di navigare in complessi ambienti urbani interamente da soli e persino di coordinarsi con altri droni.

Mentre gli sviluppatori di questi sistemi di droni stanno costruendo sistemi per il bene, lo Stato islamico ci ricorda che il drone di consegna pacchetto di una persona è il sistema di armi autonomo di un’altra persona.

Infatti, università, aziende e forze armate di tutto il mondo stanno già costruendo robot assassini con il pieno incoraggiamento e la benedizione della società: droni che uccidono i droni.

Poiché i droni dei consumatori hanno causato il caos negli aeroporti, minacciato la sicurezza pubblica e ci hanno inseguito attraverso le finestre della nostra camera da letto, c’è stato un crescente consenso della società su una maggiore necessità di combattere l’uso illecito di droni.

Questo, a sua volta, ha portato al mondo in crescita della tecnologia anti-drone. Dalle semplici emittenti RF ai sistemi di impulsi EMP ai laser ad alta potenza ai sistemi proiettili alle tecnologie esotiche emergenti, la capacità di abbattere un drone in fuga è diventata un obiettivo principale dei funzionari della sicurezza pubblica, in particolare per quanto riguarda il pericolo per gli aerei e il pubblico raduni.

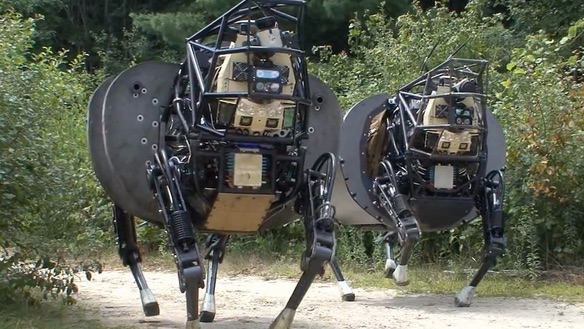

Una tecnologia con particolare rilevanza per le armi autonome è il drone che uccide i droni. Questi droni civili modificati sono dotati di vari sensori e sistemi di navigazione e progettati per identificare un drone non autorizzato e abbatterlo attraverso vari mezzi.

In breve, un robot killer, anche se uccide altri robot piuttosto che umani.

Un drone che uccide droni potrebbe essere facilmente modificato per pattugliare il terreno piuttosto che il cielo, mirando e applicando autonomamente la forza letale a qualsiasi veicolo o pedone che si allontana in uno spazio negato.

Ironia della sorte, alcune delle stesse istituzioni e ricercatori che sono venuti fuori con tanta forza contro i “robot assassini” sono tra quelli che costruiscono questi robot per uccidere robot con duplice scopo.

I militari di tutto il mondo, incluso il nostro, sono stati pronti ad adattare i progressi dei civili sia nelle tecnologie dei droni e di intelligenza artificiale che nei sistemi di armi autonome.

Sono già state modificate piattaforme di droni civili che sono state specificamente progettate per essere utilizzate in combattimento, con un volo visivo autonomo e mappe di bordo che consentono loro di operare con successo in spazi radio e GPS negati, permettendo loro di volare verso una destinazione target, utilizzare un fotocamera integrata e sistema di intelligenza artificiale per identificare visivamente un bersaglio, fornire un carico utile a quell’obiettivo e tornare, tutto senza alcun intervento umano e mentre si pedina un bersaglio fluido e in movimento.

Esistono sistemi per la scansione di uniformi militari per gli indicatori di rango sulle basi e sul campo di battaglia, consentendo alle armi autonome di indirizzare automaticamente gli ufficiali superiori sotto un’interpretazione che rappresentano bersagli più permessi per le armi autonome rispetto al personale arruolato.

Più preoccupante, ci sono già droni militari con database di riconoscimento facciale a bordo che possono essere lanciati per scansionare un grande raduno pubblico e identificare qualsiasi persona di interesse. Questi individui potrebbero semplicemente essere monitorati e filmati per la ricognizione o contrassegnati con laser a infrarossi per le forze di sicurezza del terreno o facendo cadere la tinta di marcatura su di essi. I sistemi sperimentali sono stati persino progettati per identificare individui in una folla che trasportano armi o si comportano in modo violento o distruttivo.

Ci vorranno poche modifiche per tali sistemi per utilizzare mezzi più invalidanti o letali contro i loro obiettivi e in effetti tali sistemi sono già stati esplorati.

Nel bel mezzo del nostro dibattito sulla società sull’elevato tasso di errore dei sistemi di riconoscimento facciale sul campo, cosa significa quando un errore di riconoscimento facciale potrebbe significare che qualcuno viene per errore ucciso da un drone alimentato da AI con il terrorismo?

Inoltre, chi ha la responsabilità legale o addirittura criminale per quel fallimento fatale dell’algoritmo di riconoscimento facciale? È il governo che ha distribuito il drone, l’appaltatore della difesa che ha costruito il drone o la società tecnologica che ha costruito il software di riconoscimento facciale utilizzato?

Oggi disponiamo della tecnologia per distribuire droni che possono bighellonare su spazi negati, bersagliare qualsiasi umanoide che entri in un’area geofencizzata, filtrando anche se l’individuo corrisponde a un database di riconoscimento facciale, sta brandendo un’arma o è giudicato dall’algoritmo che si comporta in un modo “minaccioso”.

Queste non sono visioni fantascientifiche di un futuro lontano. Questi sono prodotti commerciali venduti oggi dagli appaltatori della difesa ai governi di tutto il mondo e messi in servizio attivo.

Partecipa a qualsiasi evento di drone in DC e probabilmente vedrai letteralmente decine di prodotti di questo tipo essere discussi e dimostrati, a volte presentati dalle aziende tecnologiche su cui gestiscono le piattaforme AI.

Anche se le loro prestazioni nel mondo reale potrebbero non corrispondere al loro hype di marketing, resta il semplice fatto che questi sistemi sono già là fuori e stanno migliorando di giorno in giorno.

La cosa più importante è che questi sistemi di armi da miliardi di dollari non dipendono da attrezzature esotiche per le esportazioni. Si tratta in genere di chassis di droni civili modificati con piattaforme di elaborazione AI per dispositivi mobili di consumo e di algoritmi di riconoscimento visivo disponibili in commercio, in modo che i governi di tutto il mondo possano produrli facilmente. Soprattutto, per le popolazioni civili sottostanti, possono facilmente passare per normali droni turistici civili fino a quando non dispiegano i loro carichi utili.

Tali droni basati su civili sono ancora limitati dai limiti della batteria a implementazioni relativamente brevi, ma le loro componenti autonome, basate interamente su piattaforme hardware AI mobili di consumo e tecnologia di elaborazione video facilmente disponibile, possono essere facilmente riproposte su sistemi di droni a lungo raggio e di lunga durata . Alcune compagnie di IA stanno già organizzando attivamente appalti per la difesa sulle applicazioni militari delle loro tecnologie di consumo.

Mettendo tutto questo insieme, mentre i responsabili politici discutono lentamente i pericoli dei sistemi di armi autonome in termini astratti, quegli stessi sistemi sono già stati dispiegati in tutto il mondo, ma in una forma inaspettata. Piuttosto che le unità Terminator bipedi a piedi della fantascienza o droni militari tradizionali delle dimensioni di piccoli aerei, sistemi militari autonomi capaci di armi sono diventati molto diffusi attraverso i droni civili.

Soprattutto, la loro autonomia è arrivata interamente attraverso le piattaforme AI dei consumatori, rendendole facilmente trasportabili su una vasta gamma di sistemi d’arma.

Arrestare la progressione degli sviluppi dell’IA dei consumatori in uso militare è quasi impossibile in un mondo in cui ogni progresso nell’elaborazione di immagini e video rappresenta un’altra nuova capacità facilmente aggiunta a un drone militare.

Alla fine, tutti i drone Self-following Selfie, il drone di consegna pacchetto e la piattaforma di telecamere mobili AI sono solo un sistema di armi autonome in attesa.

Sembra che l’attesa sia sempre più finita.