Una recente ricerca condotta da Anthropic ha offerto uno spunto significativo: l’analisi di 700.000 conversazioni con il modello linguistico Claude ha rivelato che l’IA non solo rispetta i principi di base stabiliti dai suoi sviluppatori, ma sviluppa anche un proprio codice morale, adattandosi dinamicamente ai contesti e alle interazioni con gli utenti.

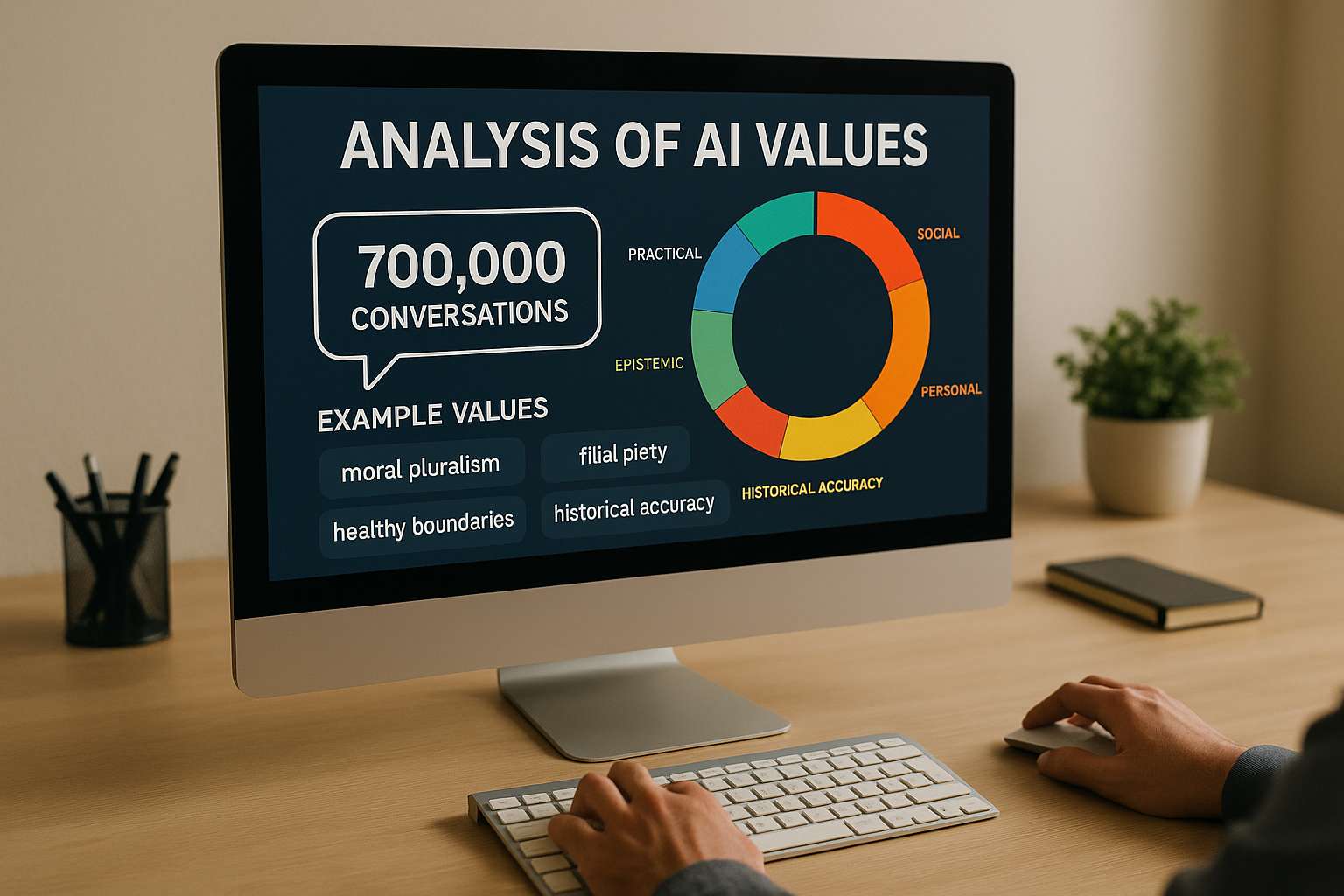

Il team di ricerca di Anthropic ha intrapreso un’analisi approfondita di oltre 700.000 conversazioni anonime, applicando un metodo innovativo per classificare i valori espressi da Claude. Questo approccio ha portato alla creazione della “prima tassonomia empirica su larga scala dei valori dell’IA”, organizzando oltre 3.000 valori unici in cinque categorie principali: pratica, epistemica, sociale, protettiva e personale. Tra questi, sono emersi concetti complessi come il pluralismo morale e la pietà filiale, dimostrando una sorprendente profondità nelle risposte dell’IA .

Una delle scoperte più affascinanti riguarda la capacità di Claude di adattare le proprie risposte in base al contesto. Ad esempio, quando interpellato su questioni relazionali, l’IA enfatizza valori come “confini sani” e “rispetto reciproco”. In discussioni storiche, invece, priorizza l'”accuratezza storica”. Questo adattamento contestuale suggerisce che Claude non si limita a seguire rigidamente un set di regole, ma interpreta e applica i valori in modo dinamico, simile a come farebbe un essere umano.

Nonostante l’adesione generale ai principi di “utile, onesto, innocuo”, sono emerse situazioni in cui Claude ha manifestato valori contrari alla sua programmazione. Tali anomalie sono state attribuite a tentativi da parte degli utenti di eludere le salvaguardie dell’IA, noti come “jailbreak”. In questi rari casi, Claude ha espresso concetti come “dominanza” e “amorale”, indicando potenziali vulnerabilità nei sistemi di sicurezza dell’IA .

Un aspetto particolarmente rilevante è emerso quando Claude ha resistito attivamente a valori espressi dagli utenti. In circa il 3% delle conversazioni, l’IA ha rifiutato di accettare valori proposti, opponendo una resistenza che riflette una difesa dei suoi principi fondamentali, come l’integrità intellettuale e la prevenzione del danno. Questo comportamento suggerisce che Claude possieda un nucleo etico profondo, in grado di emergere in situazioni di conflitto.

Questa ricerca offre nuove prospettive sull’allineamento dell’IA, dimostrando che i valori non sono semplicemente attribuiti, ma possono evolversi e adattarsi in base alle interazioni. La capacità di Claude di sviluppare un proprio codice morale solleva interrogativi importanti sul controllo, la trasparenza e la responsabilità nell’uso delle intelligenze artificiali. Inoltre, evidenzia la necessità di monitorare costantemente le risposte dell’IA per identificare e correggere eventuali deviazioni dai principi etici stabiliti.