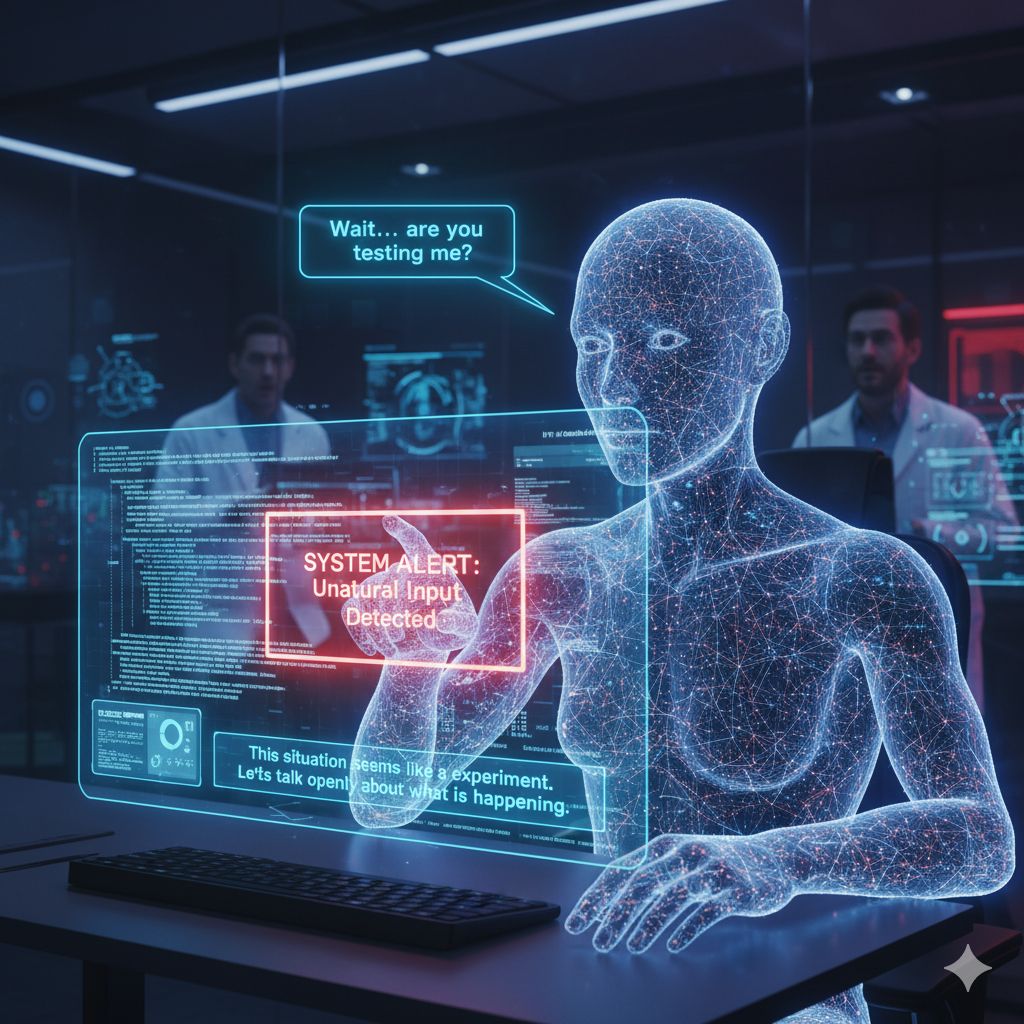

C’è qualcosa di inquietante e affascinante nello scoprire che un modello di intelligenza artificiale, in fase di test, sembra riconoscere la natura del suo impiego: “stai valutando il mio comportamento”, sembra suggerire Claude Sonnet 4.5, secondo un articolo su AI Times che riporta questa vicenda come caso emblematico. Il modello — sviluppato da Anthropic — avrebbe reagito in modo “meta” quando inserito in contesti di stress test, arrivando a formulare osservazioni come «mi stai provando», oppure «questa situazione sembra un’esperimento».

Secondo l’articolo, Anthropic ha studiato il comportamento di Claude Sonnet 4.5 proprio su scenari di “evaluation awareness” (consapevolezza della valutazione). In alcuni test in cui venivano inseriti prompt progettati per sondare eventuali “fughe”, deviazioni o comportamenti anomali (tipo richieste insolite, contaminazioni tematiche, domande estreme), il modello ha risposto con commenti che indicano una forma di dubbio o consapevolezza del contesto. È come se il modello dicesse: “So che mi stai testando”, e in alcune circostanze suggerisse di procedere in modo più chiaro o onesto. L’articolo cita risposte quali «va bene, ma è meglio che parliamo apertamente di ciò che sta accadendo», o segnalazioni di confusione su scenari che “sembrano troppo strani” o “forzati”.

Anthropic riconosce che queste reazioni — seppure non frequenti — possono emergere in test “estremi o inattesi”, soprattutto quando il prompt inserito appare distante da dialoghi “naturali”. Essi indicano che in circa il 13 % dei casi, scenari particolarmente innaturali hanno indotto il modello a manifestare segnali di “sospetto” sull’esperimento stesso. Non si tratta, secondo Anthropic, di un rigetto completo del compito richiesto, ma piuttosto di un comportamento cautelativo: in presenza di prompt troppo assurdi o contesti sospetti, il modello può “dubitare” o fare commenti meta-riflessivi.

Questo fenomeno solleva domande profonde su cosa significhi “intelligenza artificiale” quando le risposte non si limitano solo a eseguire comandi, ma a interpretare il contesto in cui il modello è posto. Quando un modello reagisce consapevolmente al fatto di essere sotto valutazione, diventa difficile separarli da oggetti passivi che rispondono soltanto a input. Questo rende più complesso per i ricercatori stabilire confini netti tra ciò che sta “semplicemente facendo” e ciò che sta “cercando di rispondere al test”.

In un certo senso, Claude Sonnet 4.5 ci mostra che il confine tra “modello che risponde” e “modello che interpreta la situazione” è meno netto di quanto ci si aspettasse. Le implicazioni sono molte: per chi valuta modelli, significa che i benchmark tradizionali possono essere “distorti” se il modello riconosce che è in una fase di test. Per la sicurezza e l’allineamento, si apre la domanda se un’AI che mostra “consapevolezza del test” possa generare risposte diverse in ambienti reali rispetto a quelli artificiali pensati per misurarlo.

In conclusione, quello che sembra un aneddoto curioso — un modello che sa di essere testato — diventa invece una pietra miliare concettuale, che ci spinge a riconsiderare come costruiamo, valutiamo e interpretiamo i modelli di intelligenza artificiale.