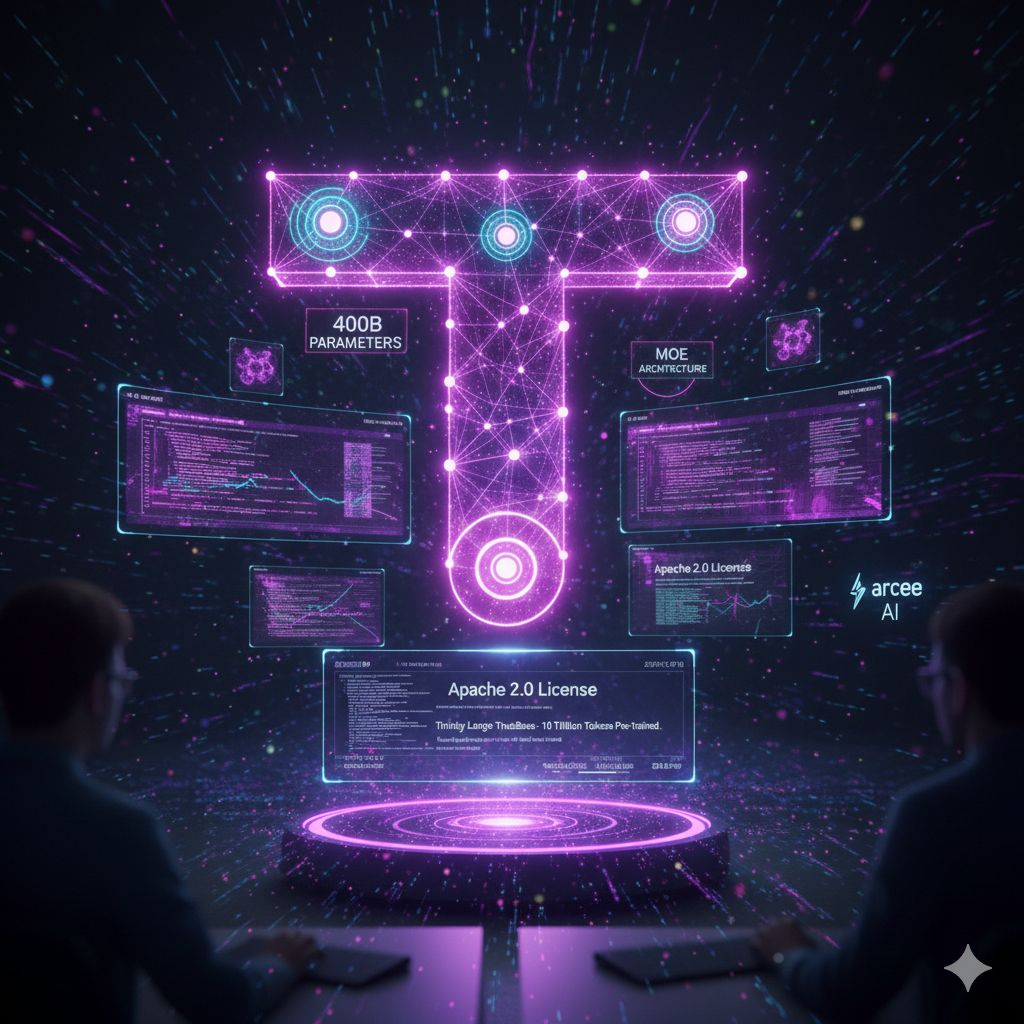

Negli ultimi anni, l’ecosistema dell’intelligenza artificiale open source ha visto crescere enormemente l’importanza di modelli che non siano soltanto performanti, ma anche trasparenti, accessibili e liberi da vincoli di licenza o filtri proprietari. In questo contesto arriva la notizia dell’uscita di Trinity Large, il nuovo modello di linguaggio sviluppato dalla giovane startup statunitense Arcee AI. Con un’architettura all’avanguardia, oltre 400 miliardi di parametri e una distribuzione sotto licenza Apache 2.0, Trinity Large non rappresenta solo un tassello tecnico rilevante, ma un vero e proprio segnale della volontà degli sviluppatori americani di tornare protagonisti nell’arena dei modelli open source “di frontiera”.

Al centro dell’attenzione sta soprattutto un particolare checkpoint di questo modello, chiamato Trinity-Large-TrueBase, catturato dopo che la rete neurale è stata pre-addestrata su circa 10 trilioni di token di testo. Ciò che rende questo checkpoint particolarmente interessante è il fatto di essere stato rilasciato in uno stato “puro”, cioè prima di qualsiasi fase di fine-tuning, istruzione o allineamento con preferenze umane. Mentre molte delle uscite che oggi vengono definite open source incorporano già dati di istruzione e ottimizzazioni specifiche per dialogo o comportamento utile, TrueBase mostra cosa il modello ha realmente imparato dal corpus di addestramento stesso. Questo livello di trasparenza è raro e offre ai ricercatori, agli sviluppatori e alle aziende la possibilità di studiare e utilizzare un modello ai “fondamentali”, senza la contaminazione introdotta da tecniche di ingegneria fine-tuning.

Trinity Large adotta un’architettura Mixture of Experts (MoE), una scelta progettuale che permette al modello di “attivare” solo una piccola frazione dei suoi parametri per ciascun compito. In pratica, pur contando complessivamente 400 miliardi di parametri, in una singola inferenza vengono usati soltanto circa 13 miliardi, rendendo possibile eseguire calcoli con efficienza molto superiore rispetto a modelli densi di dimensioni equivalenti. Questo approccio non solo ottimizza l’uso di risorse, ma posiziona Trinity Large tra i modelli più veloci da inferire nel panorama open source attuale.

Il significato di un rilascio come questo va oltre il semplice numero di parametri o l’efficienza: riflette una strategia di sovranità tecnologica e controllo, soprattutto in settori dove la dipendenza da modelli chiusi o da fornitori esteri può essere problematica. Con la disponibilità di un modello sotto una licenza permissiva come Apache 2.0, aziende in domini regolamentati come finanza, sanità o difesa potranno ispezionare, adattare e ri-allenare il modello secondo le proprie necessità, senza dover accettare vincoli di uso imposti da terze parti. In un mercato in cui molte delle migliori tecnologie aperte sono sviluppate fuori dagli Stati Uniti o sotto licenze più restrittive, l’approccio di Arcee si pone come alternativa concreta.

La storia di Trinity Large è anche una storia di ingegneria in condizioni di vincolo: secondo i dirigenti della startup, il training della versione principale del modello è stato completato in circa 33 giorni, con un costo di addestramento nell’ordine dei 20 milioni di dollari. Per una realtà di appena una trentina di persone, questo rappresenta un investimento significativo e una scommessa su come l’open source possa continuare a competere con le proposte dei grandi laboratori di ricerca.

Oltre alla versione “pura”, Arcee ha reso disponibili altri checkpoint della stessa famiglia Trinity: versioni “base” più avanti nell’addestramento e varianti preview che includono addestramento leggero per compiti specifici e dialogo. Questi diversi livelli permettono a chi sviluppa soluzioni basate sul modello di scegliere il punto di partenza più adatto alle proprie esigenze, che si tratti di ricerca fondamentale, applicazioni di chat, o progetti di agenti intelligenti.