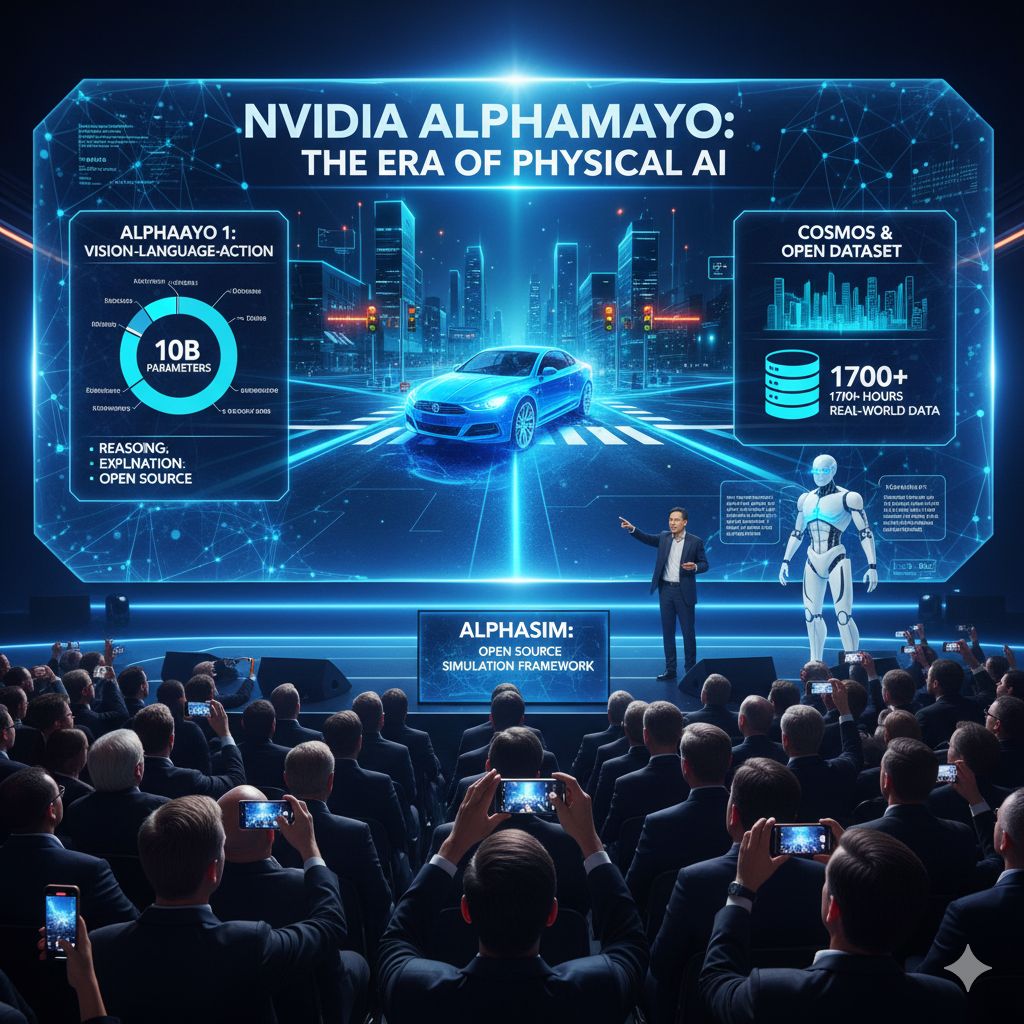

Al CES 2026 di Las Vegas, NVIDIA ha tracciato uno spartiacque concettuale e tecnologico annunciando l’inizio ufficiale dell’era dell’intelligenza artificiale fisica. Non si tratta di un semplice aggiornamento delle tecnologie per la guida autonoma, ma di un cambio di paradigma che punta a trasformare veicoli e robot in sistemi capaci di comprendere, ragionare e spiegare le proprie azioni nel mondo reale. Il fulcro di questa visione è AlphaMayo, una nuova linea di prodotti open source pensata per portare l’AI oltre il riconoscimento di schemi e il controllo reattivo, verso una vera capacità di giudizio.

AlphaMayo nasce come piattaforma aperta per la guida autonoma e la robotica, progettata per consentire inferenze affidabili in ambienti fisici complessi e imprevedibili. Il progetto comprende modelli di intelligenza artificiale open source, strumenti di simulazione avanzati e set di dati dedicati all’addestramento, con l’obiettivo di aiutare veicoli e robot a gestire situazioni che vanno ben oltre i casi standard presenti nei dataset tradizionali. NVIDIA ha voluto posizionare AlphaMayo non come un prodotto chiuso, ma come un ecosistema condiviso, capace di accelerare l’innovazione di tutto il settore.

Il cuore della piattaforma è AlphaMayo 1, che rappresenta la messa a disposizione commerciale di AlphaMayo-R1, un modello di tipo visione-linguaggio-azione da 10 miliardi di parametri, presentato per la prima volta lo scorso anno. Questo modello è stato progettato per avvicinare il comportamento dei sistemi autonomi a quello umano: non si limita a reagire ai segnali dei sensori, ma interpreta il contesto, ragiona sulle alternative possibili e prende decisioni motivate. In altre parole, AlphaMayo 1 non guida soltanto, ma “pensa” alla guida.

Come ha spiegato Ali Kani, AlphaMayo 1 affronta i problemi scomponendoli in fasi, valutando tutte le opzioni disponibili e selezionando il percorso più sicuro. Questo approccio consente al sistema di prendere decisioni razionali anche in assenza di esperienze dirette, affrontando scenari che non compaiono nei dati di addestramento tradizionali, come incroci complessi con semafori guasti o situazioni di traffico atipiche. È un passaggio cruciale, perché sposta l’AI autonoma dalla semplice imitazione statistica a una forma di ragionamento generalizzabile.

Un elemento distintivo di AlphaMayo è la sua capacità di spiegazione. Come ha sottolineato Jensen Huang, il sistema non si limita a ricevere input dai sensori e a controllare sterzo, frenata e accelerazione, ma è anche in grado di spiegare quali azioni intraprenderà, perché ha preso determinate decisioni e quale traiettoria di guida ne deriverà. Questa trasparenza è fondamentale non solo per la fiducia degli utenti, ma anche per la sicurezza, la certificazione e l’adozione normativa dei sistemi di guida autonoma.

Coerentemente con la filosofia open, il codice di base di AlphaMayo 1 è stato rilasciato come open source su Hugging Face. Gli sviluppatori possono utilizzare questo modello come base per affinare versioni più piccole, veloci e leggere, oppure per costruire sistemi di guida più semplici e specializzati. Il modello può anche essere impiegato come strumento ausiliario, ad esempio per l’etichettatura automatica dei dati visivi o per la creazione di sistemi di verifica in grado di valutare la razionalità delle decisioni prese da un veicolo autonomo.

Un altro pilastro dell’ecosistema AlphaMayo è l’integrazione con Cosmos, la piattaforma NVIDIA per la simulazione e la generazione di ambienti fisici virtuali. Grazie a Cosmos, AlphaMayo può essere addestrato e testato utilizzando sia dati di guida reali sia dati sintetici, ampliando enormemente la varietà di scenari disponibili. Cosmos consente di ricreare virtualmente ambienti fisici complessi, prevedere situazioni future e valutare le azioni più appropriate, riducendo i rischi e i costi associati ai test nel mondo reale.

In parallelo al lancio della piattaforma, NVIDIA ha rilasciato anche un dataset aperto con oltre 1.700 ore di dati di guida raccolti in una vasta gamma di luoghi e condizioni. Il valore di questo dataset risiede soprattutto nella presenza di scenari rari e complessi, difficili da incontrare nella guida quotidiana, ma cruciali per l’addestramento di sistemi realmente robusti. Anche questi dati sono disponibili su Hugging Face, rafforzando l’idea di un’infrastruttura aperta e condivisa.

Per completare il quadro, NVIDIA ha presentato AlphaSim, un framework di simulazione open source disponibile su GitHub, progettato per la verifica dei sistemi di guida autonoma. AlphaSim riproduce in modo realistico sensori, condizioni del traffico e caratteristiche stradali, consentendo test su larga scala in ambienti controllati e sicuri. Questo strumento è fondamentale per validare il comportamento di modelli complessi come AlphaMayo prima della loro applicazione nel mondo reale.

Nel suo insieme, AlphaMayo rappresenta la dimostrazione concreta che l’intelligenza artificiale per la guida autonoma sta superando la fase del semplice pattern matching. L’AI non si limita più a riconoscere segnali o a reagire a stimoli, ma entra in una fase di comprensione, inferenza ed esplicazione delle decisioni. NVIDIA definisce questo passaggio come l’ingresso nell’era dell’intelligenza artificiale fisica, in cui robot e veicoli sono in grado di interpretare le incertezze del mondo reale e rispondere in modo autonomo e motivato.

Come ha affermato Jensen Huang, “siamo arrivati al momento ChatGPT per l’intelligenza artificiale fisica”. Con AlphaMayo, NVIDIA punta a fornire alle auto a guida autonoma e ai robot la capacità di comprendere il mondo, prendere decisioni sicure anche in situazioni rare e spiegare le ragioni di quelle decisioni. È una visione ambiziosa, che potrebbe ridefinire non solo la tecnologia della guida autonoma, ma il modo stesso in cui l’intelligenza artificiale interagisce con la realtà fisica che ci circonda.