Confluent ha presentato una nuova piattaforma pensata per colmare uno dei divari più ostinati dei sistemi di intelligenza artificiale: la mancanza di contesto aggiornato e affidabile mentre i modelli ragionano e agiscono. L’annuncio arriva in concomitanza con Current 2025, l’evento di New Orleans del 29–30 ottobre, dove l’azienda ha inquadrato la propria ambizione: far fluire, in tempo reale, dati puliti e governati direttamente dentro agenti e applicazioni AI, così che possano prendere decisioni “nel momento” invece che su fotografie di ieri.

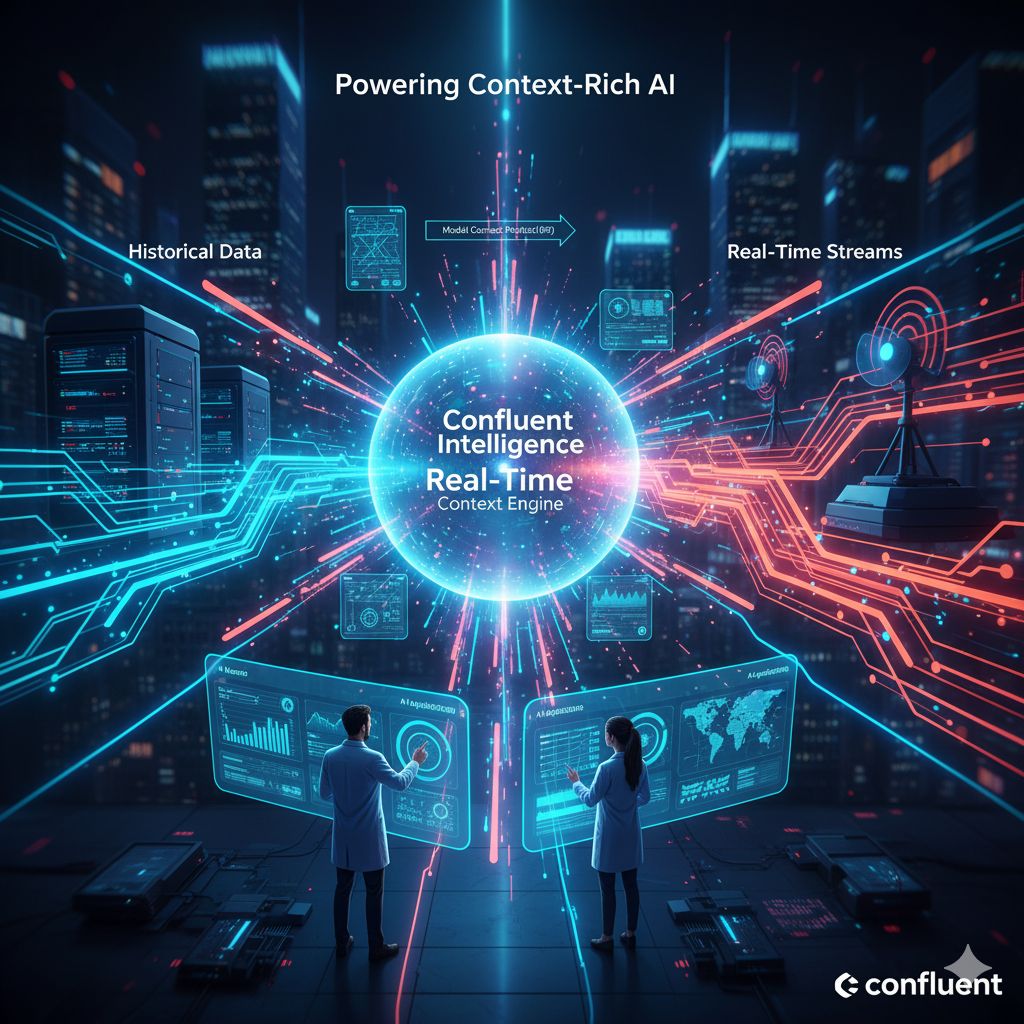

Il cuore dell’iniziativa è Confluent Intelligence, una piattaforma unificata in cloud che promette di portare l’AI oltre i prototipi, fino alla produzione, mantenendo coerenza tra dati storici e stream in arrivo. L’idea è semplice da raccontare ma complessa da realizzare: elaborare continuamente eventi da sistemi aziendali eterogenei, arricchirli con regole e controlli, e consegnare al modello solo ciò che serve, quando serve, con le garanzie di sicurezza e osservabilità che ci si attende in impresa. Confluent descrive Confluent Intelligence come “la via più rapida” per costruire AI ricche di contesto e realmente real-time, con uno stack completamente gestito.

Dentro questo disegno spicca un componente nuovo, il Real-Time Context Engine: un servizio gestito che estrae, valuta e serve contesto strutturato “vivo” agli agenti AI e alle app, sfruttando il Model Context Protocol (MCP) per consegnarlo in modo standard e immediatamente utilizzabile. In pratica, anziché chiedere ai modelli di “ricordare tutto” o di scandagliare basi di conoscenza statiche, l’AI riceve finestre di realtà pertinenti, aggiornate al secondo, pronte per essere citate nel prompt o consultate come strumenti. È un approccio che riduce allucinazioni e deriva semantica perché privilegia dati tracciabili, governati e osservabili end-to-end.

La scommessa di Confluent è coerente con la sua storia: nata dai creatori di Apache Kafka, l’azienda ha costruito la propria identità sullo streaming “sempre acceso”. Oggi quell’eredità si traduce in un tessuto di connettori, policy e pipeline che non si limita a muovere messaggi ma struttura, pulisce e arricchisce i dati prima di metterli a disposizione dell’AI. La piattaforma, dicono, astrae gran parte della complessità di Kafka e Flink, così che gli sviluppatori possano concentrarsi sull’esperienza dell’agente o del copilota invece che sui dettagli dell’infrastruttura. Non è solo un vantaggio operativo: è un cambio di priorità che sposta il valore dal “trasporto” al “significato” del dato.

Una novità collegata è l’evoluzione degli “Streaming Agents” su Confluent Cloud: agenti che osservano segnali in arrivo, ragionano su regole e pattern, e agiscono invocando strumenti o aggiornando sistemi a valle. Qui il Real-Time Context Engine funge da alimentazione premium: fornisce all’agente la porzione di mondo che conta, al millisecondo, con tracciabilità e controlli. Per il team AI significa poter costruire cicli OODA (observe–orient–decide–act) realmente continui, evitando che i modelli si “stacchino” dalla realtà tra un batch e l’altro. È in questo spazio—tra governance del dato e autonomia dell’agente—che Confluent vuole marcare la differenza rispetto a soluzioni che si fermano al semplice retrieval.

La promessa più concreta, per chi lavora in impresa, è la riduzione del tempo che intercorre tra un evento e una decisione utile. Pensiamo a un assistente finanziario che ricalcola l’esposizione al rischio appena cambia un tasso, a un copilota per il customer care che risponde sapendo cosa il cliente ha fatto trenta secondi fa in app, o a un agente operativo che coordina micro-azioni lungo una supply chain congestionata. In tutti questi casi, la qualità dell’AI dipende dall’aderenza del contesto alla realtà: se i dati sono vecchi, l’AI è cieca; se sono sporchi, è confusa; se arrivano tardi, è irrilevante. L’architettura presentata mira a dare all’AI occhi, memoria a breve termine affidabile, e un canale sicuro per aggiornarsi continuamente.

Va anche detto che il tema del “contesto in tempo reale” non è solo tecnico ma organizzativo: implica definire chi può vedere cosa, con quali retention, come si spiegano le decisioni prese da agenti data-driven e come si monitorano derive e drift. Per questo Confluent insiste su sicurezza, governance e osservabilità come parti integranti dell’offerta, non accessori. La combinazione di servizio gestito, protocolli standard come MCP e controlli a livello di piattaforma è la leva con cui l’azienda prova a facilitare il passaggio da pilota a produzione, mantenendo compliance e auditabilità.

Sul piano competitivo, l’annuncio posiziona Confluent in un’area in cui i confini tra data platform e AI platform si sovrappongono sempre più. Non è un caso che partner dell’ecosistema sottolineino l’impatto che un “context fabric” gestito può avere sugli agenti generativi e sulle app operative che devono agire rapidamente su dati convergenti da più sistemi. È un terreno affollato, ma l’ancoraggio allo streaming e alle pratiche di governance enterprise può diventare un differenziale, specie per chi deve scalare casi d’uso mission-critical senza costruire infrastrutture su misura.

Il messaggio che arriva da New Orleans è chiaro: l’AI che conta davvero non è quella più “grande”, ma quella più “presente”. Confluent prova a mettere in mano ai team un modo pratico per rendere presenti i loro modelli, fornendo contesto fresco, pertinente e affidabile in modo continuo. Se manterrà le promesse di astrazione della complessità e di controllo operativo, il Real-Time Context Engine e, più in generale, Confluent Intelligence, potrebbero trasformare molti proof-of-concept in sistemi che vivono e reagiscono al ritmo del business.