Per quasi un lustro, l’Intelligenza Artificiale Generativa è stata inestricabilmente legata a un’unica parola: Transformer. Questo modello, introdotto con il concetto rivoluzionario di Self-Attention, ha sbloccato capacità di apprendimento e generazione senza precedenti, alimentando l’ascesa dei Modelli Linguistici di Grande Dimensione (LLM). Per anni, la convinzione è stata semplice: per ottenere risultati migliori, basta addestrare Transformer più grandi con più dati, su cluster sempre più estesi di GPU. Sebbene questa strategia abbia portato a scoperte epocali, ha ormai raggiunto il suo limite fisico ed economico, scontrandosi con quello che gli esperti chiamano il “Muro GPU”. Questo impasse non è solo una questione di potenza di calcolo bruta, ma una barriera fondamentale di banda di memoria e di sostenibilità economica.

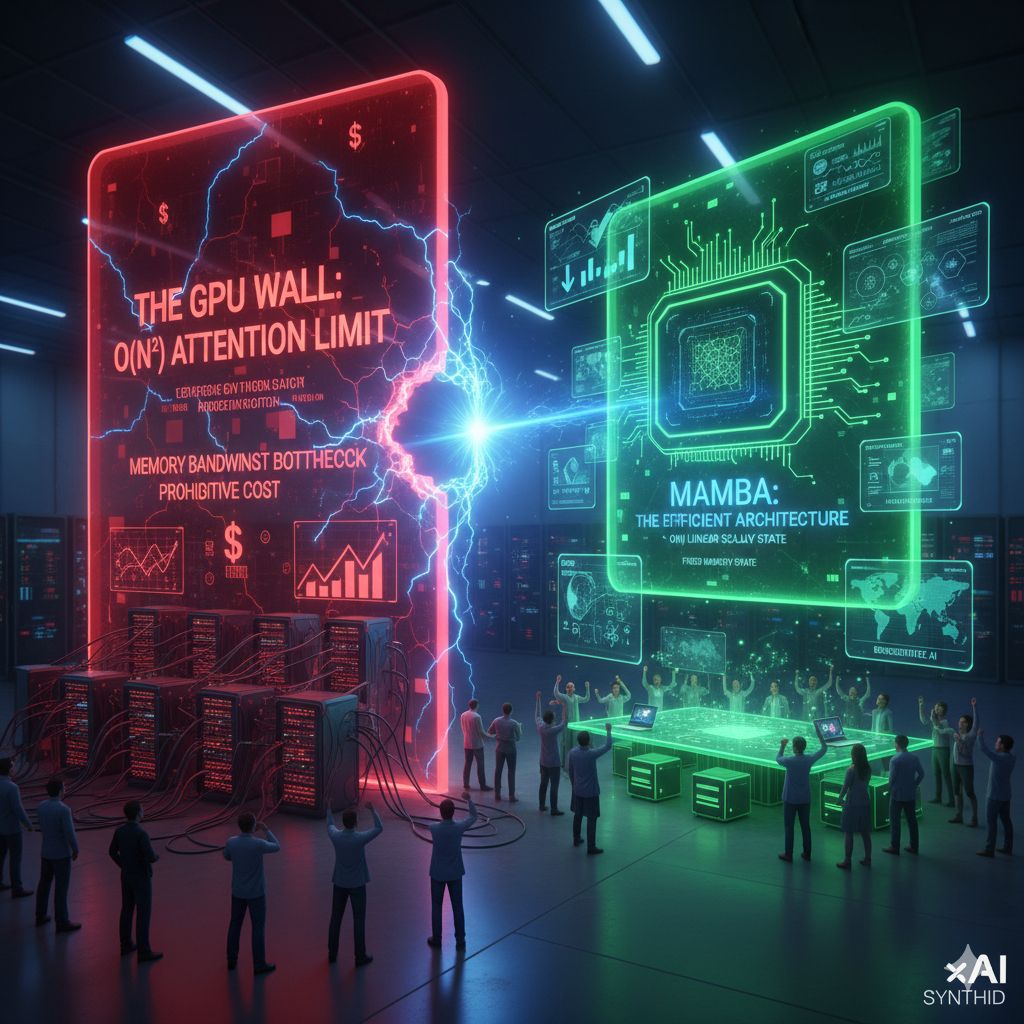

L’inefficienza del Transformer risiede proprio nel suo meccanismo fondante: l’attenzione. L’attenzione auto-referenziale richiede che ogni token (parola o pezzo di informazione) nella sequenza d’ingresso si relazioni e si confronti con ogni altro token precedentemente visto. Matematicamente, questo si traduce in una complessità quadratica, $O(N^2)$, rispetto alla lunghezza $N$ della sequenza. Finché le sequenze sono brevi, l’inefficienza è trascurabile. Ma non appena la conversazione, il documento o il contesto di un modello si allunga, il costo computazionale e, soprattutto, quello in termini di memoria, esplode in modo esponenziale. Questo crea il vero “Muro GPU”: non stiamo finendo i chip, ma stiamo esaurendo la banda di memoria necessaria per alimentare l’attenzione. In particolare, i Transformer richiedono un’enorme cache di chiavi e valori (key/value cache) per “ricordare” il contesto, e questa cache si gonfia a dismisura, consumando quantità massive di VRAM (memoria della GPU) solo per elaborare il contesto esteso. Questo rende l’inferenza di modelli molto grandi o su sequenze molto lunghe proibitivamente costosa e accessibile solo ai giganti tecnologici con disponibilità illimitate di hardware.

Mentre gli occhi del mondo sono puntati sulla corsa ai modelli da trilioni di parametri, nei laboratori di ricerca si sta svolgendo una rivoluzione invisibile. Una nuova ondata di architetture post-Transformer sta emergendo con l’obiettivo specifico di frantumare il limite $O(N^2)$ e di offrire efficienza senza sacrificare la potenza predittiva.

Il modello che è emerso come l’emblema di questa nuova era è Mamba. Mamba, che abbandona l’attenzione, si basa sui Selective State-Space Models (SSMs). Il principio che guida Mamba è rivoluzionario: esso gestisce le sequenze in tempo lineare, $O(N)$, e soprattutto, lo fa mantenendo uno stato nascosto di dimensione fissa. Ciò risolve radicalmente il problema del memory bloat associato alla cache del Transformer.

Mamba agisce come un filtro intelligente. Selezionando dinamicamente i parametri delle sue equazioni dello spazio di stato dall’input corrente, il modello impara a dare importanza solo alle informazioni critiche e a ignorare il “rumore” o le parole poco significative, senza la necessità di costruire la matrice di attenzione gigante. Questo gli permette di scorrere sequenze lunghissime fino a cinque volte più velocemente rispetto ai Transformer ottimizzati, pur mantenendo una precisione comparabile.

Le implicazioni di questa rivoluzione guidata dall’efficienza vanno ben oltre i benchmark di velocità. Il Muro GPU ha funzionato storicamente come un guardiano, limitando la possibilità di costruire e gestire modelli all’avanguardia solo alle aziende dotate di datacenter e cluster GPU da miliardi di dollari. La rottura di questo muro, attraverso architetture intrinsecamente più efficienti come Mamba e i modelli ibridi (che combinano Transformer e SSM), promette di democratizzare l’AI.

Questa nuova efficienza apre la porta a due scenari futuri cruciali:AI Locale e Privata. I modelli ad alta efficienza possono essere eseguiti interamente su hardware di consumo, come laptop o smartphone. Ciò consentirebbe la rinascita di agenti AI locali e privati che elaborano dati sensibili dell’utente senza mai inviare un pacchetto al cloud, risolvendo così i problemi di latenza e privacy.

Sistemi Agentici Avanzati: L’efficienza è la chiave per sbloccare i veri sistemi AI agentici, che devono operare in background per ore o giorni per completare compiti complessi. Senza la capacità di eseguire l’inferenza in modo economico e veloce su lunghi flussi di contesto, gli AI agent rimarrebbero limitati a brevi interazioni.

Se il Transformer ha definito l’ultima era dell’AI focalizzata sulla scala, l’era post-Transformer sarà definita dall’efficienza. La rivoluzione è già in corso: la comunità di ricerca non sta più aspettando i progressi hardware delle GPU, ma sta attivamente riprogettando l’architettura dei modelli per renderli intrinsecamente più intelligenti ed economici, promettendo di distribuire la potenza dell’Intelligenza Artificiale ben oltre i confini dei grandi datacenter.