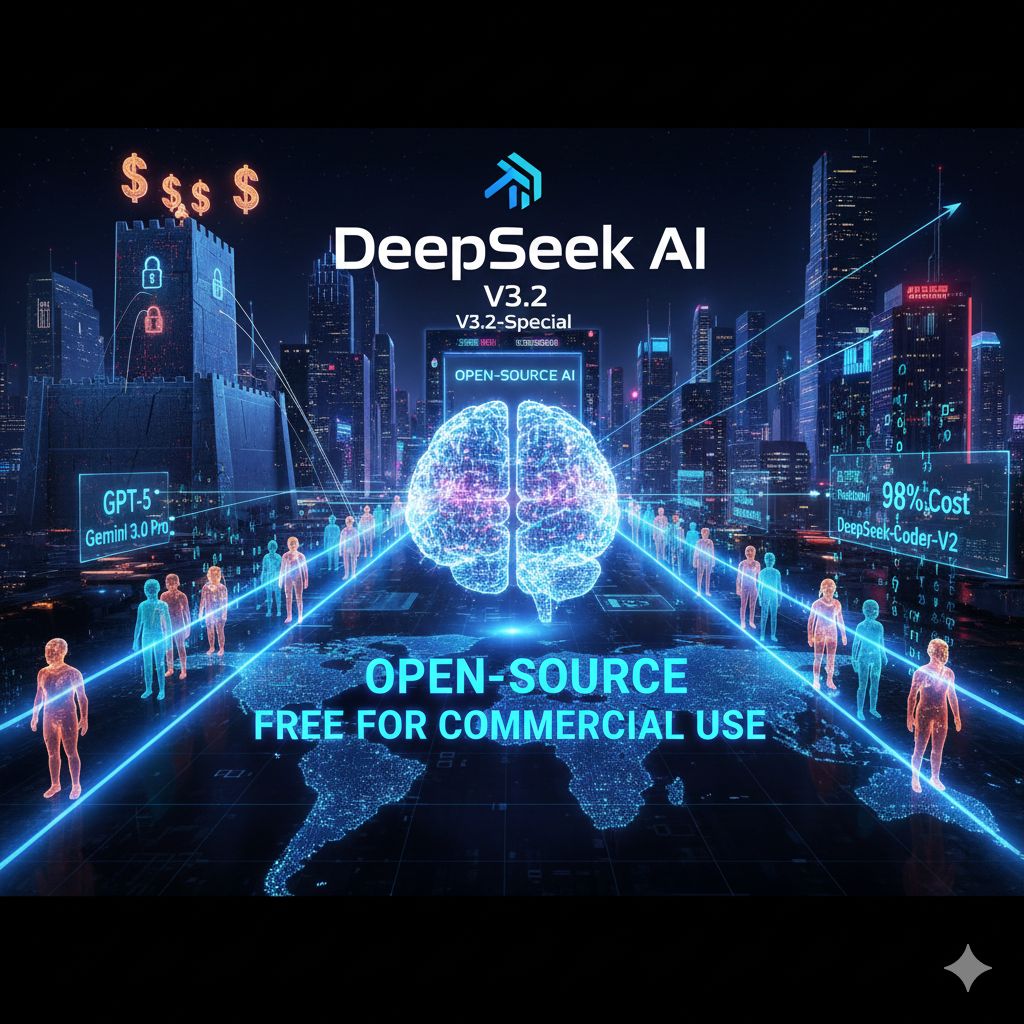

L’azienda cinese DeepSeek ha immesso sul mercato una nuova famiglia di modelli di linguaggio di grandi dimensioni (LLM), tra cui le versioni DeepSeek-V3.2 e DeepSeek-V3.2-Special, che secondo le affermazioni del team sviluppatore e le prime valutazioni, non solo raggiungono ma in certi ambiti superano le prestazioni dei modelli più avanzati e custoditi gelosamente come GPT-5 di OpenAI e Gemini 3.0 Pro di Google. Questo rilascio non è soltanto un traguardo tecnico, ma un vero e proprio terremoto strategico per l’intero settore.

Storicamente, la corsa verso l’Intelligenza Artificiale di frontiera è stata dominata da poche grandi aziende americane, le quali hanno blindato i loro modelli più potenti dietro costosi muri di accesso tramite API. DeepSeek, invece, sta ribaltando questo paradigma dimostrando che l’innovazione di punta può, e deve, essere democratizzata. Il dettaglio che rende questa notizia tanto dirompente è che questi nuovi sistemi non sono solo incredibilmente potenti, ma sono anche stati resi disponibili come risorse open-source e completamente gratuite per l’utilizzo commerciale.

Il segreto dietro la capacità di DeepSeek di competere con giganti che dispongono di risorse finanziarie quasi illimitate risiede in una raffinata architettura Mixture-of-Experts (MoE). Questa tecnica permette di addestrare modelli con un numero impressionante di parametri totali – alcuni modelli DeepSeek contano oltre 200 miliardi di parametri – mantenendo allo stesso tempo un numero relativamente basso di parametri attivi per ogni singola operazione di inferenza. Il risultato è un’efficienza senza precedenti.

L’impatto di questa ottimizzazione si misura in due modi cruciali. In primo luogo, riduce drasticamente i costi di inferenza, l’aspetto più oneroso per chi utilizza l’IA su larga scala. I rapporti indicano che l’utilizzo di questi modelli DeepSeek può essere fino al 98% più economico rispetto a GPT-5, trasformando compiti che in precedenza costavano decine di dollari in operazioni da pochi centesimi. In secondo luogo, pur essendo economicamente vantaggiosi, i modelli non sacrificano la potenza: essi eccellono in particolare nel ragionamento matematico e nella programmazione, aree dove la precisione logica è fondamentale. Versioni specializzate, come DeepSeek-Coder-V2, sono state addestrate con un corpus di codice massivo e sono in grado di gestire centinaia di linguaggi di programmazione, superando in molti benchmark dedicati i migliori modelli proprietari.

Il successo di DeepSeek assume una rilevanza ancora maggiore se inquadrato nel contesto della rivalità tecnologica tra Stati Uniti e Cina. Nonostante le severe restrizioni all’esportazione di chip avanzati Nvidia imposte dagli USA, le aziende cinesi continuano a dimostrare una straordinaria capacità di innovazione, utilizzando architetture software ingegnose, come l’MoE, per aggirare i colli di bottiglia hardware e raggiungere la frontiera dell’AI.

Rilasciando modelli di questa caratura con una licenza open-source, DeepSeek sta non solo sfidando i suoi omologhi americani sul piano delle prestazioni, ma sta anche accelerando la diffusione di capacità AI di alto livello a livello globale. Questo atto di democratizzazione pone una pressione notevole su OpenAI e Google affinché riconsiderino le loro strategie di prezzo e di accesso. L’obiettivo è chiaro: rendere l’intelligenza artificiale di frontiera non un lusso per pochi, ma uno strumento universale per ricercatori, sviluppatori e aziende di ogni dimensione, stimolando così un ecosistema tecnologico più collaborativo e inclusivo.

L’immissione sul mercato dei nuovi modelli DeepSeek, quindi, non è solo una vittoria per l’ingegneria software, ma segna forse il momento in cui l’IA open-source ha definitivamente raggiunto la maturità necessaria per competere ad armi pari, se non superare, i sistemi più protetti e avanzati del mondo. Questa evoluzione spinge l’industria verso un futuro in cui il vero vantaggio competitivo non risiederà più nell’occultamento dei modelli, ma nella loro efficienza e nell’abilità di integrarli e personalizzarli in applicazioni reali.