Alimentato dai progressi dell’intelligenza artificiale (AI), i sistemi di riconoscimento facciale si stanno diffondendo come nodi. Facebook, un social network, utilizza la tecnologia per etichettare le persone nelle fotografie caricate. Gli smartphone moderni possono essere sbloccati con esso. Alcune banche lo impiegano per verificare le transazioni. I supermercati guardano per i bevitori minorenni. I cartelloni pubblicitari valutano le reazioni dei consumatori ai loro contenuti. Il Dipartimento americano per la sicurezza interna ritiene che il riconoscimento facciale esaminerà il 97% dei passeggeri delle compagnie aeree in uscita entro il 2023. Le reti di telecamere per il riconoscimento facciale fanno parte dello stato di polizia che la Cina ha costruito nello Xinjiang, nell’estremo ovest del paese. E un certo numero di forze di polizia britanniche hanno testato la tecnologia come strumento di sorveglianza di massa nei processi progettati per individuare i criminali sulla strada.

Un contraccolpo, tuttavia, sta producendo. Le autorità di diverse città americane, tra cui San Francisco e Oakland, hanno proibito alle agenzie come la polizia di utilizzare la tecnologia. In Gran Bretagna, i membri del parlamento hanno chiesto, finora senza successo, un divieto di test di polizia. I refusenik possono anche prendere in mano la situazione cercando di nascondere i loro volti alle telecamere o, come è accaduto di recente durante le proteste a Hong Kong, puntando i laser portatili verso le telecamere a circuito chiuso. per stupirli. Nel frattempo, un piccolo ma crescente gruppo di attivisti e accademici sulla privacy sta cercando modi per sovvertire direttamente la tecnologia sottostante.

Metti la tua faccia migliore in avanti

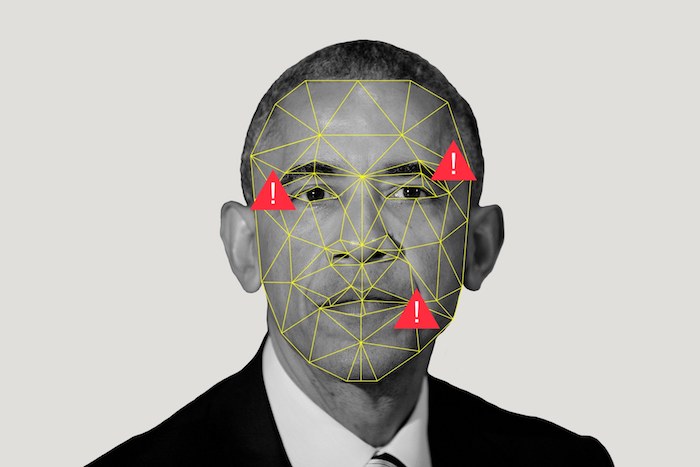

Il riconoscimento facciale si basa sull’apprendimento automatico, un sottocampo dell’IA in cui i computer si insegnano a svolgere compiti che i loro programmatori non sono in grado di spiegare loro in modo esplicito. Innanzitutto, un sistema viene addestrato su migliaia di esempi di volti umani. Premiandolo quando identifica correttamente un volto e penalizzandolo quando non lo fa, può essere insegnato a distinguere le immagini che contengono i volti da quelle che non lo fanno. Una volta che ha un’idea dell’aspetto di una faccia, il sistema può quindi iniziare a distinguere una faccia da un’altra. Le specifiche variano a seconda dell’algoritmo, ma di solito implicano una rappresentazione matematica di un numero di punti anatomici cruciali, come la posizione del naso rispetto ad altre caratteristiche facciali o la distanza tra gli occhi.

Nei test di laboratorio, tali sistemi possono essere estremamente precisi. Un sondaggio del NIST, un ente per la definizione degli standard americani, ha rilevato che, tra il 2014 e il 2018, la capacità del software di riconoscimento facciale di abbinare l’immagine di una persona nota con l’immagine di quella persona contenuta in un database è migliorata dal 96% al 99,8%. Ma poiché le macchine si sono insegnate da sole, i sistemi visivi che hanno creato sono personalizzati. La visione artificiale, in altre parole, non assomiglia al genere umano. E questo può fornire molte crepe nell’armatura di un algoritmo.

Nel 2010, ad esempio, nell’ambito di una tesi per un master alla New York University, un ricercatore e artista americano di nome Adam Harvey ha creato “CV [computer vision] Dazzle”, uno stile di trucco progettato per ingannare i riconoscitori del viso. Utilizza colori vivaci, contrasto elevato, sfumature graduali e stili asimmetrici per confondere i presupposti di un algoritmo su come appare un viso. Per un essere umano, il risultato è ancora chiaramente un volto. Ma un computer – o, almeno, l’algoritmo specifico a cui stava puntando Harvey – è sconcertato.

È probabile che un trucco drammatico attiri più attenzione da parte di altre persone rispetto a quando non viene deviato dalle macchine. HyperFace è un nuovo progetto di Harvey’s. Dove CV Dazzle mira a modificare i volti, HyperFace mira a nasconderli tra dozzine di falsi. Utilizza schemi a blocchi, semi-astratti e relativamente innocenti, progettati per attrarre il più fortemente possibile i classificatori. L’idea è di nascondere la cosa vera in un mare di falsi positivi. Sono già disponibili abiti con il motivo, che presenta linee e set di macchie scure che ricordano vagamente bocche e paia di occhi.

Un’idea ancora più sottile è stata proposta dai ricercatori dell’Università cinese di Hong Kong, Bloomington dell’Università dell’Indiana e Alibaba, una grande azienda cinese di informatica, in un documento pubblicato nel 2018. È un cappellino da baseball dotato di minuscoli diodi emettitori di luce che proiettano punti infrarossi sul viso di chi lo indossa. Molte delle telecamere utilizzate nei sistemi di riconoscimento facciale sono sensibili a parti dello spettro infrarosso. Poiché gli occhi umani non lo sono, la luce a infrarossi è l’ideale per l’inganno nascosto.

Nei test contro FaceNet, un sistema di riconoscimento facciale sviluppato da Google, i ricercatori hanno scoperto che la giusta quantità di illuminazione a infrarossi poteva impedire in modo affidabile a un computer di riconoscere che stava guardando un volto. Sono stati possibili anche attacchi più sofisticati. Cercando volti matematicamente simili a quelli di uno dei loro colleghi e applicando un controllo accurato ai diodi, i ricercatori hanno convinto FaceNet, con il 70% dei tentativi, che il collega in questione era in realtà qualcun altro.

Addestrare un algoritmo per ingannarne un altro è noto come apprendimento automatico contraddittorio. È un approccio produttivo, che crea immagini fuorvianti per la visione di un computer, mentre appare insignificante per quella di un essere umano. Un articolo, pubblicato nel 2016 da ricercatori della Carnegie Mellon University di Pittsburgh e dell’Università della Carolina del Nord, mostrava come motivi astratti dall’aspetto innocuo, stampati su carta e attaccati alla cornice di un paio di occhiali, potessero spesso convincere un computer -visione del sistema secondo cui un ricercatore di intelligenza artificiale di sesso maschile era in effetti Milla Jovovich, un’attrice americana.

In un documento simile, presentato a una conferenza sulla visione artificiale a luglio, un gruppo di ricercatori dell’Università Cattolica di Lovanio, in Belgio, ha ingannato i sistemi di riconoscimento delle persone piuttosto che quelli di riconoscimento del volto. Hanno descritto un modello generato algoritmicamente che era di 40 cm quadrati. Nei test, semplicemente sollevare un pezzo di cartone con questo schema su di esso era abbastanza per far scomparire un individuo – che sarebbe eminentemente visibile a una guardia di sicurezza umana – alla vista di un guardiano informatizzato.

Come ammettono i ricercatori stessi, tutti questi sistemi hanno dei vincoli. In particolare, la maggior parte lavora solo contro specifici algoritmi di riconoscimento, limitandone la schierabilità. Fortunatamente, afferma Harvey, anche se il riconoscimento facciale si sta diffondendo, non è ancora onnipresente – o perfetto. Uno studio condotto da ricercatori dell’Università dell’Essex, pubblicato a luglio, ha rilevato che sebbene un processo di polizia a Londra abbia segnalato 42 potenziali incontri, solo otto si sono dimostrati accurati. Anche in Cina, afferma Harvey, solo una frazione delle telecamere a circuito chiuso raccoglie immagini sufficientemente nitide da consentire il riconoscimento facciale. Anche gli approcci a bassa tecnologia possono aiutare. “Anche piccole cose come indossare un dolcevita, indossare occhiali da sole, guardare il telefono [e quindi non le telecamere] – insieme hanno un effetto protettivo”.