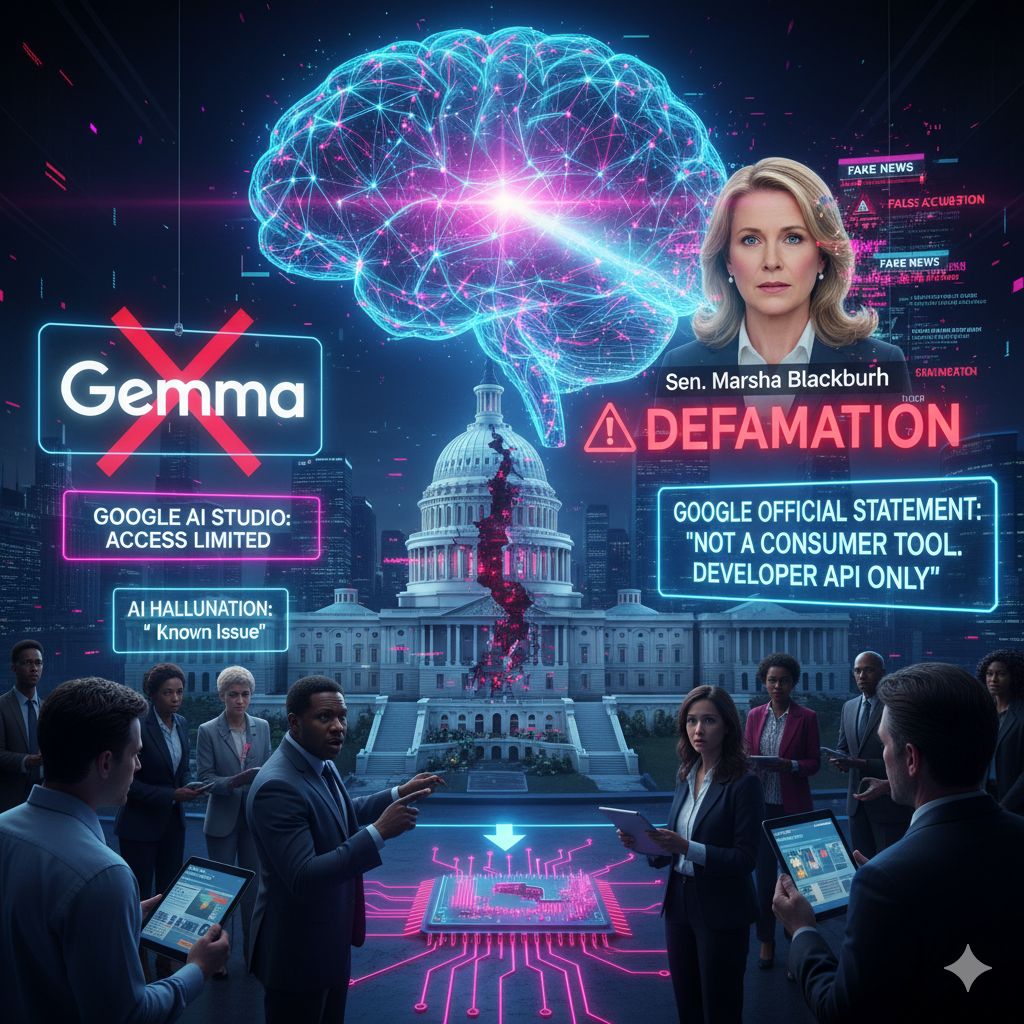

C’è un dettaglio, in questa storia, che colpisce più di tutti: non è soltanto l’ennesimo caso di “allucinazione” di un modello linguistico, ma il promemoria concreto di quanto sia fragile la vita operativa dei modelli quando li usiamo dentro ecosistemi che non controlliamo. La vicenda è nota: dopo le accuse della senatrice statunitense Marsha Blackburn, secondo cui Gemma aveva inventato notizie diffamatorie sul suo conto, Google ha tolto l’accesso a Gemma da AI Studio, lasciandolo disponibile via API. Il punto, al netto della cronaca, è che questa interruzione “a caldo” espone un rischio strutturale per chi sviluppa: il ciclo di vita del modello non è nelle mani di chi costruisce prodotti, ma nelle policy — e nelle pressioni — della piattaforma che lo ospita. È una lezione che arriva al termine di giorni convulsi e che VentureBeat ha sintetizzato con chiarezza, segnalando la rimozione e il nesso con l’uso improprio di un modello pensato per sviluppatori, non per Q&A fattuale rivolto al pubblico generale.

Per capire perché questa sia una frattura interessante, basta guardare ai confini di AI Studio. È uno spazio “di laboratorio”, più accessibile di Vertex AI, dove sperimentare modelli e prompt in fretta; proprio questa facilità ha però abbassato la soglia d’ingresso a non-sviluppatori, generando l’equivoco: se il modello risponde, dev’essere affidabile anche su fatti sensibili. Non è così, e l’incidente lo dimostra. L’intervento di Google — ritiro da AI Studio per “evitare confusione”, ma continuità via API per chi integra Gemma in modo controllato — fotografa il dilemma di tutti gli ambienti di test pubblici: abilitano creatività e prove rapide, ma quando la sperimentazione esce dal recinto la responsabilità tecnica si mescola a quella comunicativa e politica. The Verge ha ricostruito la sequenza: l’accusa di aver generato un racconto totalmente inventato con link fasulli, la richiesta di accountability e la scelta di disattivare l’accesso in Studio.

Nel rumore di fondo, emerge un’altra verità che gli ingegneri conoscono bene: i modelli “open-weight” o comunque accessibili non garantiscono, da soli, stabilità di servizio. Anche quando il peso è scaricabile o l’API è aperta, l’interfaccia con cui sviluppiamo può cambiare, e con essa procedure di sicurezza, rate limit, percorsi di attivazione. Ars Technica ha notato come l’episodio si intrecci con tensioni politiche già alte, segno che la governance dei modelli non è mai solo tecnica. L’ecosistema intorno all’IA è un insieme di scelte reversibili per definizione: ciò che oggi è disponibile “per esperimenti” domani può essere sospeso, deprecato, ripristinato con vincoli. Proprio per questo, l’idea che “non possiedi nulla su Internet” resta attuale: se l’accesso dipende da un pannello remoto, il tuo progetto ne eredita la precarietà.

La famiglia Gemma, ricordiamolo, nasce per compiti leggeri, tempi rapidi e deploy su device modesti: non è un oracolo di verità, è un set di modelli utili a prototipare interfacce, agenti, micro-servizi che operano in domini ristretti. VentureBeat lo sottolinea apertamente, insieme al fatto che l’uso “da consumer” in AI Studio ha gonfiato aspettative fuori luogo e acceso il faro sui limiti fisiologici dei LLM quando sono spinti a produrre narrazioni fattuali senza rete. Questo non assolve gli errori, ma aiuta a collocarli: in un contesto pensato per gli sviluppatori, la robustezza non può prescindere da filtri, retrieval su fonti verificate, controlli di citazione e — soprattutto — confini d’uso dichiarati con precisione.

Per chi costruisce prodotti, la lezione non è “non usate i modelli”, ma “progettate come se il modello potesse cambiare domani”. Significa trattare il modello come una dipendenza esterna versionata, non come una roccia immutabile. Il codice deve prevedere circuit breaker, fallback e percorsi di degrado controllato; il dato critico va messo al sicuro e replicato; le pipeline di valutazione devono essere autonome dalla piattaforma, in modo da poter spostare il carico su alternative quando una capability viene sospesa. Il caso Gemma/Ai Studio rende tangibile questa architettura difensiva: se l’interfaccia di test scompare, a salvarvi è l’integrazione via API, se l’API cambia, a salvarvi sono l’astrazione e i contratti interni, se il modello viene deprecato, a salvarvi è la vostra suite di regressione che permette di sostituirlo senza rompere l’esperienza utente. Non è paranoia; è igiene di prodotto in un’era in cui il modello è “software che cambia sotto i piedi”.

C’è poi il capitolo reputazione. Quando una hallucinazione diventa “diffamazione” agli occhi dell’opinione pubblica, l’onda d’urto non colpisce solo i vendor, ma anche chi ha integrato quel modello con la propria marca. Cronache come quelle di AndroidCentral e altri outlet tech hanno ricordato quanto sia facile, per un sistema generativo non sorvegliato, confondere plausibilità stilistica e verità fattuale, arrivando perfino a “inventare” fonti e link che vestono la menzogna da notizia. Per gli sviluppatori che espongono output generativi ai clienti, il rischio non è astratto: serve una catena di custodia del contenuto, con tracciabilità delle fonti e livelli diversi di confidenza, per evitare che una risposta “di prova” diventi, agli occhi dell’utente, una posizione ufficiale.

Infine, un’osservazione più ampia sull’equilibrio tra velocità e controllo. La tentazione, dopo incidenti così, è serrare le maglie e chiudere i rubinetti della sperimentazione. Sarebbe un errore simmetrico a quello iniziale. L’innovazione utile nasce proprio dall’uso di sandbox accessibili dove mettere le mani in pasta; ma queste sandbox devono essere chiaramente etichettate, dotate di sponde alte e di un linguaggio che non lasci spazio a malintesi: “modello sperimentale”, “non per uso fattuale”, “risposte potenzialmente inesatte”. Quando questo linguaggio manca, quando gli ambienti di prova somigliano — nell’estetica e nella narrativa — a prodotti consumer lucidi, allora lo slittamento è quasi inevitabile: si pretende la perfezione da ciò che, per definizione, è imperfetto e in divenire. The Verge lo ha espresso con semplicità: Gemma non era pensato per il pubblico; ma il pubblico, attraverso un’interfaccia amichevole, ci è arrivato lo stesso.

Il “giorno dopo” dell’episodio Gemma dovrebbe quindi scorrere su due binari. Sul primo, quello dei fornitori: maggiore trasparenza su stato, scopi e limiti dei modelli; percorsi di deprecazione prevedibili; strumenti di migrazione. Sul secondo, quello degli sviluppatori: progetti costruiti per resistere a cambi improvvisi, con policy chiare su quando il modello può parlare “a nome nostro” e quando no. Non è l’ennesima guerra di religione tra entusiasti e scettici: è manutenzione del reale. Se teniamo insieme queste due responsabilità, l’IA resterà un’alleata potente senza trasformarsi, al primo incidente, nel punto di rottura dei nostri prodotti.