Snippet: Con l’aumento delle dimensioni dei modelli linguistici, la complessità del calcolo aumenta e anche i Transformer hanno difficoltà a gestire contesti lunghi.

I modelli NLP elaborano il linguaggio generando rappresentazioni dello spazio vettoriale di lunghezza fissa o variabile. Queste rappresentazioni di singole parole vengono utilizzate per aggregare informazioni da parole adiacenti per determinare il significato di un prompt specifico o di una frase nel contesto in cui viene utilizzato. Grazie all’architettura Transformer , l’apprendimento contestuale ha migliorato i modelli linguistici. Il lavoro seminale del 2017 intitolato “Attention Is All You Need” di A Vaswani et al. ha creato un effetto a cascata che ha consentito alle macchine di comprendere il linguaggio come mai prima d’ora. Guidata dai modelli Transformers, la rivoluzione NLP è diventata oggi un’industria multimiliardaria (ad esempio, BERT per la ricerca su Google). Il Transformer si basa su meccanismi di attenzione, eliminando completamente la ricorrenza e le convoluzioni. Una rete di trasformatoriapplica un meccanismo di auto-attenzione per scansionare ogni parola e classificarla con punteggi di attenzione (pesi).

Il trasformatore è costruito impilando blocchi composti da strati di auto-attenzione seguiti da strati completamente collegati. I modelli basati su trasformatore sono il cavallo di battaglia di molte applicazioni basate sulla NLP. Tuttavia, con l’aumento delle dimensioni dei modelli linguistici, la complessità di calcolo aumenta e anche i Transformer hanno difficoltà a gestire contesti lunghi. Gli esseri umani hanno una notevole capacità di ricordare il contesto a lungo termine, il che rende la loro comunicazione più efficiente. Mentre i modelli linguistici soffrono di dimenticanza del contesto. La quantità di calcolo richiesta cresce con la lunghezza del contesto e quindi la modellazione delle memorie a lungo termine può essere inefficiente.

(via Paper di Lampe et al.,)

Tuttavia, se a un sistema è consentito aumentare il numero di parametri mantenendo lo stesso budget computazionale ospitando livelli di memoria di grandi dimensioni, può aumentare significativamente la capacità dell’architettura con un sovraccarico computazionale trascurabile. Un paio di anni fa, i ricercatori di Facebook hanno introdotto Memory Layers nei modelli linguistici.

In un livello di memoria chiave-valore, l’input viene solitamente elaborato attraverso una rete di query che produce un vettore di query rispetto al resto delle chiavi. Qui, l’output è una somma ponderata sparsa sulle memorie associate ai tasti selezionati. Una manciata di slot di memoria vengono aggiornati per ogni input durante l’allenamento poiché la scarsità della selezione delle chiavi e gli aggiornamenti dei parametri rendono l’allenamento e l’inferenza molto efficienti. Con i livelli di memoria chiave, hanno affermato i ricercatori di Facebook, l’aggiunta di un livello di memoria è più vantaggioso che aumentare il numero di livelli. Ora, ricercatori di varie istituzioni in Europa, tra cui DeepMind, hanno collaborato allo sviluppo∞-former o infiniti-former, un trasformatore di memoria infinita che consente una memoria illimitata a lungo termine. Per rendere ciò possibile, i ricercatori hanno utilizzato una struttura di attenzione nello spazio continuo che scambia il numero di unità di informazione che si adattano alla memoria (funzioni di base) con la granularità delle loro rappresentazioni.

Circa ∞-ex

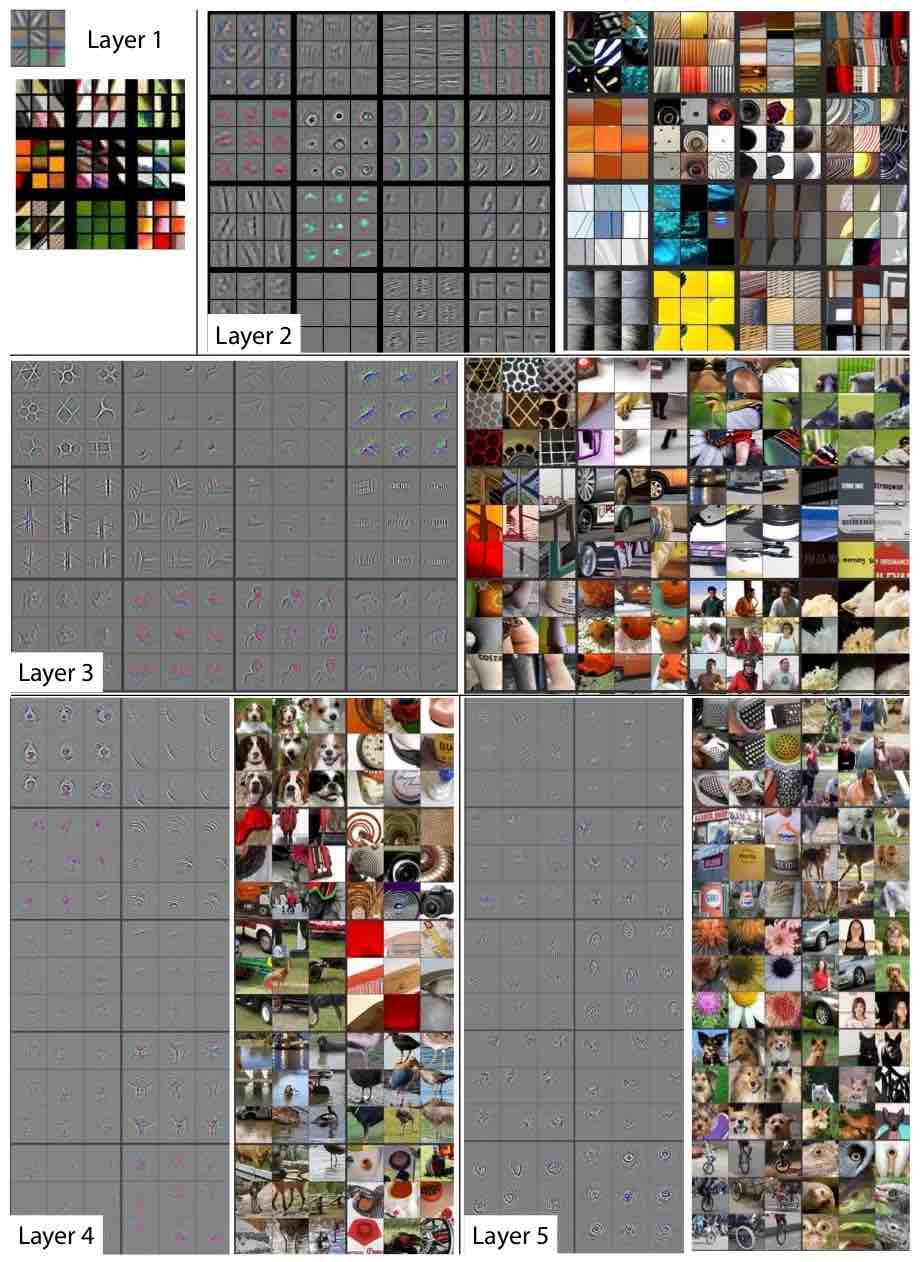

Il diagramma dell’attenzione di ∞-ex tramite un documento di Martins et al.

Per consentire al modello di accedere al contesto a lungo raggio, i ricercatori hanno esteso il trasformatore vanilla con una memoria LTM continua a lungo termine, che memorizza gli incorporamenti di input e gli stati nascosti dei passaggi precedenti. Quando si rappresenta la memoria, hanno scritto i ricercatori, come una sequenza discreta, i nuovi stati nascosti dovrebbero essere archiviati nella memoria. Questo non è fattibile per i trasformatori vanilla quando si tratta di contesti lunghi poiché i requisiti di memoria sono più elevati. Tuttavia, il ∞-ex afferma che i ricercatori possono occuparsi di un contesto illimitato senza aumentare i requisiti di memoria usando l’attenzione continua.

Il ∞-former è in grado di modellare contesti lunghi, grazie al suo framework di attenzione nello spazio continuo in grado di gestire la complessità computazionale indipendentemente dalla lunghezza del contesto. Ciò consente inoltre al modello di gestire contesti lunghi mantenendo fisso il budget di calcolo. Aggiornando la memoria con l’utilizzo passato, il modello impara a conservare “ricordi appiccicosi”. I ricordi appiccicosi sono una procedura che impone la persistenza di informazioni importanti nella memoria a lungo termine. Per convalidare le prestazioni del ∞-former rispetto a contesti lunghi, i ricercatori hanno eseguito esperimenti addestrando un modello da zero e mettendo a punto un modello linguistico pre-addestrato.

I ricercatori hanno progettato una distribuzione di probabilità dei token che cambia nel tempo per garantire che la memoria a lungo termine (LTM) venga utilizzata in modo efficace e che il Transformer non stia ordinando modellando i token più recenti. Nel processo di ordinamento, un input costituito da una sequenza di token viene campionato in base a una distribuzione di probabilità di token, di cui il sistema è ignaro. L’obiettivo qui è generare i token nell’ordine decrescente delle loro frequenze nella sequenza.

Per gli esperimenti, i ricercatori hanno considerato un vocabolario di 20 token e sequenze di lunghezza 4.000, 8.000 e 16.000. Per tutti i modelli, hanno utilizzato un trasformatore con tre strati e sei testine di attenzione e hanno considerato sequenze di lunghezza 1.024 e dimensione della memoria 2.048. Per il Transformer compressivo, hanno utilizzato memorie con una dimensione di 1.024. Il ∞-ex ha anche una memoria a breve termine di dimensione 1.024 e un LTM con 1.024 funzioni di base.

Gli esperimenti condotti dai ricercatori su un’attività di smistamento sintetico mostrano che ∞-former mantiene un’elevata precisione mentre scala fino a lunghe sequenze. I ricercatori hanno concluso che la sperimentazione di modelli di addestramento da zero e la messa a punto di un modello linguistico pre-addestrato hanno mostrato miglioramenti nella perplessità. Infini-former affronta la sfida di lunga data della memoria illimitata per il contesto, che è cruciale se i BERT e i GPT di domani dovessero aiutare a costruire chatbot migliori, risultati di ricerca migliori sul Web o persino aiutare nella traduzione dal vivo per i diplomatici.

DI RAM SAGAR da analyticsindiamag.com