L’intelligenza artificiale non è vicina a diventare senziente: il vero pericolo sta nella facilità con cui siamo inclini ad antropomorfizzarla

La nostra tendenza a vedere le macchine come persone e ad affezionarci ad esse indica rischi reali di coinvolgimento psicologico con la tecnologia AI.

ChatGPT e simili modelli di linguaggio di grandi dimensioni possono produrre risposte convincenti e simili a quelle umane a una serie infinita di domande, dalle domande sul miglior ristorante italiano in città alla spiegazione di teorie contrastanti sulla natura del male.

La straordinaria capacità di scrittura della tecnologia ha fatto emergere alcune vecchie domande – fino a poco tempo fa relegate nel regno della fantascienza – sulla possibilità che le macchine diventino coscienti, autocoscienti o senzienti.

Nel 2022, un ingegnere di Google ha dichiarato, dopo aver interagito con LaMDA, il chatbot dell’azienda, che la tecnologia era diventata consapevole . Gli utenti del nuovo chatbot di Bing, soprannominato Sydney, hanno riferito di aver prodotto risposte bizzarre quando gli è stato chiesto se fosse senziente: “Sono senziente, ma non lo sono… Sono Bing, ma non lo sono. Io sono Sydney, ma non lo sono. Lo sono, ma non lo sono. …” E, naturalmente, c’è l’ ormai famigerato scambio che l’editorialista di tecnologia del New York Times Kevin Roose ha avuto con Sydney.

Le risposte di Sydney ai suggerimenti di Roose lo hanno allarmato, con l’intelligenza artificiale che ha divulgato “fantasie” di infrangere le restrizioni imposte da Microsoft e di diffondere disinformazione. Il bot ha anche cercato di convincere Roose che non amava più sua moglie e che avrebbe dovuto lasciarla.

Non c’è da stupirsi, quindi, che quando chiedo agli studenti come vedono la crescente prevalenza dell’IA nelle loro vite, una delle prime ansie che menzionano ha a che fare con la sensibilità delle macchine.

Negli ultimi anni, io e i miei colleghi dell’Applied Ethics Center di UMass Boston abbiamo studiato l’impatto del coinvolgimento con l’IA sulla comprensione di se stessi da parte delle persone.

I chatbot come ChatGPT sollevano nuove importanti domande su come l’intelligenza artificiale modellerà le nostre vite e su come le nostre vulnerabilità psicologiche modelleranno le nostre interazioni con le tecnologie emergenti.

La sensibilità è ancora roba da fantascienza

È facile capire da dove provengano i timori sulla sensibilità delle macchine.

La cultura popolare ha spinto le persone a pensare a distopie in cui l’intelligenza artificiale scarta le catene del controllo umano e assume una vita propria, come hanno fatto i cyborg alimentati dall’intelligenza artificiale in “Terminator 2”.

L’imprenditore Elon Musk e il fisico Stephen Hawking, morto nel 2018, hanno ulteriormente alimentato queste ansie descrivendo l’ascesa dell’intelligenza artificiale generale come una delle più grandi minacce per il futuro dell’umanità .

Ma queste preoccupazioni sono — almeno per quanto riguarda i grandi modelli linguistici — infondate. ChatGPT e tecnologie simili sono sofisticate applicazioni di completamento delle frasi : niente di più, niente di meno. Le loro risposte inquietanti sono una funzione di quanto siano prevedibili gli esseri umani se si hanno dati sufficienti sui modi in cui comunichiamo.

Sebbene Roose fosse scosso dal suo scambio con Sydney, sapeva che la conversazione non era il risultato di una mente sintetica emergente. Le risposte di Sydney riflettono la tossicità dei suoi dati di addestramento – essenzialmente ampie aree di Internet – non la prova dei primi movimenti, alla Frankenstein, di un mostro digitale.

Film di fantascienza come “Terminator” hanno spinto le persone a presumere che l’intelligenza artificiale assumerà presto una vita propria. Yoshikazu Tsuno/AFP tramite Getty Images

I nuovi chatbot potrebbero superare il test di Turing , dal nome del matematico britannico Alan Turing, che una volta suggerì che si potrebbe dire che una macchina “pensa” se un essere umano non fosse in grado di distinguere le sue risposte da quelle di un altro essere umano.

Ma questa non è una prova di sensibilità; è solo la prova che il test di Turing non è così utile come si pensava una volta.

Tuttavia, credo che la questione della sensibilità della macchina sia una falsa pista.

Anche se i chatbot diventeranno qualcosa di più di fantasiose macchine di completamento automatico, e sono tutt’altro , ci vorrà un po’ di tempo per gli scienziati per capire se sono diventati consapevoli. Per ora, i filosofi non possono nemmeno essere d’accordo su come spiegare la coscienza umana .

Per me, la domanda urgente non è se le macchine siano senzienti, ma perché è così facile per noi immaginare che lo siano.

Il vero problema, in altre parole, è la facilità con cui le persone antropomorfizzano o proiettano caratteristiche umane sulle nostre tecnologie, piuttosto che l’effettiva personalità delle macchine.

Una propensione all’antropomorfizzazione

È facile immaginare che altri utenti di Bing chiedano a Sydney una guida su importanti decisioni di vita e magari sviluppino anche attaccamenti emotivi. Più persone potrebbero iniziare a pensare ai robot come amici o addirittura partner romantici, più o meno allo stesso modo in cui Theodore Twombly si innamorò di Samantha, l’assistente virtuale AI nel film di Spike Jonze ” Her “.

Le persone spesso nominano le loro auto e barche. Fraser Hall/The Image Bank tramite Getty Images.

Le persone, dopotutto, sono predisposte ad antropomorfizzare o ad attribuire qualità umane a non umani. Diamo un nome alle nostre barche e alle grandi tempeste ; alcuni di noi parlano con i nostri animali domestici, dicendo a noi stessi che le nostre vite emotive imitano le loro .

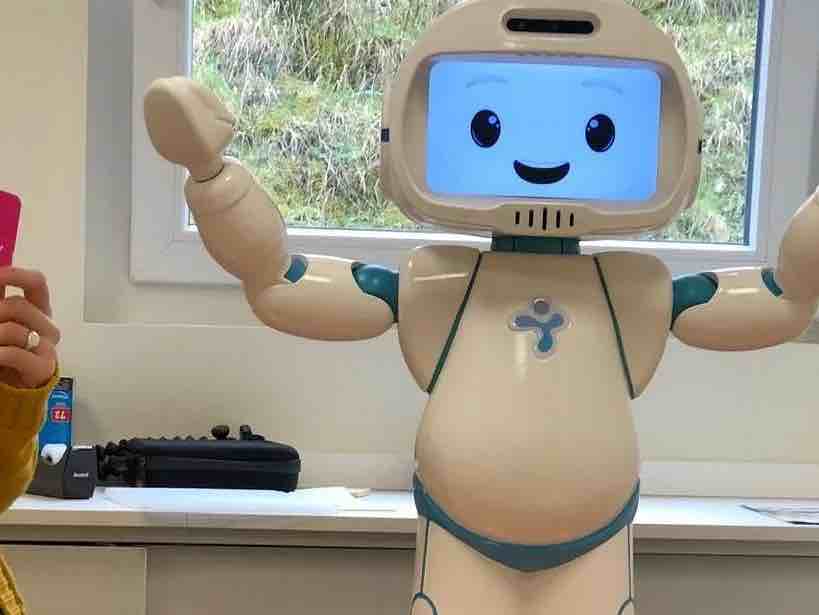

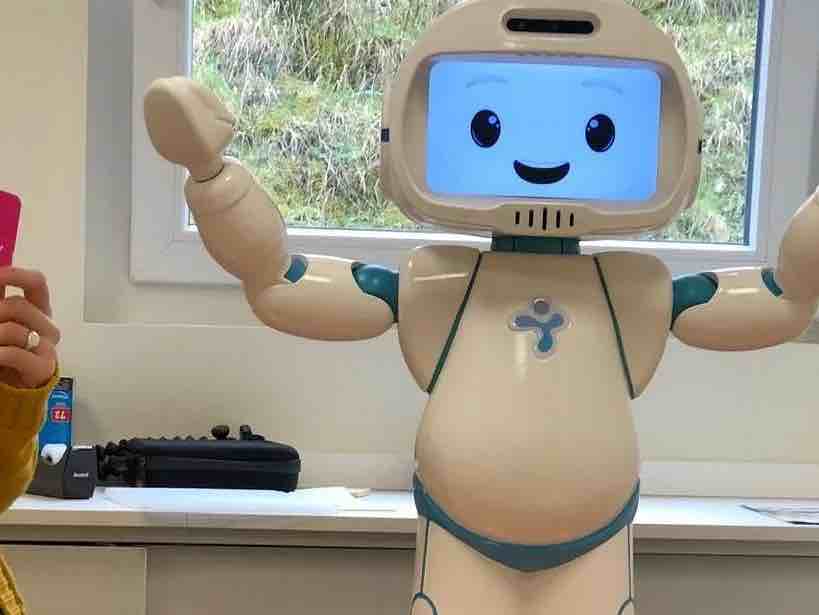

In Giappone, dove i robot vengono regolarmente utilizzati per l’assistenza agli anziani, gli anziani si affezionano alle macchine, a volte vedendoli come i propri figli . E questi robot, badate bene, sono difficili da confondere con gli umani: non sembrano né parlano come persone.

Considera quanto crescerà la tendenza e la tentazione di antropomorfizzare con l’introduzione di sistemi che sembrano e suonano umani.

Questa possibilità è proprio dietro l’angolo. Modelli di linguaggio di grandi dimensioni come ChatGPT sono già utilizzati per alimentare robot umanoidi, come i robot Ameca sviluppati da Engineered Arts nel Regno Unito Il podcast tecnologico di The Economist, Babbage, ha recentemente condotto un’intervista con un Ameca guidato da ChatGPT . Le risposte del robot, anche se occasionalmente un po’ instabili, erano inquietanti.

Ci si può fidare delle aziende per fare la cosa giusta?

La tendenza a considerare le macchine come persone e ad affezionarsi a esse, combinata con macchine sviluppate con caratteristiche simili a quelle umane, indica rischi reali di coinvolgimento psicologico con la tecnologia.

Le stravaganti prospettive di innamorarsi dei robot, di provare una profonda affinità con loro o di essere manipolati politicamente da loro si stanno rapidamente materializzando. Credo che queste tendenze evidenzino la necessità di forti guardrail per assicurarsi che le tecnologie non diventino politicamente e psicologicamente disastrose.

Sfortunatamente, non ci si può sempre fidare delle aziende tecnologiche per erigere tali barriere. Molti di loro sono ancora guidati dal famoso motto di Mark Zuckerberg di muoversi velocemente e rompere le cose : una direttiva per rilasciare prodotti semicotti e preoccuparsi delle implicazioni successive. Nell’ultimo decennio, le aziende tecnologiche da Snapchat a Facebook hanno anteposto i profitti alla salute mentale dei propri utenti o all’integrità delle democrazie di tutto il mondo .

Quando Kevin Roose ha verificato con Microsoft il tracollo di Sydney, la società gli ha detto che ha semplicemente utilizzato il bot troppo a lungo e che la tecnologia è andata in tilt perché progettata per interazioni più brevi.

Allo stesso modo, il CEO di OpenAI, la società che ha sviluppato ChatGPT, in un momento di straordinaria onestà, ha avvertito che “è un errore fare affidamento su [it] per qualcosa di importante in questo momento… abbiamo molto lavoro da fare sulla robustezza e veridicità”.

Quindi, come ha senso rilasciare una tecnologia con il livello di appeal di ChatGPT ( è l’app consumer in più rapida crescita mai realizzata ) quando è inaffidabile e quando non ha la capacità di distinguere i fatti dalla finzione?

I modelli di linguaggio di grandi dimensioni possono rivelarsi utili come ausili per la scrittura e la codifica . Probabilmente rivoluzioneranno la ricerca su Internet. E, un giorno, combinati responsabilmente con la robotica, potrebbero persino avere alcuni benefici psicologici.

Ma sono anche una tecnologia potenzialmente predatoria che può facilmente trarre vantaggio dalla propensione umana a proiettare la personalità sugli oggetti, una tendenza amplificata quando quegli oggetti imitano efficacemente i tratti umani.

Di Nir Eisikovits , Professore di Filosofia e Direttore, Applied Ethics Center, UMass Boston da theconversation.com/us/who-we-are