I ricercatori progettano un’IA che può dedurre intere planimetrie da brevi video clip

Le planimetrie sono utili per visualizzare gli spazi, pianificare percorsi e comunicare progetti architettonici. Un robot che entra in un nuovo edificio, ad esempio, può utilizzare una planimetria per rilevare rapidamente la disposizione complessiva. La creazione di planimetrie in genere richiede una procedura dettagliata completa in modo che i sensori 3D e le telecamere possano catturare l’intero spazio. Ma i ricercatori di Facebook, dell’Università del Texas ad Austin e della Carnegie Mellon University stanno esplorando una tecnica di intelligenza artificiale che sfrutta immagini e audio per ricostruire una planimetria da un breve video clip.

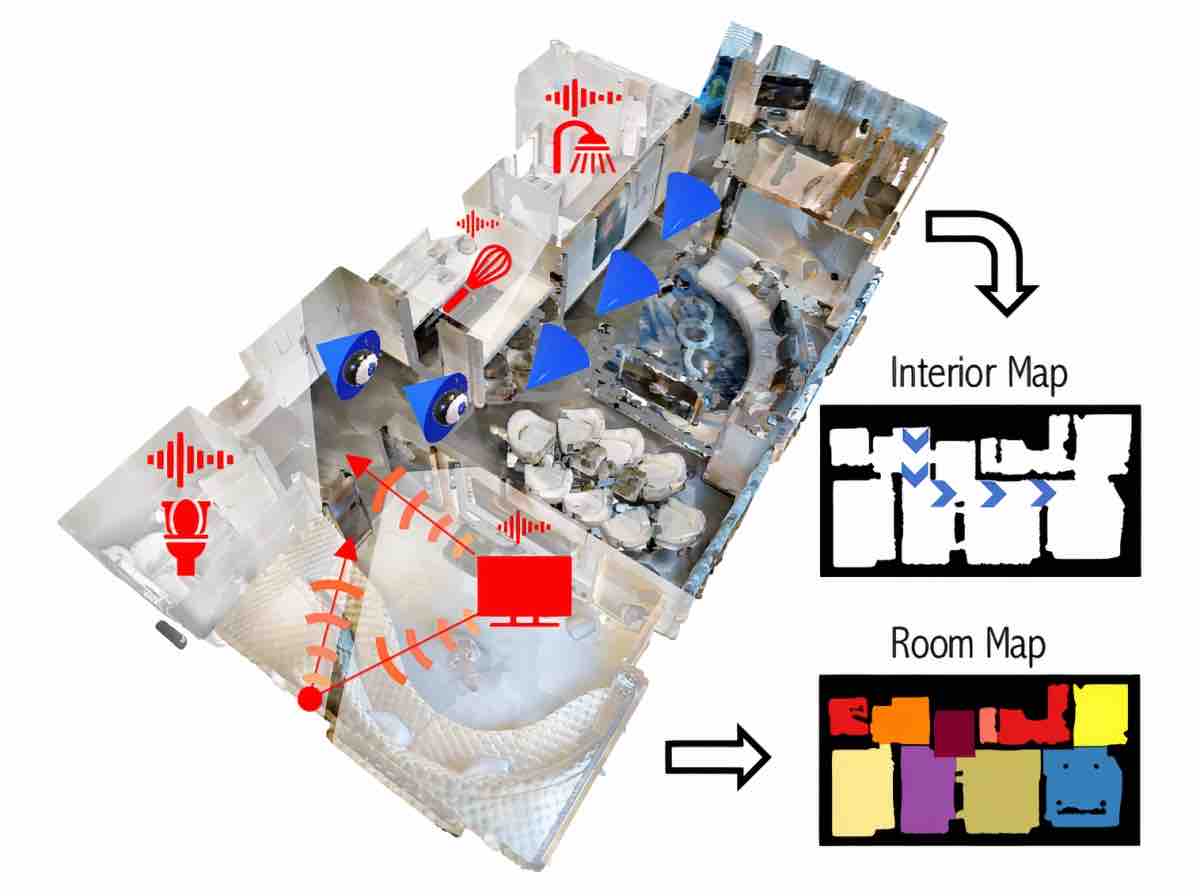

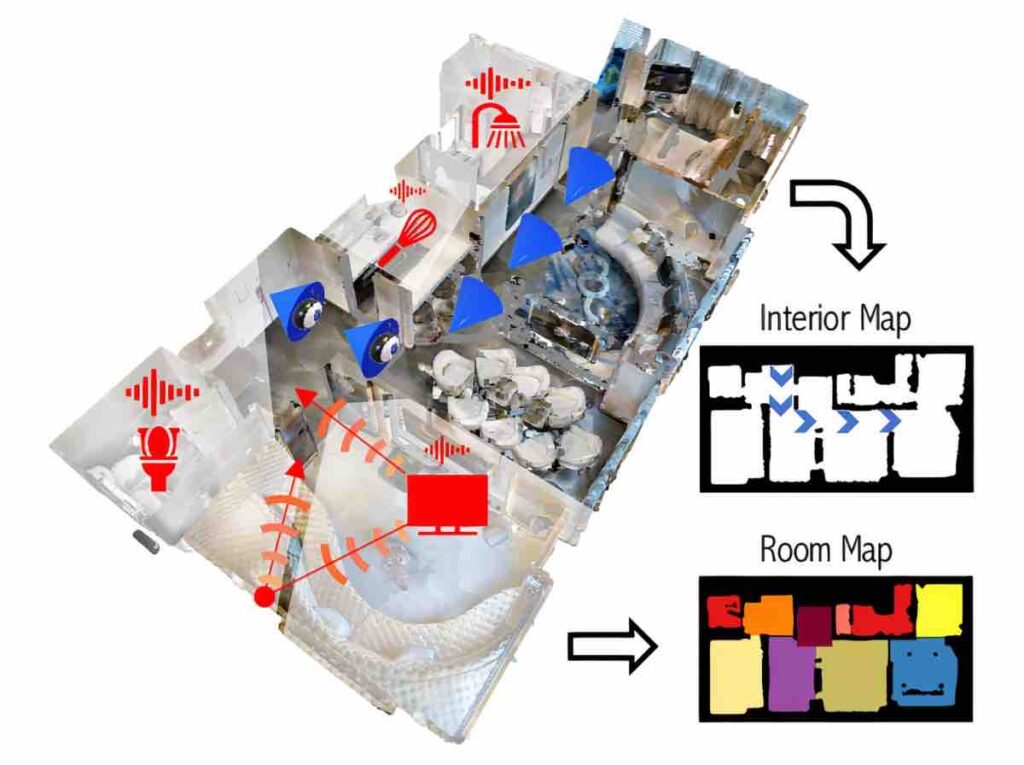

I ricercatori affermano che l’audio fornisce segnali spaziali e semantici che completano le capacità di mappatura delle immagini. Dicono che ciò sia dovuto al fatto che il suono è intrinsecamente guidato dalla geometria degli oggetti. I riflessi audio rimbalzano sulle superfici e rivelano la forma di una stanza, ben oltre il campo visivo di una telecamera. I suoni uditi da lontano, anche da più stanze, possono rivelare l’esistenza di “spazi liberi” in cui potrebbero esistere oggetti che suonano (ad esempio, un cane che abbaia in un’altra stanza). Inoltre, sentire i suoni provenienti da direzioni diverse espone layout basati sulle attività o sulle cose che quei suoni rappresentano. Una doccia che scorre potrebbe suggerire la direzione del bagno, ad esempio, mentre i segnali acustici del microonde suggeriscono una cucina.

L’approccio dei ricercatori, che chiamano AV-Map, mira a convertire brevi video con audio multicanale in planimetrie 2D. Un modello di apprendimento automatico sfrutta sequenze di dati audio e video per ragionare sulla struttura e la semantica della planimetria, fondendo infine informazioni da audio e video utilizzando un componente decoder. Le planimetrie generate da AV-Map, che si estendono notevolmente oltre l’area direttamente osservabile nel video, mostrano lo spazio libero e le regioni occupate suddivise in un insieme discreto di etichette semantiche della stanza (es. Camera familiare e cucina).

Il team ha sperimentato due impostazioni, attiva e passiva, in ambienti digitali dai famosi set di dati Matternet3D e SoundSpaces caricati nell’IA Habitat di Facebook . Nel primo, hanno utilizzato una telecamera virtuale per emettere un suono noto mentre si muoveva per la stanza di una casa modello. Nella seconda, si basavano solo su suoni naturali prodotti da oggetti e persone all’interno della casa.

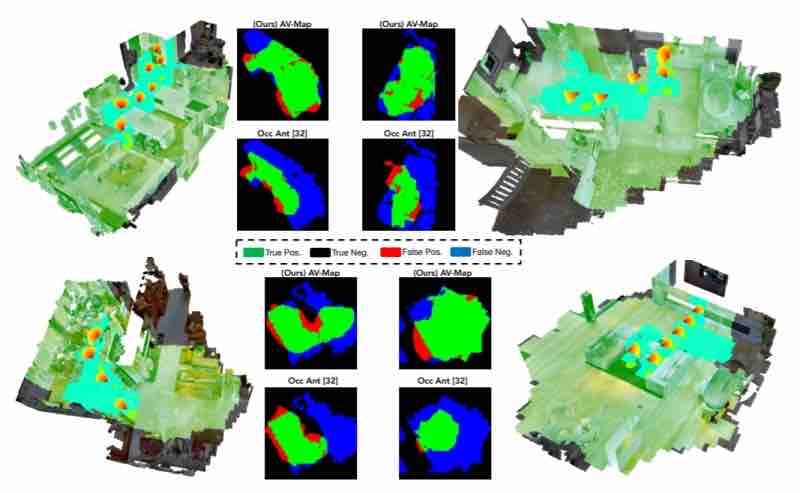

Attraverso i video registrati in 85 grandi ambienti multiroom del mondo reale all’interno di AI Habitat, i ricercatori affermano che AV-Map non solo ha costantemente superato la tradizionale mappatura basata sulla visione, ma ha migliorato la tecnica all’avanguardia per estrapolare le mappe di occupazione oltre le regioni visibili . Con solo pochi scorci che coprono il 26% di un’area, AV-Map potrebbe stimare l’intera area con una precisione del 66%.

“Una breve passeggiata video attraverso una casa può ricostruire le parti visibili della planimetria ma è cieco a molte aree. Introduciamo la ricostruzione audiovisiva della planimetria, in cui i suoni nell’ambiente aiutano a dedurre sia le proprietà geometriche delle aree nascoste che le etichette semantiche delle stanze non osservate (ad esempio, i suoni di una persona che cucina dietro un muro alla sinistra della telecamera suggeriscono la cucina) “, hanno scritto i ricercatori in un articolo dettagliato di AV-Map. “Nel lavoro futuro, abbiamo in programma di prendere in considerazione estensioni di planimetrie multilivello e collegare la nostra idea di mappatura a un agente robotico che controlla attivamente la telecamera … Per quanto ne sappiamo, il nostro è il primo tentativo di dedurre planimetrie da dati audiovisivi.”