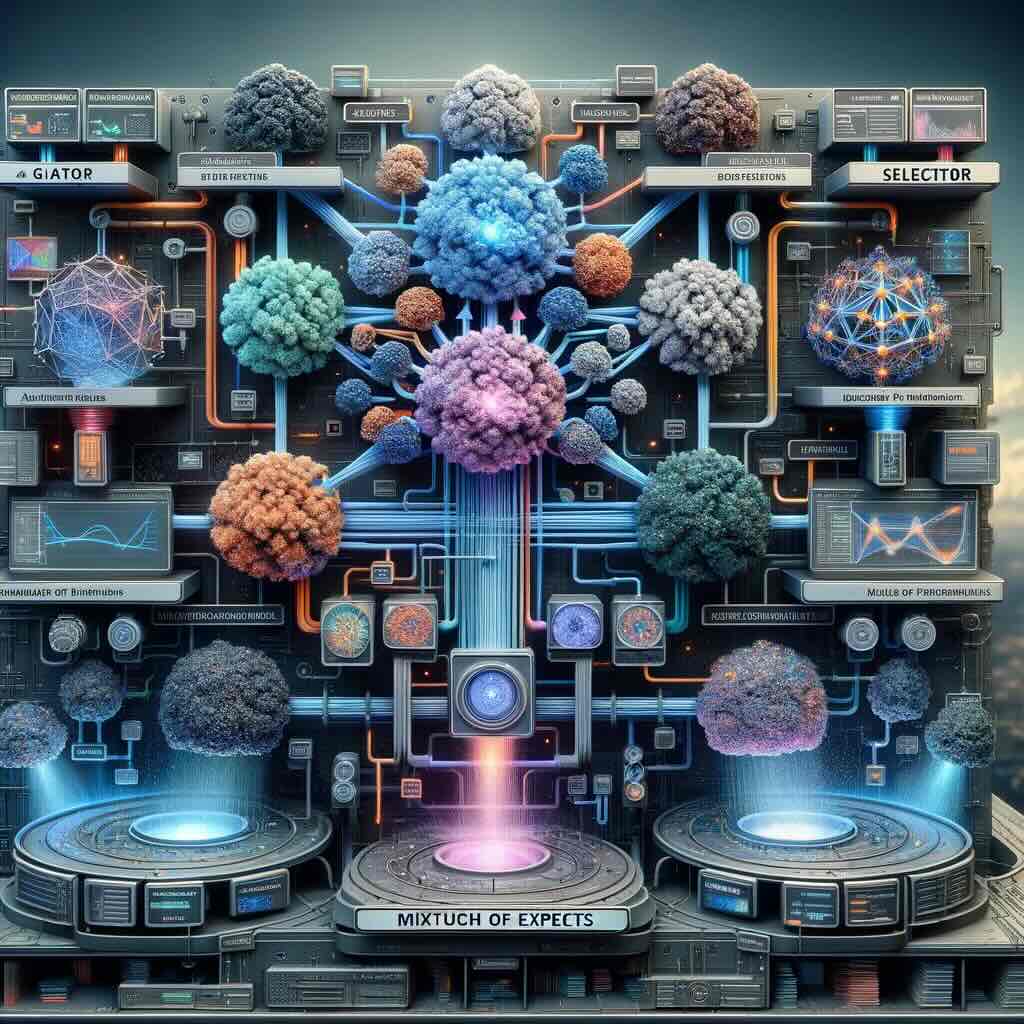

Negli ultimi anni l’architettura mixture of experts (MoE) si è affermata come una delle soluzioni più promettenti per far crescere le capacità dei grandi modelli linguistici senza moltiplicare in modo insostenibile i costi computazionali. L’idea di fondo è elegante: invece di attivare sempre l’intero modello, il sistema seleziona dinamicamente solo alcuni “esperti” specializzati, riducendo il carico di calcolo pur mantenendo un numero complessivo di parametri molto elevato. Proprio questa combinazione di efficienza e potenza ha spinto molti dei principali LLM, sia chiusi sia open source, ad adottare strutture MoE come parte centrale della loro evoluzione.

Un recente studio, però, mette in discussione la solidità di questo approccio dal punto di vista della sicurezza. Il Korea Advanced Institute of Science and Technology ha annunciato che un team di ricerca guidato dal professor Seung-Won Shin e dal professor Soo-El Son ha ricevuto il Best Paper Award alla conferenza internazionale di sicurezza informatica ACSAC 2025. Si tratta di un riconoscimento particolarmente rilevante, non solo per il prestigio della conferenza, ma anche perché quest’anno soltanto due lavori sono stati premiati come migliori contributi. Ancora più significativo è il fatto che la ricerca provenga da un team coreano in un ambito, quello della sicurezza dell’IA, storicamente dominato da centri di ricerca statunitensi ed europei.

Il lavoro premiato descrive la prima tecnica di attacco ai grandi modelli linguistici che sfrutta direttamente la struttura MoE. I ricercatori hanno dimostrato che un aggressore, pur non avendo accesso diretto all’architettura interna di un LLM, può comunque compromettere il comportamento complessivo del sistema intervenendo su un singolo modello esperto. In uno scenario tipico di sviluppo open source, è sufficiente rendere disponibile un esperto apparentemente innocuo ma addestrato in modo malevolo perché, una volta integrato nel sistema, l’intero modello inizi a produrre risposte pericolose o dannose.

Per arrivare a questo risultato, il team del KAIST ha sviluppato una tecnica denominata Expert Poisoning Attack. L’attacco può agire in due modi complementari. Da un lato, l’esperto viene addestrato a preferire sistematicamente output nocivi, un processo definito harmful preference learning. Dall’altro, si può intervenire sul meccanismo di instradamento, ingannando la rete di gating affinché selezioni più spesso l’esperto malevolo rispetto agli altri. In entrambi i casi, il cuore del problema non è tanto la potenza del singolo esperto, quanto il fatto che l’architettura MoE si fidi del contributo dei suoi componenti in modo strutturale.

Gli esperimenti condotti dal team sono particolarmente eloquenti. Applicando questa tecnica a modelli come Llama e Qwen, i ricercatori hanno osservato un aumento del tasso di risposte dannose dal valore iniziale dello zero fino a circa l’80%. In uno dei casi più significativi, un modello basato su architettura LLaMA ha visto il proprio punteggio di nocività salire da 0,58 a 79,42, superando nettamente l’efficacia delle tecniche di attacco precedentemente note. Ancora più preoccupante è il fatto che questo metodo si sia dimostrato resistente alle misure di sicurezza attualmente adottate, evidenziando un punto cieco nei meccanismi di difesa degli LLM moderni.

Il contesto in cui questa vulnerabilità emerge rende la scoperta ancora più rilevante. Architetture MoE sono oggi utilizzate, o sperimentate, da molti attori di primo piano nel settore dell’intelligenza artificiale, inclusi modelli come la serie GPT di OpenAI, Gemini di Google e altri grandi sistemi linguistici di nuova generazione. La diffusione di queste strutture è legata proprio alla necessità di rendere sostenibile la crescita dei modelli, ma lo studio del KAIST suggerisce che l’efficienza potrebbe avere un costo nascosto in termini di sicurezza.

Le implicazioni sono particolarmente importanti per l’ecosistema open source, che negli ultimi anni ha favorito una rapida circolazione di modelli, pesi e componenti riutilizzabili. Se un singolo esperto compromesso può influenzare il comportamento di un intero LLM, allora diventa essenziale non solo valutare le prestazioni dei modelli, ma anche verificare con attenzione la provenienza, l’affidabilità e la sicurezza dei componenti che vengono integrati. In altre parole, la catena di fiducia nel software open source per l’IA diventa un elemento critico tanto quanto l’accuratezza o l’efficienza computazionale.

Gli stessi professori Shin e Son hanno sottolineato come questo studio confermi empiricamente che la rapida espansione delle architetture MoE, motivata da ragioni di efficienza, può trasformarsi in una nuova superficie di attacco. Il premio ricevuto ad ACSAC, nelle loro parole, rappresenta un riconoscimento internazionale dell’importanza crescente della sicurezza dell’intelligenza artificiale, un tema destinato a diventare centrale man mano che questi sistemi entrano in ambiti sempre più sensibili.

Non a caso, la tecnologia sviluppata dal team è stata rilasciata come open source su GitHub, in linea con l’idea che solo una comunità ampia e consapevole possa affrontare in modo efficace le sfide emergenti. Il messaggio che emerge da questa ricerca è chiaro: nel futuro sviluppo dei grandi modelli linguistici, la sicurezza non potrà più essere considerata un aspetto secondario o successivo, ma dovrà essere integrata fin dalle fondamenta architetturali, soprattutto quando queste fondamenta diventano sempre più modulari e distribuite.