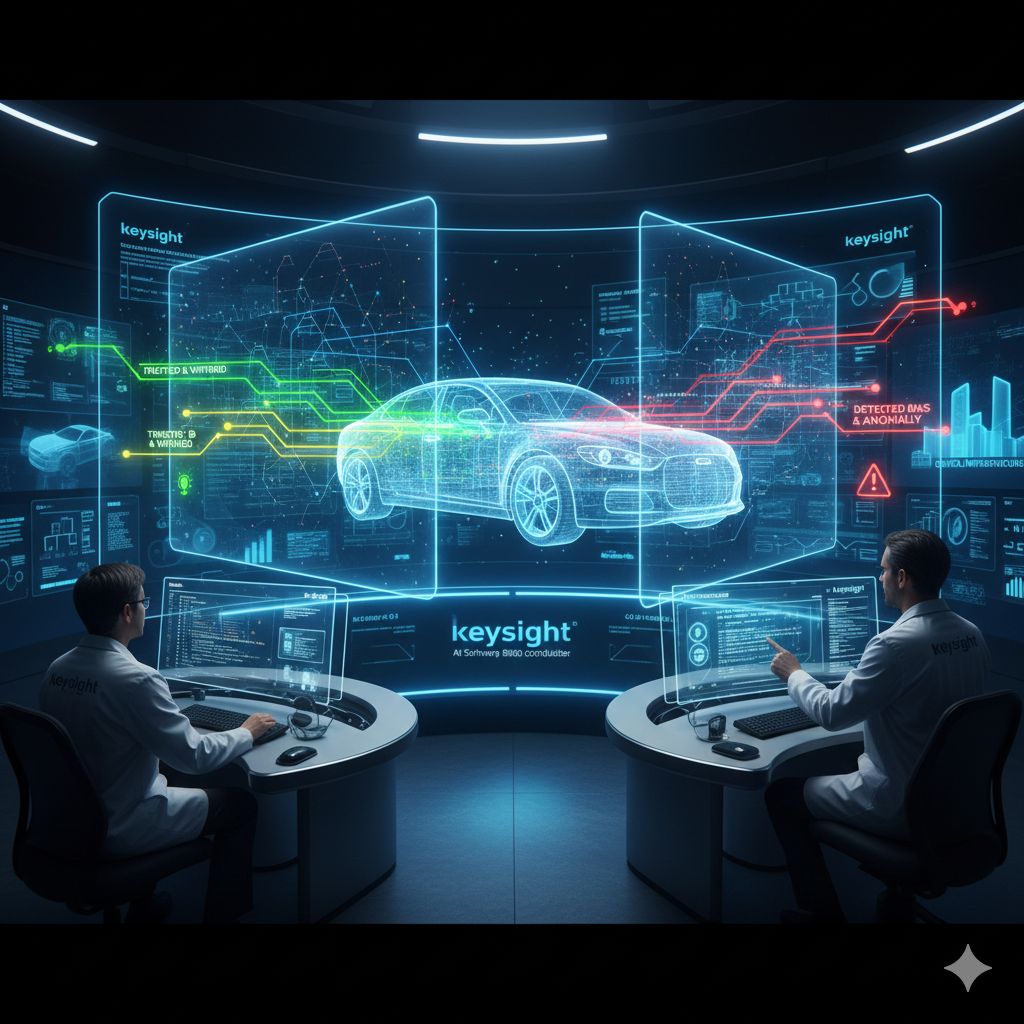

Nel mondo in rapida evoluzione dell’intelligenza artificiale, uno dei problemi più complessi riguarda la fiducia: non tanto la capacità di un algoritmo di fornire risposte, quanto la sicurezza che tali risposte siano affidabili, interpretabili e conformi alle normative soprattutto quando l’AI viene impiegata in contesti dove errori possono avere conseguenze molto gravi. Questo è particolarmente vero in settori come l’automotive, dove le decisioni automatizzate di un sistema possono influenzare direttamente la sicurezza di vite umane, ma anche in ogni ambiente definito “critico per la sicurezza”, dove sistemi intelligenti devono comportarsi in modo prevedibile e conforme. In risposta a queste esigenze e alle crescenti pressioni regolatorie, Keysight Technologies ha annunciato il lancio di un nuovo software chiamato AI Software Integrity Builder, pensato per validare e mantenere sistemi basati su intelligenza artificiale, assicurandone il comportamento sicuro durante tutto il loro ciclo di vita.

Questa soluzione nasce dal riconoscimento di una sfida fondamentale: molti modelli di AI, per quanto sofisticati, operano come scatole nere. Funzionano in modo efficace su dati di addestramento, ma una volta integrati in applicazioni reali, la loro trasparenza rispetto alle decisioni interne è limitata. In settori regolamentati, dove le normative come la ISO/PAS 8800 per l’automotive o l’ormai sempre più stringente EU AI Act richiedono spiegabilità, tracciabilità e validazione, questa mancanza di visibilità diventa un ostacolo serio. Il nuovo software di Keysight mira proprio a colmare questo divario: non solo aiuta gli ingegneri a comprendere meglio cosa accade dentro i modelli, ma offre strumenti per generare prove concrete di conformità normativa, rilevare bias nei dati, individuare lacune o incoerenze e verificare che i comportamenti dei sistemi restino affidabili anche in condizioni reali d’uso.

Alla base di AI Software Integrity Builder c’è l’idea di un approccio unificato alla validazione dell’AI: piuttosto che affidarsi a strumenti disparati che affrontano singoli aspetti del controllo – come l’analisi dei dati o i test isolati sul modello – la soluzione proposta da Keysight copre l’intero ciclo di vita del sistema intelligente. Questo significa che dal momento in cui un modello viene sviluppato e addestrato, passando per la fase di test in ambienti reali, fino alla fase di monitoraggio continuo una volta in produzione, ogni fase è supportata da verifiche e strumenti di controllo che cercano non solo di identificare problemi ma di fornire indicazioni su come migliorare nelle iterazioni future. L’obiettivo, come spiegano i dirigenti dell’azienda, è aiutare i team di sviluppo a spostarsi da metodi di test isolati e frammentati a una strategia coerente di AI assurance, ovvero garanzia di qualità, sicurezza e affidabilità per sistemi complessi.

Uno degli elementi che emergono più chiaramente è l’importanza crescente di trasparenza e spiegabilità nei modelli di intelligenza artificiale. In passato, molte soluzioni AI venivano rilasciate senza strumenti robusti per interpretarne il funzionamento interno, con la conseguenza che le decisioni dei modelli restavano opache anche agli sviluppatori. Questo può causare gravi problemi se, per esempio, un sistema di guida autonoma interpreta erroneamente un segnale stradale o se un algoritmo diagnostico in ambito sanitario ignora pattern critici nei dati. Il software di Keysight analizza la qualità dei dataset impiegati, scopre correlazioni nascoste nei modelli e mette alla prova il comportamento delle funzionalità AI in condizioni reali, simulando scenari che vanno oltre il laboratorio di addestramento. In questo modo gli ingegneri possono non solo osservare, ma comprendere e spiegare i motivi alla base delle decisioni prese dall’AI, cosa che è sempre più richiesta dagli standard internazionali e dai regolatori.

Un’altra dimensione rilevante riguarda il monitoraggio continuo e la capacità di reagire a data drift, cioè a cambiamenti nei dati di input che possono verificarsi col tempo e che rischiano di far deteriorare le prestazioni di un modello. In scenari dinamici, soprattutto nei sistemi di trasporto automatizzato, i comportamenti e le condizioni ambientali cambiano costantemente, e un sistema AI che non è monitorato può assumere comportamenti non previsti. La soluzione di Keysight include strumenti per l’osservazione in tempo reale, in grado di segnalare deviazioni e potenziali problemi di performance, offrendo anche suggerimenti su come intervenire nelle fasi di sviluppo successive per correggere i modelli o i dataset. Questa combinazione di analisi preventiva e risposta adattiva è fondamentale per ridurre i rischi associati all’adozione dell’intelligenza artificiale in contesti dove errori costano molto più di un semplice malfunzionamento.

Di fatto, ciò che Keysight propone con AI Software Integrity Builder è un cambio di paradigma nell’uso e nella gestione degli strumenti di AI nelle applicazioni critiche. Invece di considerare la validazione come un’attività una tantum, limitata alla fase di test pre-rilascio, l’azienda spinge verso un processo di validazione continuo, strutturato e documentato. Questo è particolarmente importante in un’epoca in cui le normative richiedono non solo che un sistema sia sicuro, ma che sia provato e dimostrato conforme attraverso evidenze chiare e auditabili. Rendersi conto di come certe decisioni vengono prese, di come un modello si comporta fuori dall’ambiente di addestramento, e di come intervenire in caso di anomalie diventa quindi un requisito non negoziabile per molte industrie ad alto rischio.