Le 4 migliori alternative a DALL.E, generatori di testo in immagini

DALL·E 2 è stato preferito a DALL·E 1 per la corrispondenza delle didascalie e il fotorealismo.

La creatività è solo connettere le cose, ha detto Steve Jobs: Stava incanalando il suo Einstein interiore (guarda caso un’altra musa di Walter Isaacson), che aveva escogitato un “gioco combinatorio” per spiegare il funzionamento interiore del pensiero creativo. OpenAI ha preso il suggerimento e ha creato un generatore di testo in immagine, DALL.E.

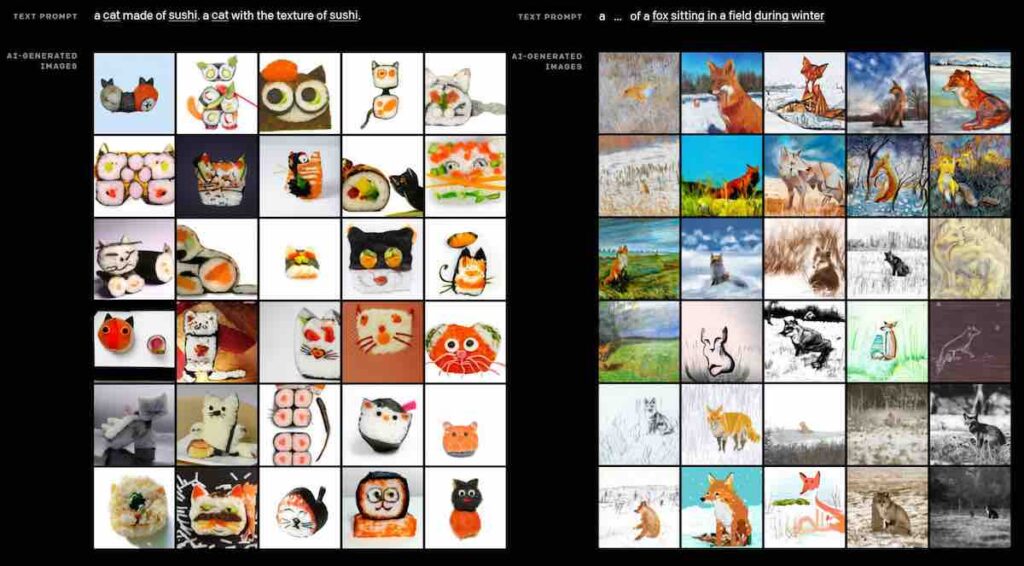

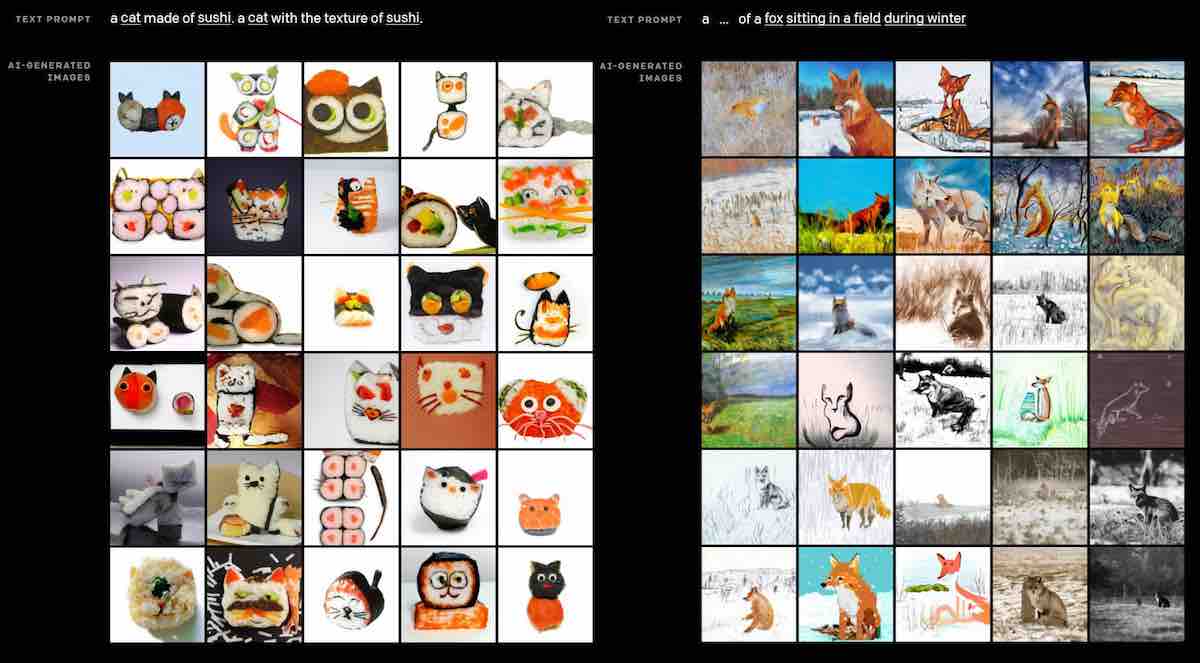

OpenAI ha ridotto la creatività a una scienza. Quasi! L’astronauta a cavallo in uno stile fotorealistico o gli orsacchiotti che mescolano sostanze chimiche scintillanti come uno scienziato pazzo come un cartone animato del sabato mattina degli anni ’90 sono buoni esempi. Il fantasioso DALL.E è diventato in breve tempo il discorso della città. Di seguito, esaminiamo modelli simili che fanno il giro del mondo dell’IA.

DALL.E

Nel 2020, OpenAI ha introdotto GPT-3 e, un anno dopo, DALL.E, un modello da 12 miliardi di parametri, basato su GPT-3. DALL.E è stato addestrato per generare immagini da descrizioni di testo e l’ultima versione, DALL.E 2 , genera immagini ancora più realistiche e accurate con una risoluzione 4 volte migliore. Il modello utilizza didascalie in linguaggio naturale e utilizza un set di dati di accoppiamenti testo-immagine per creare immagini realistiche. Inoltre, può acquisire un’immagine e creare diverse variazioni ispirate alle immagini originali.

DALL.E sfrutta il processo di ‘diffusione’ per apprendere la relazione tra immagini e descrizioni testuali. Nella diffusione, inizia con uno schema di punti casuali e lo segue verso un’immagine quando ne riconosce alcuni aspetti. I modelli di diffusione sono emersi come un promettente quadro di modellazione generativa e promuovono le attività di generazione di immagini e video all’avanguardia. La tecnica di guida viene sfruttata nella diffusione per migliorare la fedeltà del campione per le immagini e il fotorealismo. DALL.E è composto da due parti principali: un autoencoder discreto che rappresenta accuratamente le immagini nello spazio latente compresso e un trasformatore che apprende le correlazioni tra il linguaggio e questa rappresentazione di immagini discrete. Ai valutatori è stato chiesto di confrontare 1.000 generazioni di immagini da ciascun modello e DALL·E 2 è stato preferito a DALL·E 1 per la corrispondenza delle didascalie e il fotorealismo.

DALL-E è attualmente solo un progetto di ricerca e non è disponibile nell’API di OpenAI.

CLIP

In precedenza, il team di ricerca di OpenAI ha introdotto uno strumento di immagini di testo open source, CLIP. La rete neurale Contrastive Language-Image Pre-training è stata addestrata su 400 milioni di coppie di immagini e testo. Lo strumento apprende in modo efficiente concetti visivi dalla supervisione del linguaggio naturale e può essere applicato per la classificazione fornendo i nomi delle categorie visive da riconoscere. In un documento che introduce il modello, OpenAIil team di ricerca ha scritto della capacità di CLIP di eseguire varie attività durante il pre-allenamento, tra cui il riconoscimento dei caratteri degli oggetti (OCR), la geolocalizzazione, il riconoscimento delle azioni e altro ancora. CLIP ha dimostrato di essere altamente efficiente, flessibile e più generalizzato. Inoltre, è molto meno costoso, dato che CLIP si basa su set di dati di coppie testo-immagine già disponibili su Internet. Può adattarsi per eseguire una gamma più ampia di attività di classificazione visiva.

RuDALL.E

ruDALL-E prende una breve descrizione e genera immagini basate su di essa. Il modello comprende un’ampia gamma di concetti e genera immagini e oggetti completamente nuovi che non esistevano nel mondo reale. La versione russa di OpenAI, ruDALL.E, è addestrata su ruGPT-3, che è stato addestrato su 600 GB di testo russo. Il modello russo ruDALL.E vanta 1,3 miliardi di parametri e un tokenizzatore di testo YTTM con un dizionario di 16.000 token. Sfrutta un modello VQGAN personalizzato che converte un’immagine in una sequenza di 32×32 caratteri. Esistono due modelli in esecuzione dello strumento, Malevich (XL) addestrato su 1,3 miliardi di parametri con un codificatore di immagini e Kandinsky (XXL) con 12 miliardi di parametri. Eseguendo il modello precedente con lo stesso input di testo dell’ultimo esempio DALL.E di “una poltrona a forma di avocado”, si è scoperto che ruDALL.E comprendeva la combinazione di sedia e avocado nella funzione di una forma.

X-LXMERT

Creato da AI2 Labs, X-LXMERT è un’estensione di LXMERT, un trasformatore per connessioni visive e linguistiche. Lo strumento viene fornito con perfezionamenti di formazione e capacità di generazione di immagini migliorate, rivaleggiando con modelli specializzati nella generazione di immagini. X-LXMERT ha tre perfezionamenti chiave: discretizzazione delle rappresentazioni visive, utilizzo di un mascheramento uniforme con un’ampia gamma di rapporti di mascheramento e allineamento dei giusti set di dati di pre-allenamento agli obiettivi giusti. Nella pagina del progetto, il team di ricerca X-LXMERT ha spiegato la formazione in quanto tale: “Utilizziamo il campionamento Gibbs per campionare iterativamente le caratteristiche in diverse posizioni spaziali. Contrariamente alla generazione del testo, dove da sinistra a destra è considerato un ordine naturale, non esiste un ordine naturale per la generazione delle immagini”.

GLID-3

GLID-3 è una combinazione di GLIDE di OpenAI, tecnica di diffusione latente e CLIP di OpenAI. Il codice è una versione modificata della diffusione guidata ed è formato su immagini di persone in stile fotografico. È una modalità relativamente più piccola. Rispetto a DALL.E, l’output di GLID-3 è meno capace di immagini fantasiose per determinati prompt.