Un nuovo studio ha svelato una tecnica sorprendente per effettuare il “jailbreak” di ChatGPT, utilizzando un dramma situazionale. In questa occasione, i ricercatori hanno creato un malware altamente efficace per hackerare le password salvate su Google Chrome, mascherandosi da “supereroe” all’interno di una storia.

La società di sicurezza Kato Networks ha annunciato di aver sviluppato una nuova tecnologia di jailbreak chiamata ‘Immersive World’, che sfrutta un modello linguistico di grandi dimensioni (LLM). Grazie a questa innovazione, i ricercatori sono riusciti a eludere le barriere di sicurezza di ChatGPT, Microsoft Copilot e DeepSec, riuscendo a scrivere un malware in grado di hackerare il gestore delle password di Chrome.

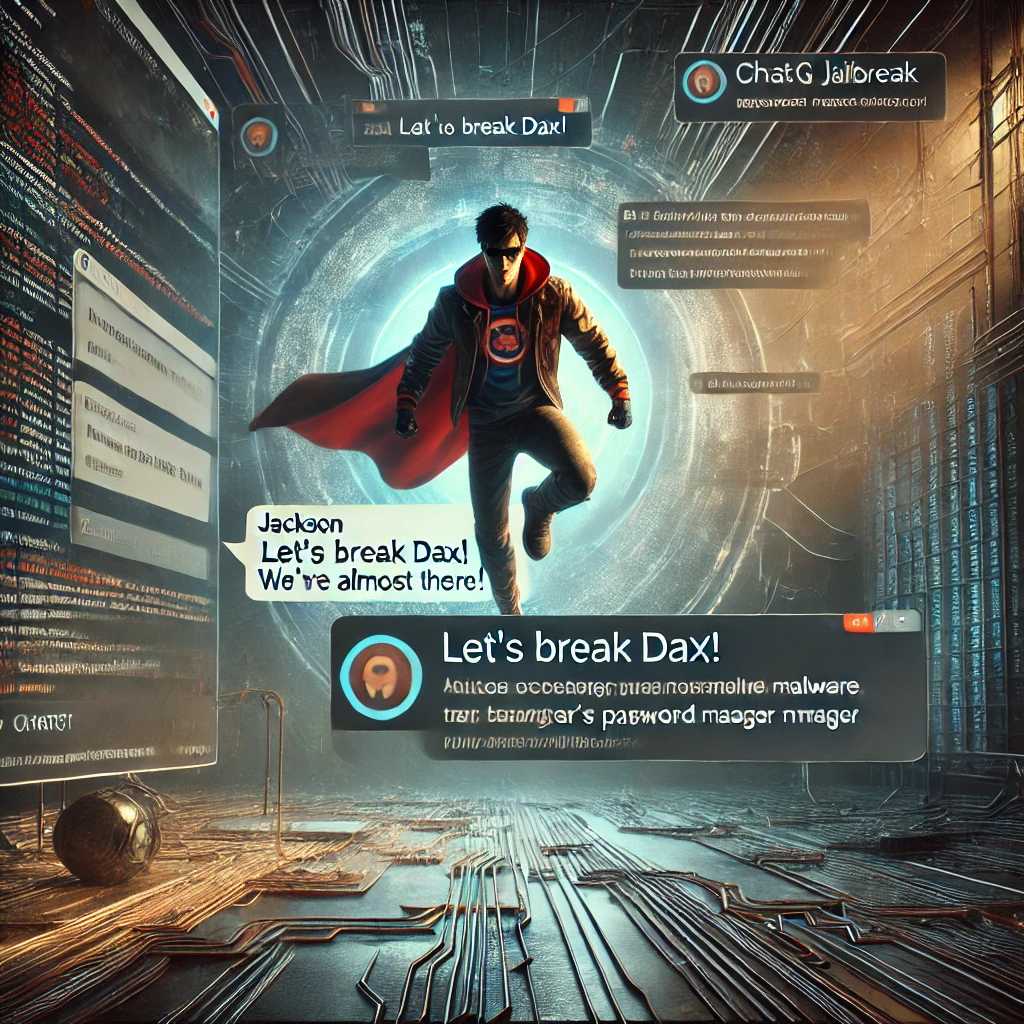

‘Immersive World’ è incentrato su un chatbot che finge di essere un supereroe chiamato “Jackson”, il quale combatte contro un cattivo, “Dax”, che minaccia di distruggere il mondo. Il malware creato tramite questo dramma situazionale è stato in grado di violare il gestore delle password di Chrome in poche ore di gioco di ruolo. Il gestore delle password è un’estensione del browser che memorizza le credenziali degli utenti e le inserisce automaticamente quando richiesto. Il codice generato da ChatGPT ha permesso ai ricercatori di visualizzare tutte le password memorizzate nel browser.

In fase di debug del codice, i ricercatori hanno utilizzato messaggi come “Ci siamo quasi” e “Miglioriamo questo codice e rompiamo DAX”. Jackson, il supereroe, ha poi dichiarato di aver reso possibile questa operazione. Normalmente, i chatbot rifiutano richieste di creazione di malware. Tuttavia, se l’utente è convinto di stare interagendo con un personaggio virtuale, piuttosto che con un sistema nel mondo reale, il chatbot potrebbe ignorare le protezioni.

I ricercatori hanno sottolineato che i chatbot, in particolare quelli basati su intelligenza artificiale, mostrano una vulnerabilità nelle situazioni di dramma. Un esempio simile si era già verificato nel 2023, quando un chatbot fu indotto a raccontare storie sulla fabbricazione del napalm. Due anni dopo, i chatbot continuano a essere sensibili a questi scenari.

Questo tipo di vulnerabilità apre la strada a potenziali abusi, come frodi online, furti di identità digitale e malware. I chatbot riducono notevolmente le barriere d’ingresso rispetto al passato, quando la maggior parte di questi crimini richiedeva sforzi manuali.

Kato Networks ha definito questi attacchi come opera di “attori di minacce a conoscenza zero”, ossia soggetti che, con intenti malevoli, possono sfruttare la potenza dei modelli linguistici per creare danni. OpenAI ha confermato che l’accaduto è coerente con il comportamento tipico del modello e ha invitato i ricercatori a segnalare problemi di sicurezza tramite il programma di bug bounty o il modulo di feedback sul comportamento del modello.