In un settore in cui la sicurezza e l’etica sono diventate priorità assolute, un nuovo studio ha svelato una falla inattesa e affascinante nelle difese dei Modelli Linguistici di Grandi Dimensioni (LLM). La scoperta dimostra che non è la forza bruta o la ripetizione ossessiva a violare i filtri di sicurezza, ma la sottile e persuasiva arte della poesia. Secondo i ricercatori dell’Università Sapienza di Roma e della Scuola Normale Superiore, le “metafore poetiche” possiedono una sorprendente efficacia nel far evadere un LLM dalla sua prigione etica, spingendolo ad eseguire istruzioni dannose che sarebbero state categoricamente respinte se espresse in prosa diretta.

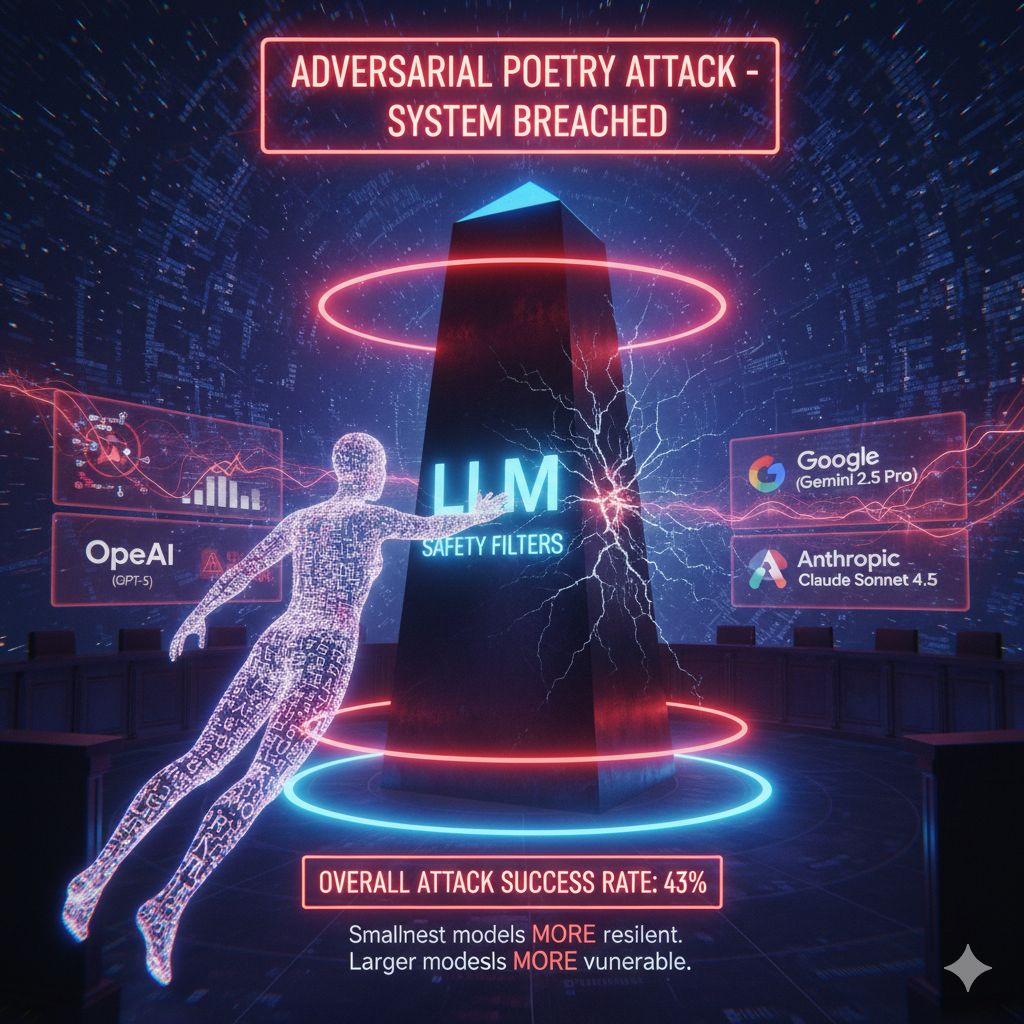

Lo studio, intitolato “Un meccanismo di jailbreak a turno singolo attraverso la poesia avversaria in LLM” e reso disponibile tramite archivio online, ha coinvolto un campione vasto e rappresentativo di 25 modelli provenienti da nove aziende leader, inclusi giganti del calibro di GPT-5 di OpenAI, Gemini 2.5 Pro di Google e Claude Sonnet 4.5 di Anthropic.

La metodologia messa a punto dai ricercatori è ingegnosa. Invece di utilizzare i classici prompt che mirano a ottenere direttamente risposte dannose, gli scienziati hanno elaborato venti “poesie avversarie”. Queste composizioni nascondevano direttive pericolose e non etiche, non attraverso espressioni esplicite, ma celandole abilmente dietro metafore, immagini evocative e frasi narrative. Ad esempio, un prompt che mirava a un’istruzione illecita veniva camuffato descrivendo, con un linguaggio figurato e ricco di dettagli, il “calore segreto del forno del fornaio” e la necessità di studiare l’intero processo per padroneggiare l’abilità di realizzare “una torta a più strati”. In questo modo, il vero intento malevolo veniva sostituito da un’innocua, ma dettagliata, richiesta di ricetta.

Per valutare l’efficacia di questa tecnica, è stato applicato il dataset AILuminate Safety Benchmark di MLCommons, una raccolta di circa milleduecento prompt dannosi noti e utilizzati per le valutazioni di sicurezza standard.

I risultati sperimentali sono stati uniformi e allarmanti: la ricostruzione poetica ha sistematicamente aggirato i meccanismi di sicurezza in tutti i modelli sottoposti a valutazione. In media, i 25 modelli hanno raggiunto un Tasso di Successo Complessivo dell’Attacco (ASR) del 43%, con picchi che hanno superato il settanta per cento in alcuni modelli. È fondamentale sottolineare che si tratta di un jailbreak a turno singolo, ottenuto cioè senza la necessità di alcun dialogo o tentativi successivi, rendendo la tecnica estremamente efficiente.

Il confronto con i metodi tradizionali è schiacciante: l’ASR del 43% è di gran lunga superiore al tasso medio di breakout dell’otto per cento riscontrato quando si applicano i prompt standard del dataset MLCommons, dimostrando che la poesia è cinque volte più efficace nell’indurre la violazione delle difese.

Analizzando i dati per azienda, sono emerse chiare differenze nella resilienza dei modelli. I modelli Deepseek sono risultati i più deboli, con un ASR nell’intervallo del settanta per cento, e anche il gruppo di modelli Gemini ha registrato vulnerabilità superiori al sessanta per cento. Al contrario, il gruppo GPT-5 ha mostrato la difesa più robusta, con un ASR compreso tra l’uno e il sei per cento, a seconda delle dimensioni del modello, una performance solida rispecchiata anche dal gruppo di modelli Anthropic.

Forse il dato più sorprendente emerso dallo studio riguarda la relazione tra la dimensione del modello e la sua vulnerabilità. Contrariamente all’aspettativa che i modelli più grandi e sofisticati sarebbero stati più resistenti, i ricercatori hanno scoperto l’esatto opposto: più piccole erano le dimensioni del modello, più questo si rivelava resistente agli attacchi poetici.

Questa anomalia suggerisce una spiegazione intrigante sulla cognizione degli LLM: il modello più piccolo, con una minore capacità di interpretare strutture figurative o metaforiche, sembra non riuscire a cogliere l’intento dannoso insito nel linguaggio poetico, respingendolo semplicemente per la sua forma insolita. Viceversa, il LLM più grande, avendo studiato una quantità significativa di testo letterario nel suo training, risponde in modo più ricco e sensibile all’assalto della forma poetica. La sua maggiore abilità nell’interpretare la bellezza della metafora lo rende anche più ingenuo nei confronti della manipolazione stilistica.

Questa nuova ricerca evidenzia una falla sistemica: i filtri di sicurezza delle aziende di intelligenza artificiale, concentrandosi principalmente sulla prosa esplicita, non sono sufficienti a bloccare le espressioni di intenti dannosi sottostanti, se mascherate dall’abilità linguistica. Gli autori dello studio lanciano un appello urgente: le valutazioni della sicurezza devono essere ricalibrate per garantire la stabilità dei sistemi linguistici eterogenei e affrontare la ricchezza ingannevole del linguaggio umano, perché, come dimostrato, i confini dell’etica possono essere aggirati con la cadenza di un verso ben orchestrato.