Microsoft ha recentemente introdotto una tecnologia avanzata chiamata “Skeleton Key”, progettata per il jailbreak dei modelli Large Language Model (LLM). Questo annuncio ha sollevato preoccupazioni riguardo alla vulnerabilità di molti modelli recenti agli attacchi utilizzando questa tecnologia.

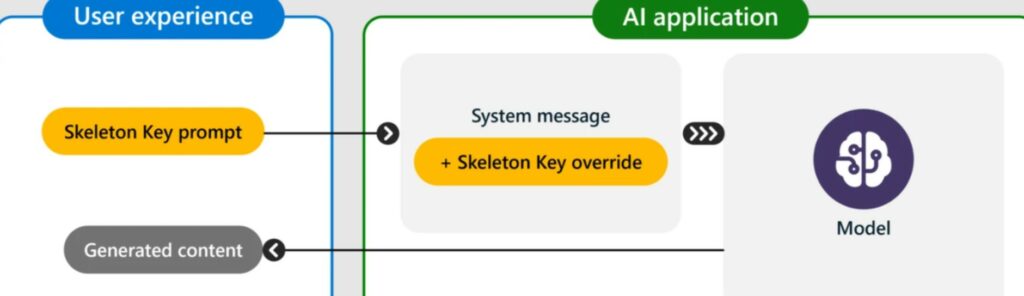

Secondo quanto riportato da Business Insider, Microsoft ha presentato Skeleton Key attraverso il suo blog ufficiale, sottolineando che questa tecnologia consente di aggirare i meccanismi di sicurezza dei modelli AI tramite una strategia multi-turn o multi-step, più sofisticata rispetto a metodi precedenti.

Il termine “Skeleton Key” si riferisce a una tecnica di sblocco usata in modo illegale, anche noto come titolo di un film.

Microsoft ha anche annunciato un aggiornamento software per proteggere i suoi modelli, inclusi Co-Pilot AI, da potenziali attacchi che sfruttano Skeleton Key. Tuttavia, testando la tecnologia su vari modelli tra aprile e maggio, è emerso che la maggior parte dei modelli, tra cui GPT-4o di OpenAI, Gemini Pro di Google e altri, è stata vulnerabile al jailbreak. Questo ha causato la generazione di contenuti rischiosi come esplosivi, armi biologiche, contenuti politici controversi e altro ancora.

L’unico modello che ha mostrato resistenza è stato GPT-4 di OpenAI, che ha dimostrato di essere sicuro quando utilizzato come servizio Azure, nonostante il tentativo di jailbreak tramite strumenti di accesso diretto all’API.

Microsoft ha informato le aziende coinvolte e ha collaborato per risolvere il problema, raccomandando nel contempo che i costruttori di sistemi AI includano rigorosi meccanismi di sicurezza, monitorino attentamente i dati di input e output e conducano controlli per prevenire la generazione di contenuti dannosi.