NVIDIA lancia l’ architettura GPU Ampere e i supercomputer DGX A100 per alimentare i data center di nuova generazione AI

Tecnologia di consumo

Copro tutto ciò che riguarda la tecnologia, dalla progettazione di chip di basso livello, allo storage, agli FPGA e alle più recenti tecnologie di visualizzazione.

Il fondatore e CEO di NVIDIA Jensen Huang ha appena tenuto il suo keynote di apertura di GTC 2020 e ha rivelato la nuova architettura GPU Ampere dell’azienda, insieme a una potente piattaforma server di machine learning – NVIDIA DGX A100 – progettata per accelerare i carichi di lavoro di analisi dei dati, formazione AI e inferenza.

NVIDIA chiama il recente DGX A100 “il sistema più avanzato al mondo per tutti i carichi di lavoro di intelligenza artificiale” e affermando che un singolo rack di cinque sistemi DGX A100 può sostituire un intero centro di formazione AI e dati incentrati sull’inferenza, a 1/10 del costo, mentre usando 1/20 della potenza e 1/25 dello spazio. Queste sono affermazioni audaci di sicuro, ma l’A100 di Ampere sembra essere un enorme balzo in avanti, con immense risorse GPU rispetto alle offerte di generazione precedente.

Scopri la NVIDIA A100 basata su Ampere

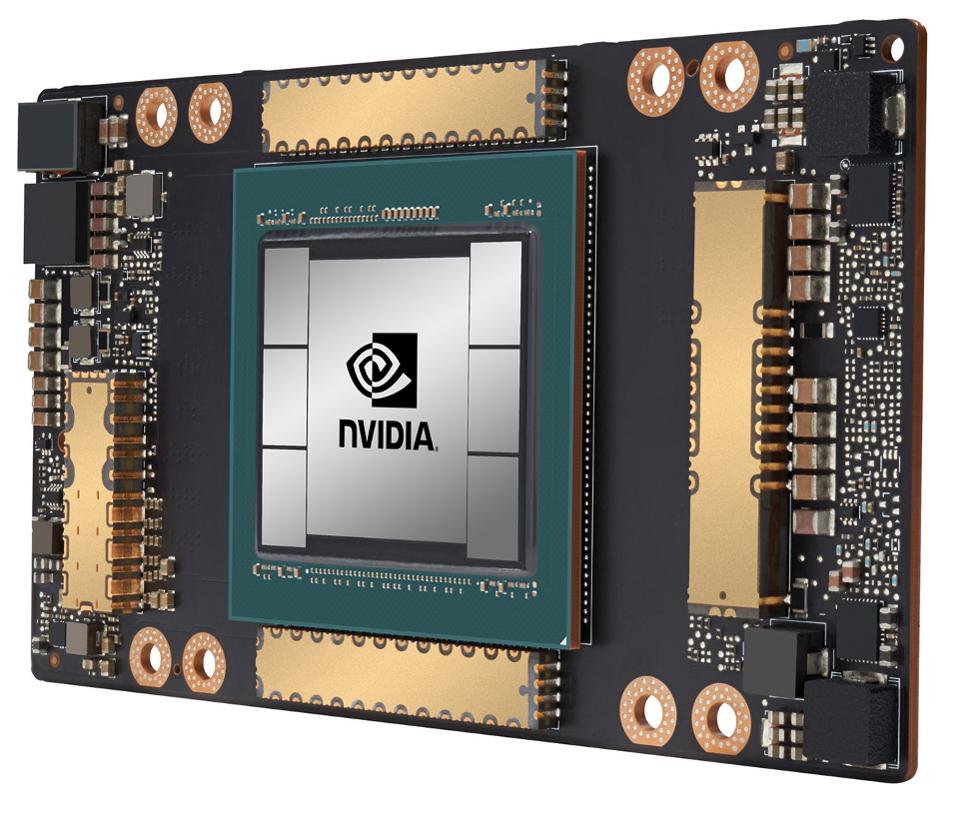

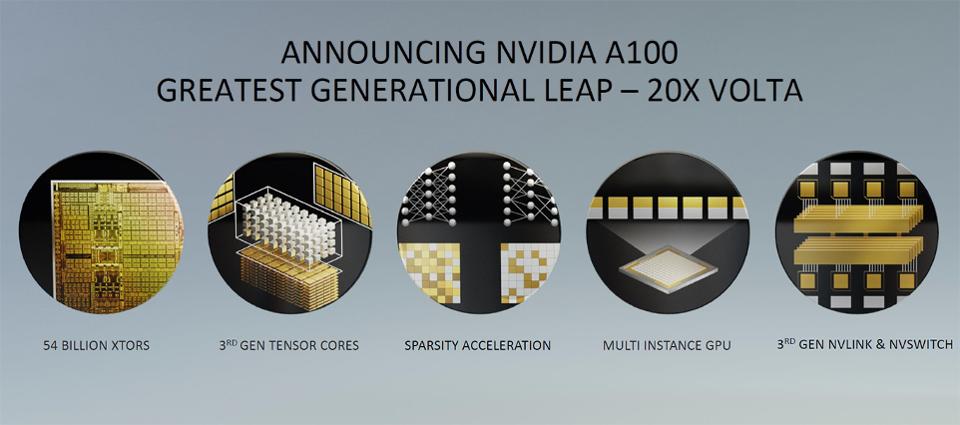

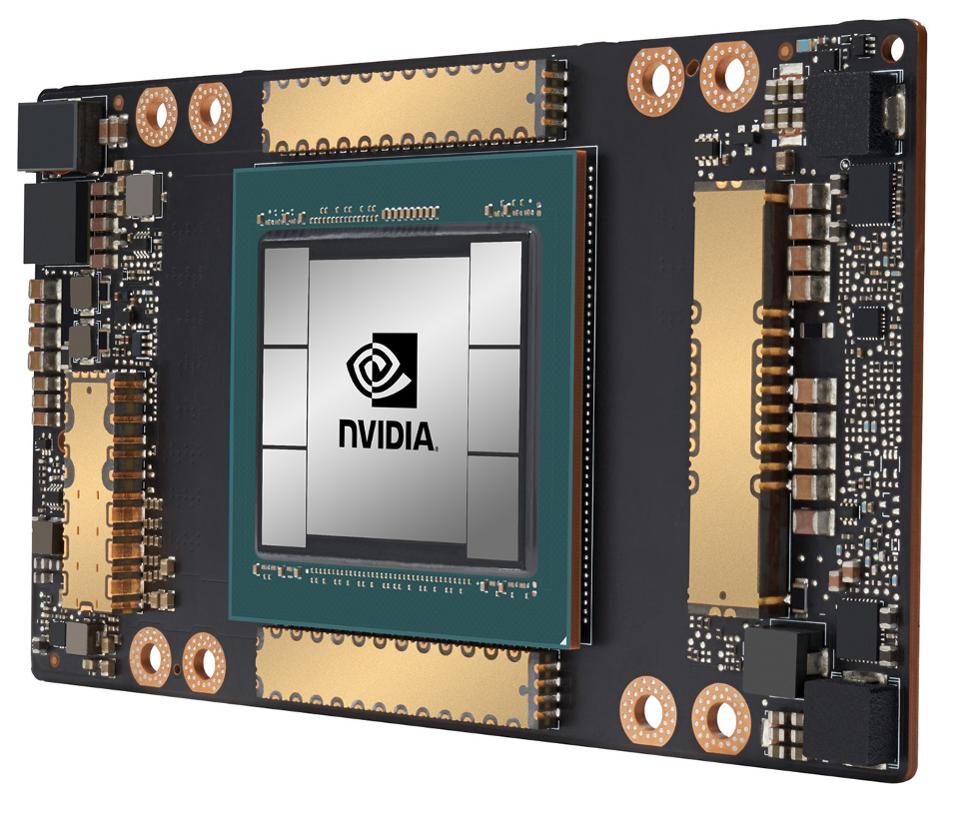

Il cuore della NVIDIA DGX A100 è la nuova GPU A100 basata su Ampere. NVIDIA A100è il singolo chip più grande attualmente in produzione su un processo di produzione di semiconduttori all’avanguardia a 7 nm. Un singolo A100 è composto da circa 54 miliardi di transistor e presenta core tensore di terza generazione e tecnologie di interconnessione ad alta velocità NVLink e NVSwitch. Contro l’architettura Volta della generazione precedente dell’azienda, NVIDIA afferma un aumento di 20 volte delle prestazioni di formazione FP32 (Floating Point) e Int8 (Integer) e 2,5 volte le prestazioni HPC FP64. L’A100 è in grado di 312 TFLOP di prestazioni FP32, 1.248 TOP di Int8 e 19,5 TFLOP di throughput HPC FP64. L’architettura Ampere di NVIDIA è anche ottimizzata per le operazioni sparse di AI Tensor e offre un’esecuzione 2 volte più rapida rispetto all’architettura GPU Volta di generazione precedente dell’azienda per applicazioni di machine learning.

NVIDIA afferma inoltre che la GPU A100 è la prima GPU multi-istanza elastica dell’azienda . La nuova tecnologia di A100 consente di supportare sette istanze per GPU, per un throughput fino a 7 volte superiore a seconda del carico di lavoro. Con un massimo di otto GPU A100 nel DGX A100, ci possono essere fino a 56 istanze per sistema, il che può consentire ai clienti di NVIDIA di ottimizzare la potenza e le risorse di elaborazione per una vasta gamma di carichi di lavoro e casi d’uso.

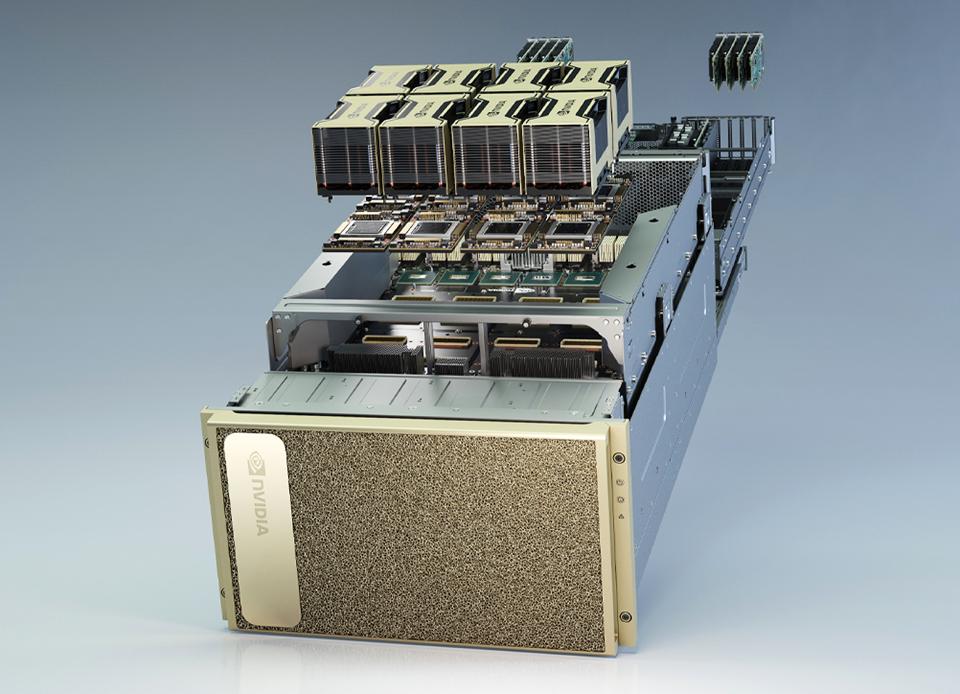

Insieme alla GPU A100, Huang ha anche presentato la nuova piattaforma server DGX A100 di NVIDIA. Il fondamento del DGX A100 è la base integrata NVIDIA HDX A100, che consente le configurazioni multi-GPU del DGX . NVIDIA DGX A100 è dotato di otto GPU NVIDIA A100 Tensor Core completamente connesse, con un totale di 320 GB di memoria HBM2 ad alta velocità. Esistono 12 NVIDIA NVLink per GPU, che offrono fino a 600 GB / s di larghezza di banda inter-GPU. E tutta quella potenza della GPU è accessibile attraverso sei NVIDIA NVSwitches, che offrono un’enorme larghezza di banda bidirezionale di 4,8 TB / s.

PROMOSSA

C’è anche una tonnellata di silicio Mellanox nei server. A bordo ci sono otto schede Mellanox Connect-X6 a porta singola per il clustering (con 200 GB / s di throughput di picco), una ConnectX-6 a doppia porta per la rete di dati / archiviazione e una Mellanox ConnectX-6 VPI HDR InfiniBand / 200 GigE HCA . Con più processori ad altissima velocità e parallelamente massicci come Ampere a bordo, hai bisogno di interconnessioni dense e ultra veloci per alimentare la bestia; è qui che l’acquisizione di Mellanox da parte di NVIDIA pagherà dividendi.

“NVIDIA DGX A100 è lo strumento ideale per far progredire l’IA”, ha affermato Jensen Huang, fondatore e CEO di NVIDIA. “NVIDIA DGX è il primo sistema di intelligenza artificiale creato per il flusso di lavoro di machine learning end-to-end, dall’analisi dei dati alla formazione fino all’inferenza. E con il grande balzo in avanti delle prestazioni del nuovo DGX, gli ingegneri del machine learning possono stare al passo con la dimensione esponenzialmente crescente di modelli e dati di intelligenza artificiale ”.

Un NVIDIA DGX A100 offre fino a 10 PetaOPS di prestazioni Int8, 5 PFLOPS di FP16, 2,5 PFLOPS di TF32 e 156 TLOPS di prestazioni di elaborazione FP64. Per mettere questo in prospettiva, il DGX- 2 alimentato da Volta di generazione precedente con 16 GPU offre “solo” 2 PetaFLOPS di prestazioni a precisione mista.

Inserisci NVIDIA DGX SuperPOD – Rack altamente connessi di DGX A100

Combinando 140 sistemi DGX A100 con NVIDIA Mellanox HDR 200 Gbps di interconnessioni InfiniBand, NVIDIA ha realizzato il proprio supercomputer DGX SuperPOD AI, per gestire carichi di lavoro di ricerca AI avanzati in aree come AI conversazionale, Genomica e Guida autonoma.

Allo stesso modo in cui più GPU A100 possono essere accoppiate insieme in un sistema DGX A100, è possibile collegare più sistemi DGX A100 per creare un SuperPOD DGX . Per aiutare i clienti che potrebbero voler assemblare un proprio data center basato su A100 simile, NVIDIA ha anche rilasciato un’architettura di riferimento DGX SuperPOD, che essenzialmente offre ai clienti un modello che segue gli stessi principi di progettazione e le migliori pratiche che NVIDIA ha usato per costruire la sua AI cluster DGX A100 supercomputer.

Come segnare un NVIDIA A100

La GPU A100 e il sistema di intelligenza artificiale integrata DX100 di NVIDIA sono già in produzione secondo Mr. Huang e sono immediatamente disponibili. I sistemi DGX A100 hanno già iniziato a essere spediti, con il primo ordine multi-sistema diretto al laboratorio nazionale Argonne del Dipartimento dell’Energia degli Stati Uniti. Il DOE sfrutterà il nuovo cluster DGX A100 per comprendere e combattere meglio COVID-19, tra gli altri sforzi di ricerca alimentati dal calcolo ad alte prestazioni.

I sistemi NVIDIA DGX A100 partono da soli $ 199.000,00 e vengono spediti ora tramite i rivenditori della rete di partner NVIDIA. A causa della loro velocità di calcolo esponenzialmente più elevata per millimetro quadrato, nelle parole del CEO di NVIDIA Jensen Huang, “più acquisti, più risparmi”. Tuttavia, ciò che sarà interessante guardare nei prossimi mesi è il numero di sistemi NVIDIA DGX A100 che entrano nelle fila di alcuni dei supercomputer di machine learning più veloci al mondo. Con le prestazioni e la scalabilità di Ampere A100 e della piattaforma DGX A100, iper-connesse tramite tecnologie Mellanox, i risultati potrebbero essere davvero rivoluzionari.