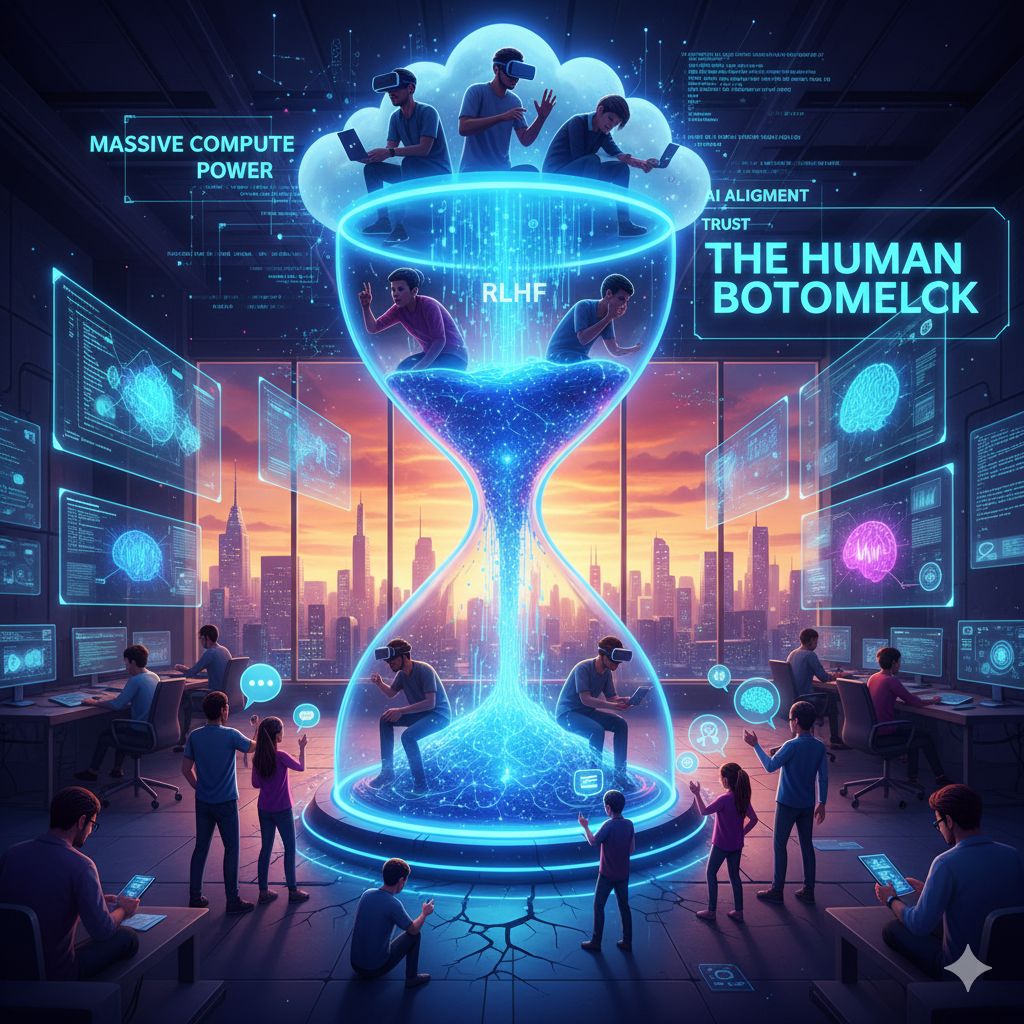

Nel dibattito sulla corsa all’Intelligenza Artificiale Generale (AGI), l’attenzione si è storicamente concentrata su ostacoli di natura tecnica, come la disponibilità di dati massivi o la necessità di una potenza di calcolo sempre maggiore. Tuttavia, una prospettiva emergente, sostenuta da ricercatori di spicco come Alexander Amvirikos, responsabile del prodotto presso OpenAI Codex, suggerisce che il vero e più sottovalutato collo di bottiglia nello sviluppo dell’AI non è più la tecnologia in sé, ma l’essere umano.

Amvirikos ha chiaramente affermato che il fattore limitante è rappresentato dalle persone. Il cuore di questa problematica risiede nell’attuale necessità di un massiccio “feedback umano di alta qualità” per migliorare in modo significativo i modelli di intelligenza artificiale. Questo processo è formalizzato nell’Apprendimento per Rinforzo con Feedback Umano (RLHF), una fase cruciale del training del modello.

Durante l’RLHF, valutatori umani qualificati devono leggere manualmente innumerevoli risposte generate dall’AI, formulare giudizi cognitivi complessi e classificare tali risposte in base a criteri di sicurezza e allineamento valoriale. Questo tipo di giudizio, intrinsecamente basato sul pensiero e sull’etica umana, è lentissimo se paragonato alla velocità di elaborazione dei modelli AI. Ogni iterazione e miglioramento del modello richiede l’assunzione e la gestione di un numero crescente di tali valutatori, traducendosi in costi di manodopera significativi e in un rallentamento drastico della velocità con cui i modelli possono evolvere. In sostanza, la lentezza e il costo di questo processo umano limitano la velocità di iterazione del modello, frapponendosi come un ostacolo sulla strada verso l’AGI.

Ma il problema del “collo di bottiglia umano” non si ferma alla fase di sviluppo; si estende all’applicazione e all’interazione quotidiana con l’AI. Amvirikos ha evidenziato come la velocità con cui gli esseri umani formulano prompt, leggono le risposte generate e prendono decisioni su compiti ripetitivi siano tutti segnali che l’umanità stessa è diventata il limite del sistema. I modelli sono ormai così veloci che l’essere umano, con la sua velocità cognitiva e di elaborazione, non riesce a tenere il passo.

Di conseguenza, il modo in cui interagiamo con l’AI è destinato a subire un cambiamento radicale. Digitare comandi testuali, secondo il ricercatore di OpenAI, apparirà presto obsoleto e inefficiente quanto chiamare un numero verde per ordinare una pizza. La previsione è che, già a partire dal 2026, l’interazione si sposterà verso interfacce più immediate, come il controllo vocale e, in prospettiva, sistemi che si avvicinano alla “lettura del pensiero,” capaci di interpretare le intenzioni umane senza la mediazione di input lenti.

Per superare queste limitazioni, deve cambiare anche il modo in cui l’essere umano verifica l’output del modello. Non è sostenibile aspettarsi che le persone rivedano manualmente ogni singola azione o riga di codice generata da un agente AI. La soluzione risiede nel riprogettare l’intero sistema in modo che gli agenti possano lavorare in autonomia in modo “utile” e affidabile, consentendo notevoli guadagni in termini di efficienza.

Ciò porta alla nuova sfida cruciale dell’AI: l’allineamento. Il problema si sposta dalle pure prestazioni tecniche all’integrazione dei sistemi di valori e delle intenzioni umane. Per sfruttare appieno il potenziale dell’AI, il prossimo grande ostacolo sarà la fiducia: gli esseri umani dovranno essere disposti a delegare compiti complessi e multifunzionali agli agenti AI, un atto che richiede una profonda confidenza nell’allineamento etico e operativo della macchina.

A riprova di questa efficienza, l’intervista ha anche citato il caso di successo interno di OpenAI: lo sviluppo rapidissimo dell’app di condivisione video “Sora” per Android, completata in soli 28 giorni da quattro ingegneri che hanno collaborato strettamente con Codex. In questo progetto, l’agente Codex ha contribuito a generare ben l’85% del codice, dimostrando in modo lampante come l’AI possa già amplificare la produttività umana quando i colli di bottiglia operativi vengono rimossi.