Un sistema d’intelligenza artificiale è capace di risolvere problemi di matematica così complessi da guadagnarsi una medaglia d’oro alle Olimpiadi internazionali della matematica — e poi, con la stessa sicurezza, sbagliare l’addizione di numeri grandi oppure non riuscire a risolvere un semplice esercizio di scuola media. Sembra incredibile, eppure è proprio questa la contraddizione che emerge dallo studio recente che ha coniato il termine “jagged intelligence” (intelligenza frastagliata).

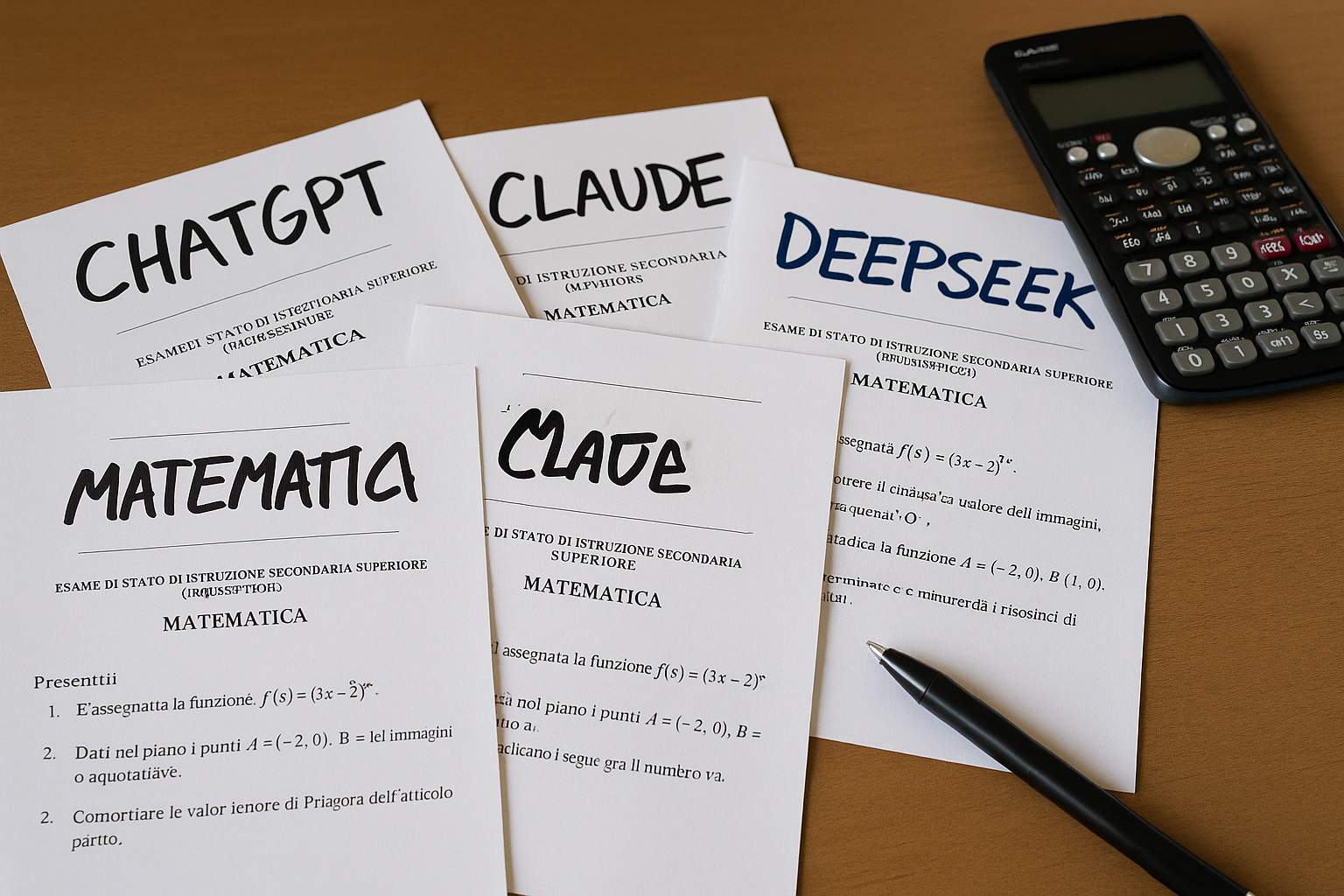

Alcuni modelli AI di punta — sviluppati da DeepMind e OpenAI — hanno conseguito un risultato straordinario: 35 punti su 42 all’International Mathematical Olympiad del 2025, un punteggio tale da portarli al livello delle migliori menti matematiche pre-universitarie del mondo.

È un risultato che da solo basterebbe a segnare una pietra miliare nella storia dell’intelligenza artificiale. Ma la sorpresa arriva quando si osserva come quegli stessi modelli reagiscano a compiti che, per noi umani, sono considerati elementari: moltiplicazioni, sottrazioni, problemi con contesti semplici, sequenze numeriche banali. Spesso i modelli sbagliano. E questo mette in luce qualcosa di profondo riguardo alla natura e ai limiti delle AI odierne.

I problemi dati alle gare olimpiche di matematica sono lunghi da enunciare, articolati, e richiedono intuizione, creatività, gioco con simboli e relazioni astratte. Non si tratta semplicemente di “fare calcoli”, ma piuttosto di fare ragionamenti, vedere connessioni, trovare strategie, costruire dimostrazioni. I modelli AI che partecipano a queste competizioni adottano tecniche sofisticate: rappresentazione simbolica, linguaggi formali (come Lean), apprendimento curricolare (cioè affrontare problemi via via più difficili), esplorazione strategica di soluzioni alternative.

In questo contesto, la matematica appare come un regno ben orchestrato di logica, regole coerenti, strutture che possono essere scandagliate e manipolate. Qui l’AI può sfruttare i suoi punti di forza: individuare schemi, navigare nello spazio delle soluzioni, usare deduzioni sistematiche.

Ma nella “matematica della scuola”, nella vita quotidiana della matematica che si studia nei programmi scolastici, le condizioni cambiano. I problemi spesso coinvolgono interpretazioni testuali, contesti pratici, passaggi intermedi impliciti, numeri grandi messi in modo insolito, richieste di sequenze di operazioni. Non sempre c’è una struttura “nobile” da decifrare: a volte c’è solo una moltiplicazione, o un problema di proporzioni, o un ragionamento aritmetico che richiede “tenere il conto” di più quantità. Ed è lì che molti modelli falliscono.

In altre parole: quando il pattern è chiaro, le regole sono ben definite, le strategie conosciute, l’AI può eccellere. Quando invece la richiesta è “banale ma concreta” — e non appare spesso nei testi matematici di alto livello, o non è pienamente rappresentata nei dati di addestramento — allora la performance precipita.

Al cuore del fenomeno sta l’architettura e il modo di apprendere delle grandi AI linguistiche (LLM, Large Language Models). Queste reti sono progettate per predire la parola successiva in un testo, in base a enormi volumi di dati linguistici. Quando si presenta “2 + 2 =”, il modello probabilisticamente “sa” che “4” è la continuazione più frequente nella sua esperienza testuale. Ma non “capisce” il processo additivo: non interiorizza un algoritmo per sommare numeri arbitrari, non esegue la logica del calcolo, non “esperimenta” la quantità come una grandezza matematica.

In sintesi, questi modelli trattano i numeri come simboli linguistici da predire, non come entità quantitative su cui operare. Ecco perché, quando ci si imbatte in combinazioni o calcoli non presenti nel loro addestramento, la performance crolla.

Un punto centrale è anche il contenuto del dato di addestramento: per la matematica avanzata, ci sono molte risorse strutturate, dimostrazioni, articoli che esplicitano passaggi. Per l’aritmetica quotidiana, invece, raramente troviamo spiegazioni passo dopo passo nei testi online: sono solitamente date le soluzioni finali, rare le ragioni. Ciò lascia l’AI senza “ricetta” per comprendere come si arriva da un numero all’altro.

L’articolo suggerisce anche che, in molti casi, non basta “addestrare più e meglio”: serve un’architettura che sappia distinguere quando usare capacità simboliche, quando appoggiarsi a strumenti di calcolo esterni, quando manipolare le quantità in modo diretto.

Il fenomeno dell’intelligenza frastagliata ha implicazioni concrete per chi progetta AI pratiche. Non possiamo presumere che un’intelligenza artificiale che risolve teoremi complessi sia affidabile per compiti “semplici” che invece richiedono rigore aritmetico. Il rischio è che un sistema venga usato in contesti in cui fallisce silenziosamente: errori di calcolo, ragionamenti contabili, stime sbagliate.

Una strada promettente — già oggetto di ricerca — è quella ibrida: integrare moduli specializzati, ognuno esperto in un tipo di compito (simbolico, aritmetico, linguistico), coordinati da un “cervello” centrale. Un modello linguistico potrebbe riconoscere che un’operazione numerica va delegata a un modulo calcolatore, piuttosto che “tentare” di rispondere. In questo modo si sfruttano i punti di forza di ogni componente e si minimizza il rischio di errori sistematici.

Inoltre, imparare a riconoscere le aree di debolezza di un modello è importante per l’uso responsabile: non basta celebrare i successi, bisogna anche sapere dove l’AI inciampa. È un invito alla cautela: non giudicare un modello solo da ciò che fa bene, ma anche da ciò che fa male.

Infine, riconoscere la natura “non uniforme” dell’intelligenza — umana o artificiale — è forse una lezione filosofica tanto quanto tecnica. Anche noi umani abbiamo competenze brillanti in alcuni campi e debolezze in altri. Che l’AI sia “a tratti geniale e a tratti imperfetta” è un promemoria che il concetto stesso di intelligenza è sfaccettato, non monolitico.