A giugno, il CEO di IBM Arvind Krishna ha scritto , in una lettera al Congresso, che IBM si oppone fermamente e approva l’uso della tecnologia di riconoscimento facciale per la sorveglianza di massa, la profilazione razziale, le violazioni dei diritti umani e delle libertà fondamentali. Il ritiro di IBM è stato seguito dall’annuncio di Amazon di implementare una moratoria di un anno sull’uso della sua tecnologia Rekognition da parte della polizia. In seguito, Microsoft ha annunciato che vieterà alla polizia di utilizzare la sua tecnologia di riconoscimento facciale fino a quando non sarà in vigore una regolamentazione federale.

La tecnologia di riconoscimento facciale (FRT) è una delle applicazioni più dirette dell’intelligenza artificiale con cui il mondo è relativamente più familiare. Il pubblico interagisce con questa tecnologia nella loro vita quotidiana; nei centri commerciali, nelle stazioni locali, nelle scuole e persino tramite i propri dispositivi portatili. La pervasività di questa tecnologia ha portato anche a una situazione ambigua che espone gli aspetti etici dell’utilizzo della tecnologia. L’abuso di questa innovazione è popolare quanto la tecnologia stessa. Ci sono stati numerosi resoconti di divieto della FRT da parte di molti stati solo nell’ultimo anno.

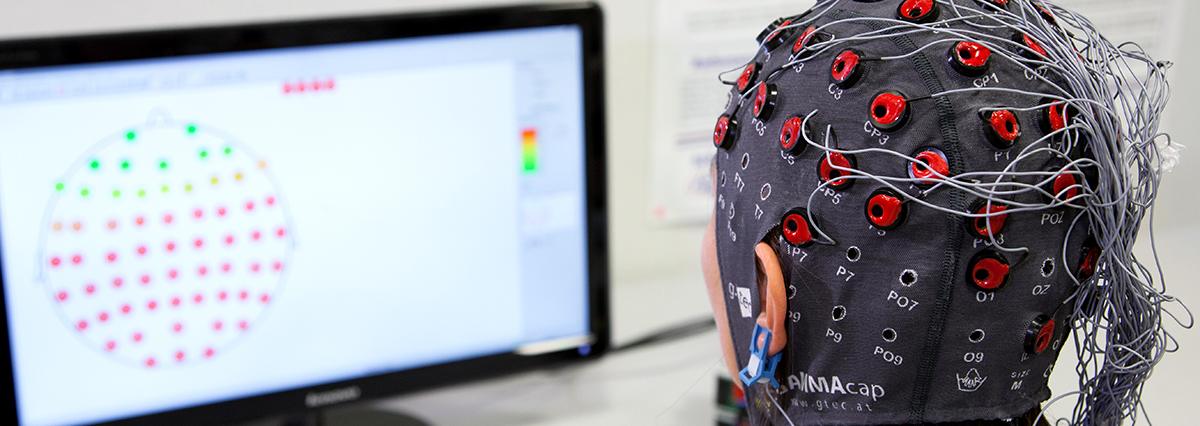

Uno dei motivi principali alla base del diffuso scetticismo è l’inefficienza degli algoritmi; i pregiudizi sono ancora una sfida importante per la comunità ML. Ad esempio, uno studio condotto dal National Institute of Standards and Technology ( NIST ) su 89 dei migliori algoritmi di riconoscimento facciale in commercio, ha mostrato errori nell’abbinare le maschere facciali applicate digitalmente con le foto della stessa persona senza maschera. Di fronte a questo ostacolo socio-culturale e scientifico, è importante capire come si comporta FRT quando viene distribuito in un nuovo scenario.

Per affrontare queste sfide, Stanford ha pubblicato un rapporto che includeva raccomandazioni e valutazioni. Questo rapporto è il risultato di un seminario sull’IA di Stanford condotto a maggio, a cui hanno partecipato i principali scienziati informatici, studiosi di diritto e rappresentanti dell’industria, del governo e della società civile. Lo scopo di questo lavoro, dichiarato dagli autori, è comprendere gli impatti operativi e umani di questa tecnologia emergente e se FRT è pronto o meno per la distribuzione sociale.

Sfide di distribuzione di FRT

Fonte: NIST

“La precisione dell’FRT in un dominio non si traduce nei suoi usi in altri domini.”

Un concetto centrale dell’attuale apprendimento automatico è che le garanzie di accuratezza sono in gran parte specifiche del dominio: buone prestazioni su un certo tipo di dati immagine non si traducono necessariamente in un altro tipo di dati immagine . Il ruolo centrale dell’accuratezza in questi dibattiti, hanno scritto gli autori, probabilmente spiega perché così tanta legislazione proposta ha richiesto valutazioni rigorose delle prestazioni. Gli autori hanno classificato le sfide legate alla distribuzione di sistemi FRT efficienti come: spostamento del dominio e spostamento istituzionale.

Quando si tratta di tecnologia di riconoscimento facciale, il cambio di dominio deriva dalla differenza tra i tipi di immagini utilizzate dai fornitori e dai revisori di terze parti per addestrare i modelli e testare le prestazioni e i tipi di immagini utilizzate dai consumatori FRT per eseguire le attività desiderate. Sebbene i set di dati utilizzati dai fornitori non siano divulgati, c’è motivo di ritenere che ci siano differenze sostanziali tra le immagini del fornitore e dell’utente: possono avere proprietà del viso diverse, come il colore della pelle, il colore dei capelli, le acconciature, gli occhiali, i peli del viso e l’età, l’illuminazione , sfocatura, ritaglio, qualità, quantità di viso coperto, ecc. È probabile che le immagini dei fornitori e degli utenti provengano da distribuzioni diverse.

Considerando che, il cambiamento istituzionale può anche portare a differenze di prestazioni. Ciò può sorgere a causa di incomprensioni della tecnologia da parte degli utenti, sovrastimando l’efficacia del sistema e altro ancora. Sottolineando quanto siano diversi lo sviluppo e la distribuzione dei modelli ML, gli autori hanno spiegato che i fornitori di FRT addestrano le loro immagini con immagini ben illuminate e chiare e con un corretto utilizzo del software da parte di professionisti dell’apprendimento automatico, ma durante la distribuzione, i clienti come le forze dell’ordine possono utilizzare FRT basato su video in diretta nelle telecamere del corpo della polizia, successivamente valutati da agenti senza formazione tecnica.

Allora, come risolvere queste vistose lacune? Sebbene il rapporto di Stanford si allontani dall’offrire soluzioni tecniche specifiche, data l’incertezza, ha tuttavia poche raccomandazioni che possono servire come guida all’implementazione.

Quando si utilizzano set di dati pubblici, i fornitori e le terze parti dovrebbero mantenere un elenco aggiornato dei set di dati utilizzati per ciascuna versione del software.

Per i set di dati privati, le parti dovrebbero divulgare i dati completi di formazione / test, insieme alla documentazione.

I fornitori dovrebbero consentire agli utenti di etichettare i propri dati e testare i modelli di riconoscimento facciale del fornitore utilizzando tali dati.

I fornitori dovrebbero quindi fornire note di rilascio dettagliate che includano modifiche ai dati di addestramento, algoritmi di addestramento, parametri, vincoli di equità e qualsiasi altro aspetto che potrebbe influenzare le prestazioni.

Gli utenti non devono fare affidamento esclusivamente sui benchmark NIST che potrebbero non riflettere le prestazioni nel dominio per il quale viene acquistato un sistema FRT.

Gli autori hanno anche riconosciuto il ruolo delle organizzazioni dei media, dei giornalisti investigativi e altri nella discussione sull’uso dell’IA in contesti rivolti al pubblico e perché sono importanti in futuro. “Riteniamo che l’adozione delle raccomandazioni di cui sopra – per regolamento, contratto o norma – contribuirà molto a migliorare la nostra comprensione, riflessione e considerazione di una delle più importanti applicazioni emergenti dell’IA oggi”, ha concluso il rapporto.