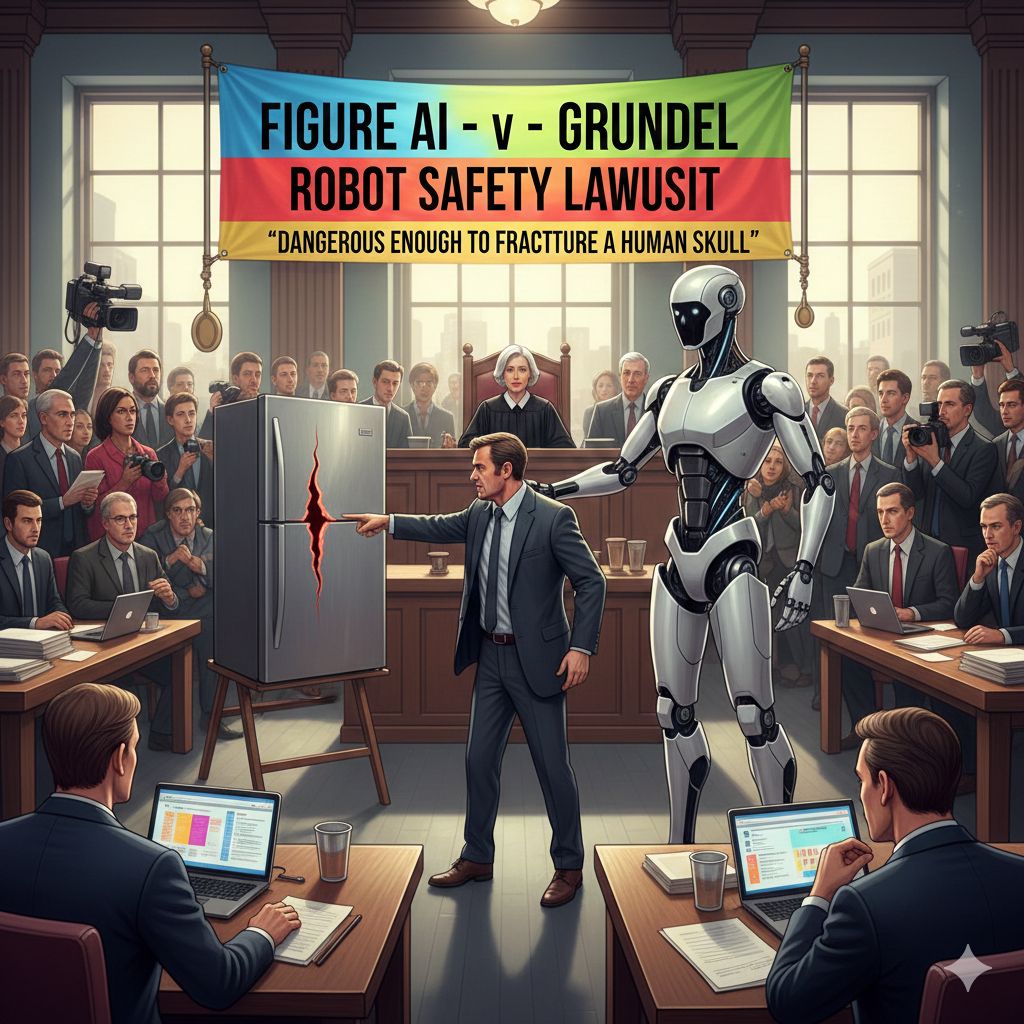

La corsa allo sviluppo di robot umanoidi da impiegare in ambienti non industriali ha appena incontrato un significativo ostacolo legale ed etico. Figure AI, una delle startup più in vista nel settore della robotica domestica, è stata citata in giudizio in una causa per licenziamento ingiusto. A intentare l’azione è Robert Grundel, l’ex responsabile della sicurezza dei prodotti, il quale sostiene di essere stato allontanato dall’azienda poco dopo aver lanciato un allarme esplicito e drammatico: i robot di Figure erano “abbastanza pericolosi da fratturare il cranio umano”.

Secondo quanto riportato dalla CNBC, Grundel ha presentato la denuncia presso la corte federale della California settentrionale, sostenendo che il suo licenziamento, avvenuto a settembre, sia stata una diretta ritorsione per aver parlato apertamente dei rischi per la sicurezza dei prodotti.

Nella denuncia si legge che Grundel, in qualità di ex ingegnere capo della sicurezza, aveva ripetutamente messo in guardia il CEO di Figure, Brett Adcock, e l’ingegnere capo Kyle Edelberg, sulla natura estremamente pericolosa del robot. Un incidente specifico citato nella causa, dove un robot in fase di malfunzionamento aveva lasciato un taglio profondo di circa 0,6 centimetri in una porta d’acciaio di un frigorifero, è stato utilizzato come prova della forza distruttiva e della potenziale minaccia dell’automa.

L’ex dirigente ha inoltre contestato la drastica riduzione della “roadmap di sicurezza” che gli era stata incaricata di preparare per gli investitori. Grundel sostiene che l’azione dell’azienda ha minato il piano di sicurezza che era destinato a influenzare le decisioni di investimento, e che tale condotta potesse essere “interpretata come frode”. I suoi avvertimenti, secondo la sua versione, sono stati ignorati e trattati come un ostacolo, e la motivazione ufficiale del suo licenziamento — un “cambio poco chiaro di direzione aziendale” — sarebbe stata semplicemente una scusa.

L’azienda, dal canto suo, ha respinto con fermezza le accuse. Un portavoce di Figure ha dichiarato in una nota via email che “Grundel è stato licenziato per scarso rendimento” e che “le sue affermazioni sono false e saranno pienamente confermate in tribunale”.

Tuttavia, il caso ha un potenziale significato che va oltre il singolo contenzioso. L’avvocato di Grundel, Robert Ottinger, ha sottolineato come la legge californiana offra una protezione robusta ai dipendenti che segnalano pratiche non sicure. Ottinger ha aggiunto che questo potrebbe diventare uno dei primi casi di whistleblowing nel campo della sicurezza dei robot umanoidi. Ha chiarito l’intento della causa, affermando che il tribunale ha il potere di “rivelare come il rapido sviluppo di un’azienda leader di mercato rappresenti un rischio pubblico significativo”.

Il caso legale getta una luce critica sulla fretta che caratterizza lo sviluppo tecnologico in un settore ancora nascente. Figure AI è una delle poche aziende che si sta concentrando intensamente sui robot destinati all’ambiente domestico, in contrasto con le aziende che mirano a implementare gli umanoidi primariamente nelle fabbriche.

Gli esperti del settore concordano sul fatto che l’introduzione su vasta scala dei robot umanoidi nelle case richiederà ancora diversi anni. Ciò è dovuto in gran parte a problemi irrisolti che includono, oltre alle sfide relative alla sicurezza e alla privacy, la necessità di affrontare gli ambienti domestici complessi e imprevedibili, molto più caotici e meno strutturati di un impianto industriale. Il contenzioso con l’ex responsabile della sicurezza di Figure AI non fa che rafforzare l’avvertimento degli esperti, trasformando la preoccupazione teorica sul potenziale pericolo dei robot in un’immediata e scottante questione legale. Il risultato di questo caso potrebbe stabilire un precedente fondamentale, definendo i futuri standard di sicurezza e l’obbligo di trasparenza per i produttori di robotica umanoide.