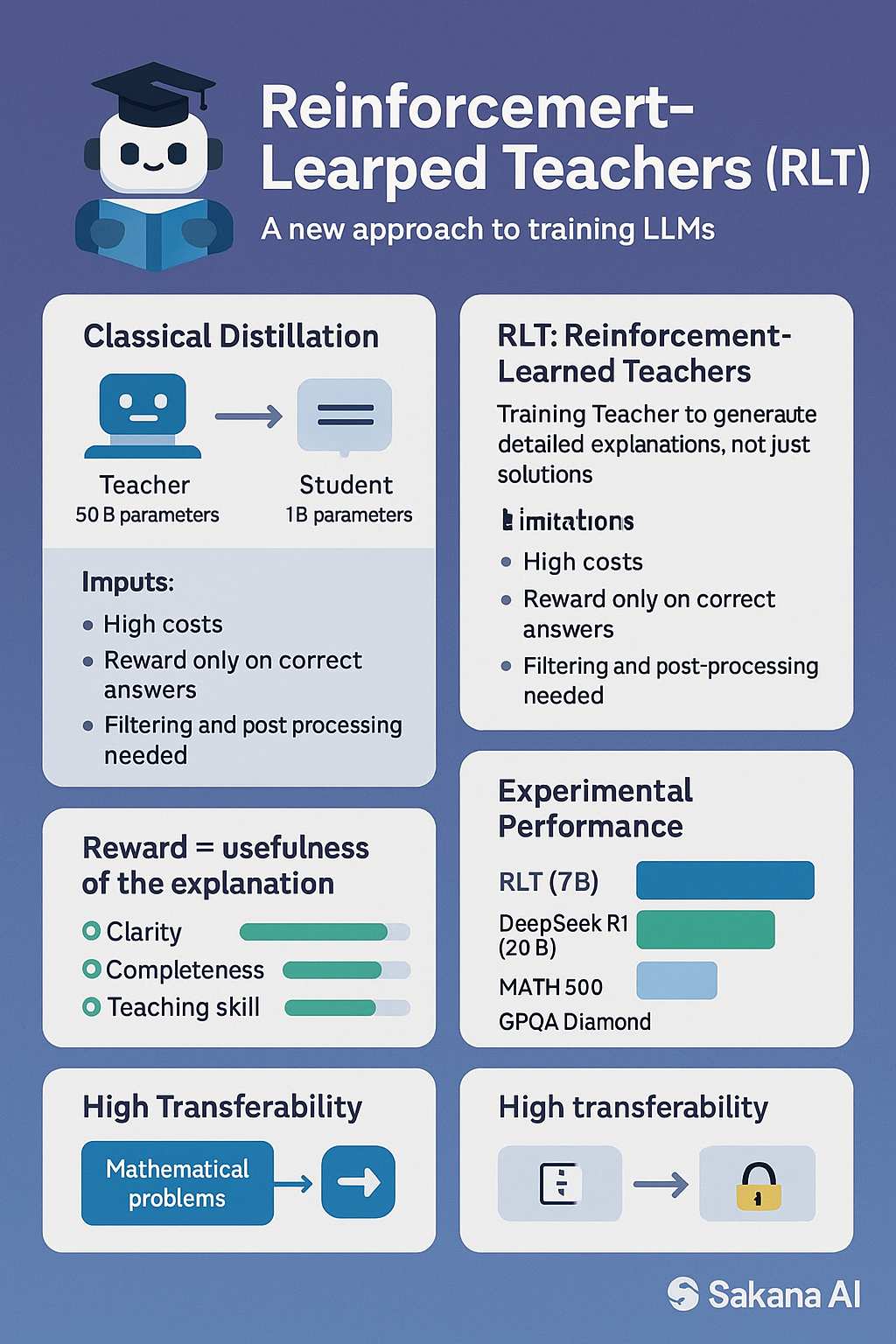

Sakana AI ha introdotto un innovativo approccio all’apprendimento dei modelli linguistici di grandi dimensioni (LLM), denominato “Reinforcement-Learned Teachers” (RLT). Questo metodo si distingue dalle tradizionali tecniche di distillazione, focalizzandosi non solo sulla capacità di risolvere problemi, ma anche sull’efficacia delle spiegazioni fornite dal modello insegnante.

Nel tradizionale approccio di distillazione, un modello insegnante di grandi dimensioni apprende a risolvere problemi complessi e successivamente trasmette queste conoscenze a un modello studente più piccolo. Tuttavia, questo processo è spesso lento e costoso, poiché le ricompense vengono assegnate solo in caso di risposta corretta, richiedendo ulteriori interventi per filtrare e post-elaborare l’output.

Il framework RLT propone un cambiamento di paradigma: invece di addestrare il modello studente a risolvere il problema dall’inizio, si addestra il modello insegnante a generare spiegazioni dettagliate e comprensibili, dato sia il problema che la soluzione corretta. In questo modo, l’insegnante diventa un “insegnante esperto”, fornendo spiegazioni passo dopo passo che facilitano l’apprendimento del modello studente.

Il modello insegnante viene premiato in base alla capacità delle sue spiegazioni di aiutare il modello studente a comprendere e riprodurre correttamente la soluzione. Questo approccio consente l’uso di modelli insegnanti più piccoli ed efficienti, che possono essere efficaci nel trasferire capacità di ragionamento anche a modelli studente di dimensioni superiori.

I risultati sperimentali hanno mostrato che un modello RLT con 7 miliardi di parametri ha superato le prestazioni di modelli significativamente più grandi, come DeepSeek-R1, su benchmark come l’American Invitational Mathematics Examination (AIME) 2024, MATH 500 e GPQA Diamond. Inoltre, l’RLT ha dimostrato un’elevata efficacia anche nel processo di bootstrap, migliorando le prestazioni di apprendimento del modello studente.

Questo approccio ha anche evidenziato una maggiore trasferibilità delle capacità esplicative: un modello RLT addestrato su problemi matematici ha applicato con successo le sue competenze a compiti completamente diversi, come il problema del “conto alla rovescia” basato sull’aritmetica. Ciò suggerisce che la capacità di spiegare il processo di risoluzione dei problemi ha una maggiore trasferibilità rispetto alla capacità di risolvere il problema direttamente.