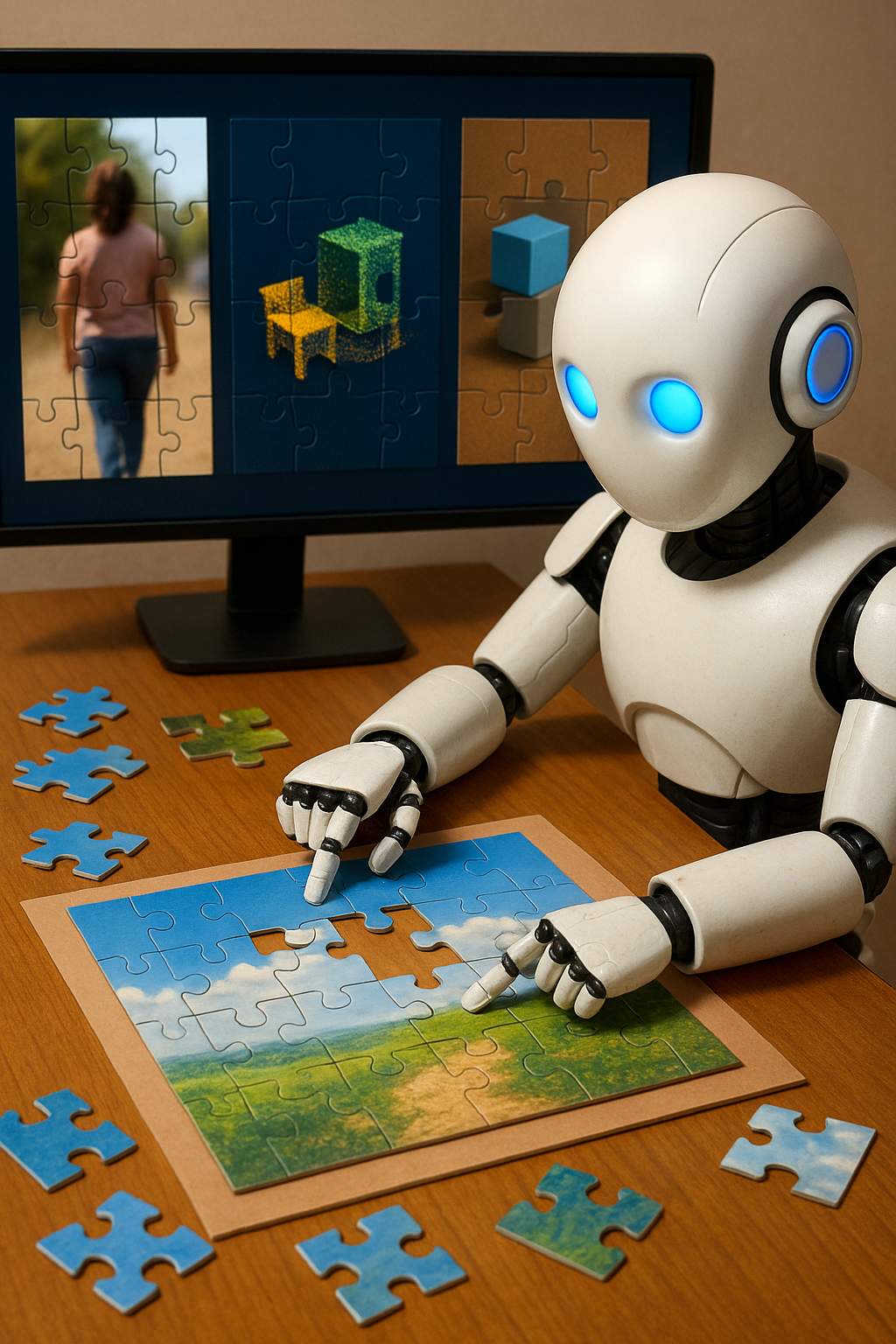

In un recente articolo di Unite.AI si racconta di un’idea quasi poetica: insegnare alle intelligenze artificiali a migliorare la loro visione e il ragionamento visivo chiedendo loro di risolvere puzzle, come se fossero giochi di immagini, video o persino scene 3D.

L’articolo esplora un lavoro di ricerca che dimostra come, con un opportuno addestramento, i modelli multimodali (i cosiddetti MLLM, ossia modelli linguistici in grado di trattare anche dati visivi) siano in grado di affinare la propria capacità di comprendere strutture visive complesse semplicemente “ricomponendo pezzi”.

L’idea non è tanto di far costruire all’IA delle immagini come farebbe un artista, ma di farle risolvere compiti di “riordino” che richiedono di ricostruire il senso spaziale, la sequenza temporale o la profondità delle parti che le compongono. In pratica, le immagini (o video, o dati 3D) vengono frammentate in pezzi — parti di immagine, segmenti video, punti con profondità — mescolate, e l’algoritmo deve scoprire come rimetterle nel giusto ordine. Il metodo è chiamato Visual Jigsaw e si inserisce come un processo di post-addestramento, cioè un affinamento dopo che il modello ha già acquisito competenze generali.

Nel dettaglio, i ricercatori hanno definito tre “modalità” in cui il puzzle viene applicato: immagini, video e 3D. Nel caso di immagini, una foto viene sezionata in griglia, i tasselli confusi e il modello deve rispondere a quale permutazione riporta alla disposizione originaria. Nel video, sequenze temporali vengono spezzate in clip e presentate in ordine confuso, e l’obiettivo è ripristinarne la successione corretta. Per il 3D, invece, si lavora con dati RGB-D — immagini con informazione di profondità — dove punti con diverse “distanze” vengono mescolati e l’IA deve stabilire la sequenza corretta dalla profondità minore alla maggiore.

Un aspetto particolarmente elegante è che tutto questo avviene senza bisogno di altre reti ausiliarie, senza annotazioni manuali, senza moduli visuali esterni: il sistema è progettato come un reinforcement learning con ricompense verificabili (RLVR, Reinforcement Learning from Verifiable Rewards), in cui il modello viene premiato in modo scalare — non solo “giusto o sbagliato”, ma anche parzialmente corretto — in base a quanto la sua soluzione si avvicina all’ordine vero. In più, il sistema richiede che il modello formuli il ragionamento in modo strutturato (uso di tag e ) e riceve bonus addizionali se rispetta queste convenzioni.

Ma quali risultati realmente emergono da tutto questo? Ebbene, i test condotti mostrano che il metodo Visual Jigsaw apporta miglioramenti coerenti in diversi benchmark: la modalità “immagine” potenzia la percezione fine, la comprensione spaziale e la capacità compositiva; la modalità “video” migliora la capacità di ragionare sull’ordine temporale, riconoscere relazioni tra clip e la coerenza narrativa; la modalità “3D” rafforza l’abilità di interpretare la struttura profonda dello spazio, anche in input monoculari. In ogni caso, queste migliorie emergono senza che l’architettura base del modello venga alterata — solo tramite questo “gioco di ricomposizione” aggiuntivo.

Lo studio riflette anche sul fatto che questo metodo pone una “ponte” tra il visivo e il semantico: pur lavorando con strutture visive, l’approccio fa leva sulle capacità linguistiche del modello per guidare la ricostruzione semantica dell’immagine, e suggerisce che il confine tra comprendere “cosa vedo” e “cosa significa” può essere spostato verso una sintesi più stretta tra visione e linguaggio. È un’idea che richiama il modo in cui anche noi, quando eravamo piccoli, imparavamo a vedere meglio combinando osservazione, ricomposizione e tentativi.